مدلهای زبان بزرگ (LLM) مانند ChatGPT نمادی از پیشرفت شگرف در حوزه هوش مصنوعی هستند. این مدلها امکان درک و تولید متن به شیوهای مشابه انسان را برای ماشینها فراهم میکنند. از اصول اولیه مدلسازی زبان مبتنی بر احتمال تا استفاده از معماریهای پیچیده شبکههای عصبی، مدلهای زبان بزرگ نتیجه دههها تلاش و نوآوری در این زمینه هستند.

سیر تکامل مدلهای زبان بزرگ: از N-گرامها تا شبکههای عصبی

مدلهای زبان بزرگ (LLM) نحوهی تعامل ما با فناوری را متحول کردهاند. اما ریشههای این فناوری، عمیقتر از آن چیزی است که بسیاری میپندارند. ابزارهای مدرنی مانند ChatGPT انقلابی به نظر میرسند، اما بر پایهی دههها پژوهش و پیشرفت گامبهگام در پردازش زبان طبیعی (NLP) بنا شدهاند.

فهم مدلهای زبان

مدلهای زبان، در اصل، نمایشهای ریاضی هستند. این مدلها برای پیشبینی احتمال توالی کلمات طراحی شدهاند. برای مثال، احتمال جملهای مانند «گربه عمیقا خوابیده است» بسیار بیشتر از رشتهی بیمعنی «کتابخانه یا کوانتومی» است. این توانایی در سنجش احتمالات، به مدلهای زبان امکان میدهد تا هم متن منسجم را درک کنند و هم متن جدید تولید کنند.

اگر تاکنون از قابلیت پیشبینی متن در تلفن همراه خود استفاده کرده باشید یا با یک دستیار صوتی هوشمند تعامل داشته باشید، در واقع با این مدلها در عمل آشنا شدهاید. این فناوریهای روزمره برای پیشبینی کلمهی بعدی شما یا پاسخ به پرسشهایتان، بر پایه اشکال ابتدایی مدلسازی زبان استوار هستند.

روشهای اولیه: N-گرامها

مفهوم مدلسازی زبان در سال ۱۹۵۱ با معرفی n-گرامها توسط کلود شانون آغاز شد. n-گرامها، توالیهایی از کلمات مانند «ماشین قدیمی» یا «گربه عمیقا خوابیده است» هستند. این مدلها احتمال n-گرامها را با تحلیل متنهای موجود محاسبه میکنند. با این حال، با افزایش طول n-گرامها، تخمین احتمال آنها به صورت تصاعدی دشوارتر میشود.

این محدودیت باعث میشد مدلهای اولیهی زبان در درک روابط بین کلماتی که در جمله از هم فاصله داشتند، با مشکل مواجه شوند. در نتیجه، این سیستمها اغلب هنگام تولید متن، خروجیهایی ناقص یا نامنسجم تولید میکردند.

شبکههای عصبی: تحولی شگرف

برای رفع این کاستیها، پژوهشگران مدلهای مبتنی بر شبکهی عصبی را با الهام از ساختار مغز انسان توسعه دادند. این مدلها میتوانستند ارتباطات میان کلمات دور از هم را بهتر نمایش دهند. این امر به دلیل استفاده از پارامترها – مقادیر عددی که درک شبکه از الگوهای زبان را هدایت میکنند- ممکن شد.

آموزش این شبکههای عصبی شامل تحلیل حجم عظیمی از دادههای متنی برای تنظیم پارامترهای آنهاست. این کار آنها را قادر میسازد تا کلمه بعدی را با دقت بیشتری پیشبینی کنند. در حالی که شبکههای عصبی اولیه مؤثر بودند، هنوز با چالشهایی روبرو بودند، به ویژه در پردازش کلمات به صورت متوالی، که آموزش را کند میکرد.

ظهور ترانسفورمرها

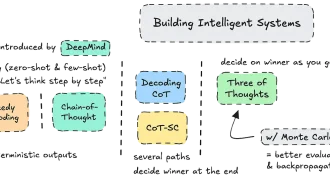

در سال ۲۰۱۷، با معرفی شبکههای عصبی ترانسفورمر، پیشرفتی بزرگ حاصل شد. ترانسفورمرها با پردازش همزمان تمامی کلمات در یک جمله، به جای پردازش متوالی، پردازش زبان طبیعی را متحول کردند. این پردازش موازی نه تنها آموزش را سریعتر کرد، بلکه به ترانسفورمرها اجازه داد تا مجموعه دادههای بسیار بزرگتری را تحلیل کنند.

مزایای کلیدی ترانسفورمرها

- مقیاسپذیری: ترانسفورمرها قابلیت آموزش بر روی چندین رایانه را دارند و این امر آنها را قادر میسازد تا مجموعه دادههای بسیار بزرگ را به طور مؤثر مدیریت کنند.

- چندکارگی: ترانسفورمرها فراتر از پیشبینی کلمهی بعدی، میتوانند وظایفی مانند کامل کردن کلمات از دست رفته یا تعیین روابط بین جملات را انجام دهند. این قابلیتها آنها را با طیف وسیعی از کاربردها سازگار میکند.

مدلهای زبان بزرگ مدرن

ترانسفورمرها راه را برای مدلهای زبان بزرگ امروزی هموار کردند، که با مقیاس عظیم و قابلیتهای چشمگیر خود شناخته میشوند. این سیستمها بر روی تریلیونها کلمه آموزش دیدهاند – حجمی آنقدر زیاد که خواندن آن برای یک فرد عادی هزاران سال طول میکشد.

ویژگیهای LLMها

- شبکههای عصبی عظیم: برخی از مدلها بیش از ۱۰۰ میلیارد پارامتر دارند که به آنها امکان درک الگوهای پیچیدهی زبان را میدهد.

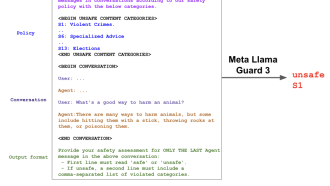

- دستورات تعاملی: کاربران میتوانند از طریق دستورات با LLMها تعامل داشته باشند، چه با پرسیدن سؤال یا ارائه دستورالعمل. این تعامل، ابزارهایی مانند ChatGPT، Google Gemini و Meta’s Llama را بسیار پرطرفدار کرده است.

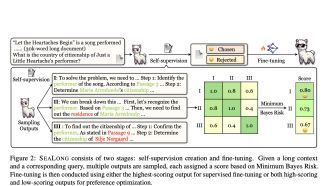

- یادگیری تقویتی: LLMها با گذشت زمان و از طریق بازخورد، بهبود مییابند. مربیان انسانی پاسخهای آنها را ارزیابی میکنند و هوش مصنوعی را به سمت تولید خروجیهای دقیقتر و مرتبطتر هدایت میکنند.

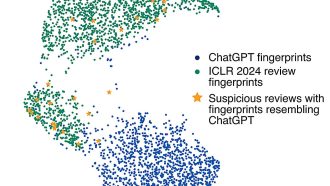

در حالی که این فرآیند بازخورد، کاری فشرده است، پژوهشگران شروع به استفاده از تعاملات تولید شده توسط خود هوش مصنوعی برای شبیهسازی ورودی انسان کردهاند تا هزینهها را کاهش دهند.

هزینههای نوآوری

با وجود قابلیتهای چشمگیر آنها، ایجاد LLMها نه ارزان است و نه سازگار با محیط زیست:

– هزینه مالی: آموزش برخی از مدلها میتواند صدها میلیون دلار هزینه داشته باشد.

– تأثیر زیستمحیطی: انتشار کربن ناشی از آموزش LLMها قابل توجه است و با چندین پرواز فراآتلانتیک برابری میکند.

مسیر پیش رو

با ادامهی تکامل LLMها، پتانسیل عظیمی برای تغییر شکل صنایع، از خدمات مشتری تا آموزش، دارند. با این حال، هزینههای بالا و تأثیر زیستمحیطی آنها چالشهایی را ایجاد میکند که باید برای رشد پایدار به آنها پرداخته شود.

انقلاب هوش مصنوعی هیچ نشانهای از کند شدن ندارد و درک سیر تکامل این فناوریها به ما کمک میکند تا فرصتها و مسئولیتهایی را که به همراه دارند، بهتر مدیریت کنیم.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: the conversation