بیا یه مدل خفن پزشکی رو بهت معرفی کنم که اسمش Med-GRIM هست! این مدل قراره به سوالهایی که درباره عکسها و اطلاعات پزشکی داری، اونم بدون اینکه نیاز باشه قبلاً براش خیلی آموزش ببینن، جواب بده؛ یعنی همون Zero-Shot Medical VQA.

بذار اول یه چیز رو توضیح بدم: VQA یعنی Visual Question Answering، یعنی اینکه به یه مدل یه عکس میدی، یه سوال درباره اون عکس ازش میپرسی و مدل جواب میده. تو دنیای پزشکی، این خیلی مهمه و سخت، چون جوابها باید دقیق و تخصصی باشن.

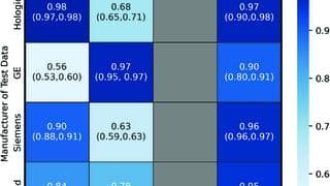

تا الان معمولاً برای اینجور کارها از چند مدل قوی استفاده میکردن که بهشون میگن مدلهای دوگانه یا همون Multimodal Encoders و Vision-Language Models (VLMs)—همونا که هم عکس رو میفهمن و هم زبان رو. معمولاً این مدلها باید کلی با دادههای مختلف آموزش ببینن یا به قول فنیها Fine-tune بشن که هم هزینهبره و هم زمانبر.

اما Med-GRIM اومده یه کار دیگه میکنه که هم کار راهاندازه و هم کاملاً هوشمندانهست. قلب این مدل، یه سیستم نمایشی به اسم BIND هست که خودش ترکیبی از یه مدل تصویر-زبان (BLIVA) با رمزگذاری واقعا فشرده و پیشرفتهست. یه جورایی داره همزمان هم عکس هم سوال رو با جزئیات زیاد تجزیه و تحلیل میکنه. تازه الهام گرفته از اون تکنیکهایی که بهشون «Contrastive Pretraining» میگن. یعنی همون شیوههایی که مدل قبل از آموزش اصلی، خودش میفهمه چه چیزایی شبیه هم هستن و چه چیزایی فرق دارن.

حالا نکته عجیب Med-GRIM اینجاست که برای جواب دادن به سوالای پزشکی، لازم نیست مدلهای پیچیده و گرون رو همهجا اجرا کنه. اومده با ماژولهای کوچیک و کارآمد (بهشون میگن SLM یا Small Language Models)، یه رویکرد «یادگیری کممصرف و سریع» رو اجرا کرده.

مد-گریم از یه جور بازیابی اطلاعات با گراف استفاده میکنه (Graph-RAG). یعنی چی؟ یعنی اطلاعات پزشکی رو به صورت گراف به مدل داده، بعد هر وقت یه سوال جدید رسید با دستورالعملهای سفارشی (Prompt Engineering)، دقیقاً همون اطلاعات لازم رو پیدا میکنه و تو جوابش میذاره! این باعث میشه جوابها هم دقیق باشه، هم تخصصی و هم بشه راحت با قابلیت بالا مدل رو اجرا کرد.

یه کار باحال دیگه این مدله اینه که نقش هر قسمت رو مشخص کرده؛ یعنی هر بخش (یا Agent) وظیفه خاص خودش رو داره. اینطوری با کمترین هزینه، میشه به دقت مدلهای بزرگ رسید!

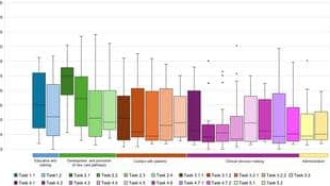

ولی این تازه نصف ماجراست. سازندههای Med-GRIM برای اینکه محققها بتونن تو حوزه پزشکی مدلهای هوشمند بهتر بسازن، یه دیتاست (یا همون مجموعه داده) جدید هم آماده کردن به اسم DermaGraph. این دیتاست کلی بیماریها و شرایط مختلف پوستی رو توش داره و به صورت گرافه. پس هرکسی دنبال تحقیق و توسعه تو هوش مصنوعی پزشکیه، راحت میتونه از DermaGraph برای آزمون و آموزش مدلهاش استفاده کنه—چه روی عکس و متن با هم (multimodal)، چه فقط با یکی.

هم کد مدل و هم دیتاست کاملاً باز و رایگان گذاشته شده رو گیتهاب. یعنی هرکسی خواست امتحان کنه یا ادامهش بده، میتونه از این آدرس بره سراغش: https://github.com/Rakesh-123-cryp/Med-GRIM.git

خلاصه Med-GRIM یه ترکیب خفن از هوش تصویری + زبان + بازیابی اطلاعات با گراف رو آورده تو دنیای پزشکی که هم دقت بالایی داره، هم جوابهای درست و مطمئن میده، هم حسابی بهینهست. واقعاً دم توسعهدهندههاش گرم! حالا هر سوالی درباره این مدل و داستانش داشتی، بپرس که کاملتر برات توضیح بدم 🙂

منبع: +