انتشار Claude 3.5 Haiku نشاندهندهی روند کوچکسازی مدلهای هوش مصنوعی است، همانطور که فاینمن پیشبینی کرده بود، ما در حال دستکاری ماده در سطح اتمی هستیم، اما این بار در دنیای دیجیتال. این حرکت به سمت مدلهای هوش مصنوعی کوچکتر و کارآمدتر، نوید پیشرفتهای چشمگیری را در حوزههای مختلف میدهد. این کوچکسازی مدلهای هوش مصنوعی به ما اجازه میدهد تا قدرت هوش مصنوعی را در دستگاههای کوچکتر و با مصرف انرژی کمتر تجربه کنیم.

انتشار مدل Claude 3.5 Haiku توسط شرکت Anthropic در Amazon Bedrock نشاندهنده یک روند قابل توجه در هوش مصنوعی است: توسعه مدلهای بزرگ زبانی (LLM) کوچکتر و تخصصیتر با قابلیتهای استدلال و برنامهنویسی پیشرفتهتر. این تغییر به سمت کوچکسازی و کارایی، منعکسکننده مفاهیمی است که توسط فیزیکدان ریچارد فاینمن در سخنرانی ۱۹۵۹ خود با عنوان “فضای زیادی در پایین وجود دارد” ارائه شده است. در حالی که فاینمن بر دستکاری ماده در سطح اتمی تمرکز داشت، ایدههای او در مورد فشردهسازی، دقت و یادگیری از سیستمهای زیستی، بهطور عمیقی با مسیر فعلی توسعه هوش مصنوعی همخوانی دارد.

ذخیرهسازی و فشردهسازی دادهها:

دیدگاه فاینمن در مورد ذخیرهسازی حجم عظیمی از اطلاعات در فضاهای فوقالعاده کوچک، مانند نوشتن دایرهالمعارف بریتانیکا بر روی سر یک سوزن، پیشبینی انقلاب دیجیتال بود. امروزه، مجموعه دادههای عظیم بهصورت دیجیتالی فشرده و ذخیره میشوند و الگوریتمهای یادگیری ماشین را تغذیه میکنند. این الگوریتمها با استفاده از شبکههای عصبی و مدلهای دیگر، این مجموعه دادهها را برای شناسایی الگوها، پیشبینی و انجام وظایف مختلف تجزیه و تحلیل میکنند. این امر منعکسکننده ایده فاینمن در مورد به حداکثر رساندن چگالی اطلاعات در حداقل فضای فیزیکی است.

کوچکسازی و دقت در دستکاری:

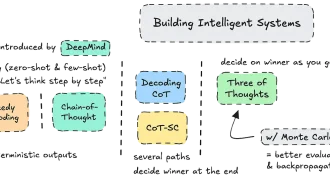

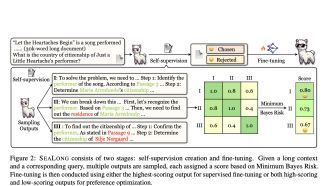

مفهوم فاینمن در مورد دستکاری اتمهای منفرد، با توسعه مدلهای هوش مصنوعی کوچکتر و کارآمدتر که برای محاسبات لبهای (edge computing) طراحی شدهاند، مشابهت دارد. مدلهایی مانند Claude 3.5 Haiku، Gemini Nano گوگل، و o1 mini و 4o mini شرکت OpenAI از تکنیکهایی مانند کوانتیزاسیون و هرس پارامتر برای کاهش پیچیدگی و بار محاسباتی بدون کاهش عملکردهای اساسی استفاده میکنند. این کوچکسازی امکان عملکرد دقیق در محیطهای با منابع محدود، مانند دستگاههای تلفن همراه را فراهم میکند و دسترسی به هوش مصنوعی را در پلتفرمهای مختلف گسترش میدهد. این دقت در کاربردهایی از تشخیصهای پزشکی گرفته تا مدلسازی مالی بسیار مهم است.

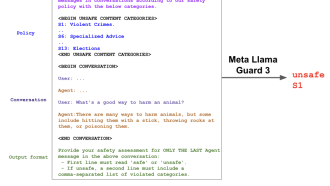

ویژگی “استفاده از کامپیوتر” Anthropic، که به هوش مصنوعی اجازه میدهد با کلیک کردن، تایپ کردن و پیمایش در رابطها مستقیماً با کامپیوتر کاربر تعامل داشته باشد، این اصل را بیشتر نشان میدهد. در حالی که این ویژگی هنوز در حال توسعه است، هدف آن این است که هوش مصنوعی بتواند وظایف دیجیتالی را با دقت انجام دهد و دیدگاه فاینمن در مورد “ماشینهای کوچک” که در یک سیستم بزرگتر کار میکنند را منعکس کند.

یادگیری از سیستمهای زیستی:

شیفتگی فاینمن به کارایی و پیچیدگی سیستمهای زیستی، بهویژه توانایی آنها در ذخیره و پردازش اطلاعات در مقیاس میکروسکوپی، در توسعه سیستمهای هوش مصنوعی الهام گرفته از زیستشناسی منعکس شده است. بهعنوان مثال، AlphaFold 3 از یادگیری عمیق برای پیشبینی ساختارهای پروتئین استفاده میکند، یک پیشرفت که بینشهای ارزشمندی در مورد عملکردهای سلولی ارائه میدهد و زمینههایی مانند کشف دارو و زیستشناسی مصنوعی را پیش میبرد. این امر تقلیدی از مشاهده فاینمن از سیستمهای زیستی است که عملکردهای پیچیدهای را در فضاهای محدود انجام میدهند و پتانسیل هوش مصنوعی را برای تقلید و حتی پیشی گرفتن از کارایی زیستی برجسته میکند.

خودکارسازی و رباتیک:

دیدگاه فاینمن در مورد کارخانههای کوچک و خودکار که قطعات کوچک و پیچیده را با دقت بالا تولید میکنند، با پیشرفتهای رباتیک و تولید خودکار همسو است. توسعه بازوهای رباتیک، نانوباتها و سیستمهای هوشمند تجسمیافته، مانند آنهایی که توسط استارتآپهایی مانند Physical Intelligence و World Labs در حال توسعه هستند، پیشرفت به سوی تحقق مفهوم فاینمن از ماشینهایی را نشان میدهد که در مقیاسهای فوقالعاده کوچک کار میکنند. این کوچکسازی، کارایی را افزایش میدهد و نوآوری را در زمینههایی مانند دستگاههای پزشکی و فناوری نانو امکانپذیر میسازد.

تولید انبوه و مقیاسبندی مراکز داده هوش مصنوعی:

پیشبینی فاینمن به تولید انبوه این ماشینهای مینیاتوری گسترش یافت و کپیهای کاملی را پیشبینی کرد که میتوانند برای پاسخگویی به تقاضاهای رو به رشد مقیاسبندی شوند. این مفهوم با روند فعلی مقیاسبندی زیرساختهای هوش مصنوعی از طریق توسعه کارخانههای هوش مصنوعی، مراکز داده در مقیاس بزرگ که برای مدیریت نیازهای محاسباتی فشرده هوش مصنوعی طراحی شدهاند، همسو است. معماریهای مرجع انویدیا برای کارخانههای هوش مصنوعی نمونهای از این روند هستند و یک چارچوب استاندارد برای مدیریت نیازهای قابل توجه ذخیرهسازی و پردازش داده مدلهای هوش مصنوعی به طور فزاینده پیچیده ارائه میدهند.

ظهور LLM های فشرده مانند Claude 3.5 Haiku گامی مهم در جهت تحقق دیدگاه فاینمن است. این روند به سمت کوچکسازی نه تنها کارایی محاسباتی را بهبود میبخشد، بلکه دسترسی و کاربرد هوش مصنوعی را در پلتفرمها و صنایع مختلف گسترش میدهد. با ادامه تکامل هوش مصنوعی، اصول فاینمن در مورد کوچکسازی، دقت و یادگیری از سیستمهای زیستی بدون شک همچنان الهامبخش و راهنمای توسعههای آینده خواهد بود و راه را برای سیستمهای هوش مصنوعی حتی قدرتمندتر و کارآمدتر هموار میکند. با این حال، تمرکز نباید فقط بر کوچک کردن اندازه باشد، بلکه بر ساخت سیستمهای پایدارتری باشد که پیامدهای اخلاقی و زیستمحیطی توسعه هوش مصنوعی را نیز مورد توجه قرار دهند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: forbes