ببین رفیق، تشخیص درست و به موقع ضایعات پوستی واقعاً توی پوست و زیبایی خیلی مهمه. اگه دکترها این کار رو زود انجام بدن، میتونه روند درمان فرد رو کلی تغییر بده. اما همیشه راحت نیست و خیلی وقتا چالش داره!

حالا قبلاً الگوریتمهای هوش مصنوعی و یادگیری عمیق (Deep Learning یعنی یه جور هوش مصنوعی که با دادههای خیلی زیاد آموزش میبینه و خودش یاد میگیره) کلی پیشرفت داشتن و تونستن با استفاده از عکسهای پوستی یا همون «درماتوسکوپی»، دکترها رو کمک کنن. اما هنوز یه نکته مهم خیلی جدی گرفته نشده بود: استفاده از اطلاعات بالینی آدمها کنار عکسها. منظور از Clinical Metadata همون اطلاعاتیه که از بیمار تو پرونده پزشکیاش ثبت میکنن، مثلاً سن، جنسیت، سابقه بیماری، محل ضایعه و از این چیزا.

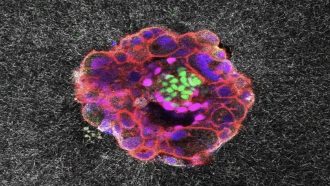

خلاصه داستان اینه که پژوهشگرا اومدن یه چارچوب جدید درست کردن که هم عکسها رو نگاه کنه هم این اطلاعات متنی درباره بیمار رو. این شبکه ترکیبی رو بهش میگن Multimodal Data Fusion، یعنی ترکیب دادههای تصویری با دادههای اطلاعاتی. برای تست هم از یه دیتاست معروف به اسم HAM10000 (یه مجموعه خیلی بزرگ از عکسهای ضایعات پوستی و اطلاعات بالینیشون) استفاده کردن.

برای اینکه بفهمن بهترین روش ترکیب دادهها چیه، چند مدل مختلف رو با هم مقایسه کردن:

- سادهترینش: Concatenation یعنی چسبوندن ساده دادهها کنار هم.

- Weighted Concatenation: یعنی هر اطلاعاتی رو یه وزنی بهش بدن، مثلاً بعضیاش مهمتر باشه.

- Self-Attention: یه جور الگوریتم هوشمنده که میفهمه کدوم بخش داده مهمتره.

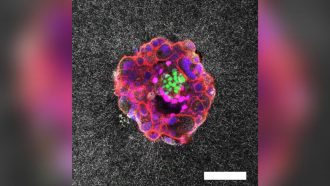

- Cross-Attention Fusion: این یکی جذابه! یعنی دادههای یکی روی اون یکی تاثیر بذارن و در هم تنیده بشن. (Attention هم یعنی الگوریتمی که تعیین میکنه مغز مدل روی کدوم بخشها بیشتر دقت کنه).

حالا عکسها رو با مدل ResNet (یه مدل خیلی باحال و قوی برای تحلیل تصویر) آنالیز کردن و اطلاعات بالینی رو هم با یک شبکه عصبی ساده به اسم MLP (Multi-Layer Perceptron، یعنی همون شبکه عصبی چندلایه ساده) پردازش کردن.

برای اینکه بفهمن مدل چجوری داره تصمیم میگیره، از روشی به اسم Grad-CAM استفاده کردن. Grad-CAM میشه ابزار تصویری کردن اینکه کدوم بخش از عکس یا اطلاعات متنی، بیشتر نظر مدل رو جلب کرده و توی تصمیمگیری موثر بوده.

خب، نتیجه چی شد؟ مدل Cross-Attention Fusion از همه بهتر بود! یعنی وقتی عکسهای ضایعه و اطلاعات پزشکی رو هوشمندانه با هم ترکیب کنی، مدل دقیقتر از اونیه که فقط عکس یا فقط اطلاعات متنی رو ببینه. حتی از مدلهایی که فقط دادهها رو کنار هم میذاشتن هم بهتر بود. خلاصه مدل چندموضعی (هم تصویر هم داده متنی) ترکوند!

البته همیشه همه چی رو به راه نیست؛ چون این مدلهای ترکیبی پیشرفته هم پیچیدگی کامپیوتری بالایی دارن و هم توی دادهها ممکنه «عدم تعادل کلاس» باشه (Class Imbalance یعنی اینکه بعضی دستهها داده کمتر یا بیشتری دارن که میتونه مدل رو گیج کنه). پس هنوز جای تحقیق بیشتر هست.

در کل، نتیجه گرفتن که ترکیب اطلاعات بالینی با عکس های پوستی، وضعیت تشخیص خودکار ضایعات رو به شکل قابل توجهی بهتر میکنه و این واقعاً میتونه تو دنیای واقعی کلی به پزشکها کمک برسونه! حالا اگه یه بار حرف از «مدل چندموضعی» یا «مرز ترکیب دادهها» شد، دیگه میدونی دقیقا ماجرا چیه 😉

منبع: +