مدلهای زبانی کوچک (SLM) به عنوان جایگزینی کارآمد برای مدلهای زبانی بزرگ (LLMها) مطرح میشوند و عملکرد چشمگیری را در وظایف تخصصی با نیازهای محاسباتی کمتر ارائه میدهند. این بررسی عمیق مزایای SLMها، از افزایش حریم خصوصی گرفته تا پردازش بلادرنگ، را بررسی میکند.

مدلهای زبانی بزرگ (LLMها) انقلابی در هوش مصنوعی ایجاد کردهاند و وظایف پیچیدهای مانند تولید متن و مکالمه را ممکن ساختهاند. با این حال، نیازهای محاسباتی قابل توجه آنها، کاربرد عملی آنها را در بسیاری از سناریوهای دنیای واقعی محدود میکند. LLMها اغلب به زیرساخت ابری قدرتمند نیاز دارند که نگرانیهایی را در مورد تأخیر، هزینه و حریم خصوصی دادهها ایجاد میکند. مدلهای زبانی کوچک (SLMها) به عنوان یک راهحل قانعکننده ظاهر میشوند و تعادلی بین عملکرد و کارایی ارائه میدهند. این بررسی عمیق، مزایای SLMها، زیربنای فنی آنها و پتانسیل آنها برای متحول کردن صنایع مختلف را بررسی میکند.

چالش LLMها و ظهور SLMها

LLMها، با میلیاردها پارامتر خود، به حافظه GPU و قدرت پردازش گستردهای نیاز دارند. به عنوان مثال، مدلهایی مانند Llama-3.1 به بیش از 200 گیگابایت حافظه GPU نیاز دارند که استقرار آنها را در دستگاههای لبه یا در موقعیتهایی که نیاز به پردازش بلادرنگ دارند، غیرعملی میکند. تأخیر مرتبط با LLMها میتواند بسیار زیاد باشد و زمان پردازش حتی در پردازندههای موبایل نسبتاً قدرتمند به چند ثانیه برسد. این تأخیر، آنها را برای برنامههایی که نیاز به پاسخهای فوری دارند، مانند تشخیصهای مراقبتهای بهداشتی، تراکنشهای مالی یا دستیاران شخصی بلادرنگ، نامناسب میکند. علاوه بر این، هزینه آموزش و استقرار LLMها میتواند قابل توجه باشد و دسترسی سازمانهای کوچکتر یا تیمهای تحقیقاتی را محدود کند.

راهحلهای موجود مانند APIهای مبتنی بر ابر، دستهبندی دادهها و هرس مدل، راهحلهای جزئی ارائه میدهند، اما اغلب نمیتوانند به طور کامل به مسائل اصلی تأخیر، وابستگی به زیرساخت و حریم خصوصی رسیدگی کنند. هرس و کوانتیزاسیون، در حالی که اندازه مدل را کاهش میدهند، میتوانند دقت را به خطر بیندازند، عاملی حیاتی در برنامههایی که نیاز به قابلیت اطمینان بالا دارند.

از سوی دیگر، SLMها برای کارایی طراحی شدهاند. آنها به حافظه و قدرت پردازش بسیار کمتری نیاز دارند و امکان استقرار در دستگاههای با منابع محدود مانند تلفنهای هوشمند و دستگاههای اینترنت اشیا را فراهم میکنند. تحقیقات اخیر، از جمله یک بررسی جامع انجام شده توسط مؤسساتی مانند دانشگاه ایالتی پنسیلوانیا، دانشگاه پنسیلوانیا و آمازون، پتانسیل SLMها را برای ارائه عملکرد مشابه LLM در حوزههای خاص با سربار محاسباتی به طور قابل توجهی کاهش یافته، برجسته میکند.

پیشرفتهای فنی که عملکرد SLM را هدایت میکنند

چندین پیشرفت فنی کلیدی، اثربخشی SLMها را پشتیبانی میکنند. اصلاحات حافظه کارآمد در مکانیسمهای توجه، مانند توجه پرسوجوی گروهبندی شده (GQA)، توجه نهفته چند سر (MLA) و Flash Attention، به SLMها اجازه میدهد تا عملکرد را بدون ردپای عظیم حافظه LLMها حفظ کنند. تکنیکهایی مانند اشتراکگذاری پارامتر و تطبیق رتبه پایین، SLMها را قادر میسازد تا وظایف پیچیده را در زمینههای تخصصی مانند مراقبتهای بهداشتی، امور مالی و پشتیبانی مشتری، جایی که پاسخ سریع و حریم خصوصی دادهها بسیار مهم است، مدیریت کنند. علاوه بر این، تمرکز بر کیفیت دادهها در طول آموزش، از جمله فیلتر کردن، حذف دادههای تکراری و ساختارهای داده بهینه شده، دقت و سرعت SLM را در زمینههای خاص بیشتر میکند.

شواهد تجربی و مزایای کلیدی SLMها

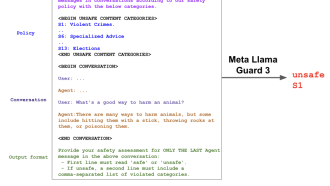

نتایج تجربی، پتانسیل عملکرد چشمگیر SLMها را نشان میدهد. معیارها در برنامههای مختلف، از جمله مراقبتهای بهداشتی، امور مالی و دستیاران شخصی، کاهش قابل توجه تأخیر و افزایش حریم خصوصی دادهها را به دلیل پردازش محلی نشان میدهند. به عنوان مثال، در مراقبتهای بهداشتی، SLMها پردازش دادهها را روی دستگاه فعال میکنند، از اطلاعات حساس بیمار محافظت میکنند و در عین حال بینشهای به موقع ارائه میدهند. روشهای آموزش بهینهشده برای SLMها به آنها اجازه میدهد تا 90٪ از دقت LLM را در حوزههای خاص حفظ کنند، یک دستاورد قابل توجه با توجه به اندازه و نیازهای سختافزاری کاهش یافته آنها.

نکات کلیدی تحقیق در مورد SLMها عبارتند از:

- کارایی محاسباتی: SLMها با حافظه و قدرت پردازش بسیار کمتری نسبت به LLMها کار میکنند و امکان استقرار در طیف وسیعتری از دستگاهها را فراهم میکنند.

- سازگاری خاص دامنه: بهینهسازیهای هدفمند به SLMها اجازه میدهد تا به عملکرد نزدیک به LLM در زمینههای تخصصی مانند مراقبتهای بهداشتی و امور مالی دست یابند.

- کاهش تأخیر: SLMها زمان پاسخگویی را به شدت کاهش میدهند و پردازش بلادرنگ را که برای برنامههای لبه و سناریوهای حساس به حریم خصوصی حیاتی است، فعال میکنند.

- حریم خصوصی و امنیت دادهها: پردازش محلی با SLMها نیاز به انتقال دادهها به ابر را به حداقل میرساند و حریم خصوصی و امنیت را افزایش میدهد.

- مقرون به صرفه بودن: نیازهای سختافزاری و محاسباتی کمتر، SLMها را به راهحلی در دسترستر برای سازمانهایی با منابع محدود تبدیل میکند.

آینده SLMها

تحقیق در مورد SLMها یک چارچوب قانعکننده برای استقرار قابلیتهای پیشرفته پردازش زبان در محیطهای با منابع محدود ارائه میدهد. SLMها مسیری امیدوارکننده برای ادغام هوش مصنوعی در طیف وسیعتری از برنامهها، از دستگاههای تلفن همراه گرفته تا سیستمهای تعبیه شده، ارائه میدهند. با بهینهسازی برای تأخیر، حریم خصوصی و کارایی محاسباتی، SLMها دسترسی به مدلهای زبانی قدرتمند را دموکراتیک میکنند و راه را برای پذیرش و نوآوری گستردهتر در صنایع مختلف هموار میکنند. با ادامه پیشرفت تحقیقات، SLMها آماده هستند تا نقش فزایندهای در شکلدهی آینده هوش مصنوعی ایفا کنند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: marktechpost.com