تولید مبتنی بر بازیابی (RAG) قابلیتهای مدلهای زبانی بزرگ (LLM) را افزایش میدهد، اما میتواند هزینههای محاسباتی بالایی داشته باشد. RAGCache با ذخیرهسازی پویا، بهینهسازی RAG را ممکن میسازد و تأخیر را کاهش میدهد و توان عملیاتی را برای برنامههای بلادرنگ افزایش میدهد. این بهینهسازی به لطف RAGCache، اجرای سریعتر و کارآمدتر برنامههای RAG را تضمین میکند.

تولید مبتنی بر بازیابی (RAG) با فعال کردن دسترسی و استفاده از منابع دانش خارجی، قابلیتهای مدلهای زبانی بزرگ (LLM) را متحول کرده است و منجر به پاسخهای مرتبطتر و دقیقتر از نظر زمینهای شده است. با این حال، این تکنیک قدرتمند سربار محاسباتی و حافظه قابل توجهی را به همراه دارد، که عمدتاً به دلیل گنجاندن اسناد خارجی طولانی در درخواستهای LLM است. این توالیهای طولانی میتوانند بیش از ده برابر طول درخواست اولیه باشند که باعث ایجاد گلوگاه برای برنامههای بلادرنگ و مانع از مقیاسپذیری RAG میشوند. استراتژیهای بهینهسازی موجود برای استنتاج LLM، مانند اشتراکگذاری حالات میانی، مفید بودهاند اما در رفع چالشهای خاص ایجاد شده توسط RAG، بهویژه خواستههای تولید دنباله طولانی و بازیابی مکرر دانش، ناکام ماندهاند.

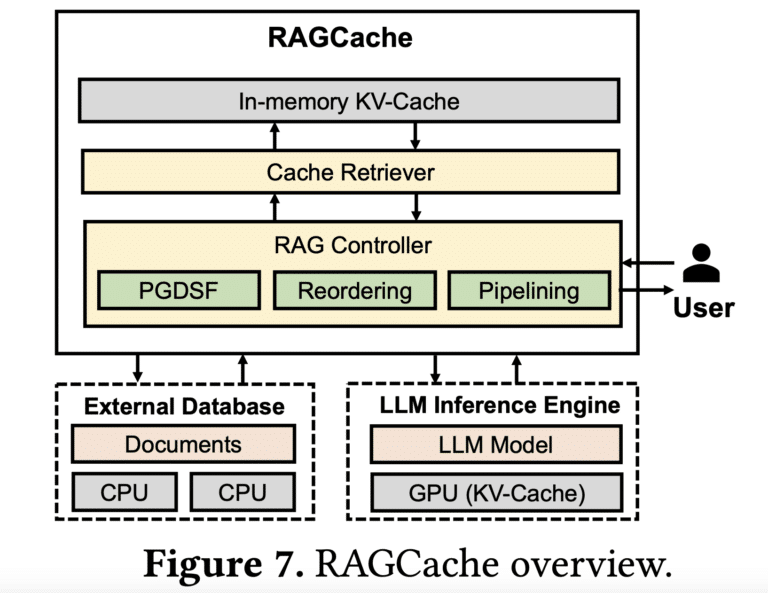

RAGCache، یک سیستم ذخیرهسازی پویا چندسطحی جدید که توسط محققان دانشگاه پکن و ByteDance توسعه داده شده است، راهحل این چالشها را ارائه میدهد. RAGCache که بهطور خاص برای بهینهسازی تولید مبتنی بر بازیابی طراحی شده است، با پیادهسازی یک درخت دانش که حالات میانی اسناد بازیابی شده را در سلسله مراتب حافظه GPU و میزبان ذخیره میکند، با ناکارآمدی سیستمهای RAG سنتی مقابله میکند. این رویکرد نوآورانه امکان مدیریت و استفاده مجدد کارآمد از این حالات میانی حیاتی را در چندین درخواست فراهم میکند، محاسبات اضافی را به حداقل میرساند و زمان پاسخ را تسریع میکند. این سیستم عملکرد را از طریق یک سیاست جایگزینی متناسب، حساس به ویژگیهای استنتاج LLM و الگوهای بازیابی RAG، که نرخ برخورد حافظه پنهان را به حداکثر میرساند و استفاده کارآمد از منابع حافظه GPU و میزبان را تضمین میکند، بیشتر افزایش میدهد. علاوه بر این، RAGCache از مسيرسازی حدسی پویا استفاده میکند و مراحل بازیابی و استنتاج را همپوشانی میکند تا تأخیر کلی را کاهش دهد.

درخت دانش در قلب RAGCache تانسورهای کلید-مقدار ذخیره شده اسناد بازیابی شده را سازماندهی میکند. اسناد پرکاربرد در اولویت قرار میگیرند و در حافظه سریعتر GPU ذخیره میشوند، در حالی که اسناد کمتر استفاده شده در حافظه کندتر میزبان قرار میگیرند. این رویکرد چندلایه دسترسی سریع به مرتبطترین اطلاعات را تضمین میکند. سیاست جایگزینی منحصربهفرد Prefix-aware Greedy-Dual-Size-Frequency (PGDSF) سیستم نقش مهمی در حفظ نرخ بالای برخورد حافظه پنهان ایفا میکند. PGDSF بهطور هوشمندانه ترتیب اسناد، فراوانی دسترسی، اندازه و تازگی را برای تعیین اینکه کدام موارد ذخیره شده را حفظ کند و کدام را جایگزین کند، در نظر میگیرد و خطاهای حافظه پنهان را به حداقل میرساند و استفاده از منابع را بهینه میکند. ویژگی مسيرسازي حدسی پویا با همپوشانی فرآیندهای بازیابی برداری و استنتاج LLM، تأخیر ذاتی در اجرای متوالی را کاهش میدهد و کارایی را بیشتر افزایش میدهد.

اثربخشی RAGCache با ادغام آن با vLLM، یک سیستم استنتاج LLM پیشرو، و Faiss، یک پایگاه داده برداری پرکاربرد، به دقت ارزیابی شد. معیارها بهبود عملکرد قابل توجهی را در مقایسه با تنظیمات RAG سنتی نشان دادند. RAGCache در مقایسه با vLLM با استفاده از Faiss به کاهش 4 برابری زمان رسیدن به اولین نشانه (TTFT) و بهبود 2.1 برابری در توان عملیاتی دست یافت. حتی در مقایسه با SGLang، یک سیستم سرویسدهی LLM با کارایی بالا، RAGCache دستاوردهای چشمگیری را با کاهش 3.5 برابری در TTFT و افزایش 1.8 برابری در توان عملیاتی نشان داد. این نتایج مزایای قابل توجه ذخیرهسازی چندسطحی همراه با تکنیکهای پیشرفته همپوشانی بازیابی و تولید را برجسته میکند. RAGCache با ذخیرهسازی کارآمد اسناد پرکاربرد، سربار محاسباتی را به میزان قابل توجهی کاهش میدهد و آن را برای سناریوهایی با حجم بالایی از درخواستهای بازیابی مشابه بسیار مناسب میکند.

اهمیت RAGCache در توانایی آن برای پر کردن شکاف بین پتانسیل نظری RAG و کاربرد عملی آن در سناریوهای بلادرنگ و در مقیاس بزرگ نهفته است. مکانیسم ذخیرهسازی هوشمند سیستم مستقیماً به گلوگاههای عملکردی که مانع از پذیرش گسترده RAG شدهاند، میپردازد. RAGCache با کاهش تأخیر و افزایش توان عملیاتی، LLMهای تقویتشده با منابع دانش خارجی را امکانپذیر میکند و امکانات جدیدی را برای برنامههای بلادرنگ مانند رباتهای گفتگو، سیستمهای پرسش و پاسخ و تولید محتوای شخصیسازی شده باز میکند.

با ادامه تکامل LLMها، پیچیدهتر و پرمصرفتر شدن، راهحلهایی مانند RAGCache برای اطمینان از استقرار کارآمد و مقیاسپذیر آنها ضروری هستند. توانایی ادغام یکپارچه دانش خارجی در عین حفظ تأخیر کم و توان عملیاتی بالا برای آزادسازی پتانسیل کامل این مدلهای زبانی قدرتمند بسیار مهم است. RAGCache نشاندهنده یک گام رو به جلو در بهینهسازی تولید مبتنی بر بازیابی است و راه را برای برنامههای LLM پاسخگوتر و کارآمدتر از نظر منابع هموار میکند. رویکرد نوآورانه آن به ذخیرهسازی چندسطحی و مسيرسازی پویا، یک چارچوب قوی برای مقیاسبندی RAG برای برآوردن خواستههای برنامههای دنیای واقعی ارائه میدهد و در نهایت قدرت LLMهای بهبود یافته با دانش را در دسترستر و کاربردیتر میکند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: marktechpost.com