تحول هوش مصنوعی کسبوکارها را متحول میکند. بیاموزید که چرا این تحول از تحول دیجیتال حیاتیتر است و چگونه میتواند بر سازمان شما تأثیر بگذارد.

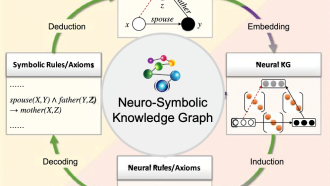

دنیای کسبوکار مملو از یک اصطلاح جدید است: تحول هوش مصنوعی. در حالی که تحول دیجیتال بر استفاده از فناوری برای بهبود فرآیندها و تجارب مشتری تمرکز داشت، تحول هوش مصنوعی با ادغام هوش مصنوعی، بهویژه هوش مصنوعی مولد (Generative AI)، در هسته استراتژی کسبوکار، این روند را یک گام فراتر میبرد. این تغییر صرفاً تغییر نام ابتکارات موجود نیست، بلکه یک تغییر اساسی در نحوه عملکرد، نوآوری و رقابت سازمانها است.

با توجه به پیشرفتهای سریع و پتانسیل آشکار هوش مصنوعی مولد، مدیران عامل و هیئت مدیره به طور فزایندهای ابتکارات مبتنی بر هوش مصنوعی را دنبال میکنند و خواستار نتایج ملموس و بازگشت سریع سرمایه هستند. این افزایش علاقه، که توسط تبلیغات رسانهای و پیادهسازیهای اولیه موفق تقویت شده است، هم فرصتها و هم چالشهایی را برای کسبوکارها ایجاد میکند.

ظهور تحول هوش مصنوعی:

نظرسنجی مدیران عامل گارتنر در سال ۲۰۲۴ نشاندهنده تغییر قابلتوجهی در اولویتهای اجرایی است. تمرکز بر «دیجیتال» در سالهای اخیر کاهش یافته و جای خود را به تأکید روزافزون بر «هوش مصنوعی» داده است. این تغییر نشاندهنده این شناخت است که هوش مصنوعی، به ویژه هوش مصنوعی مولد، قابلیتهای منحصربهفردی را ارائه میدهد که میتواند صنایع را متحول کند. مدیران عامل، هوش مصنوعی را بهعنوان تأثیرگذارترین فناوری در آینده نزدیک میدانند که از سایر پیشرفتهای دیجیتال پیشی گرفته است.

این تغییر صرفاً معنایی نیست. این نشاندهنده حرکت به سمت عصر جدیدی از کسبوکار خودگردان است، جایی که سیستمها و فرآیندهای مبتنی بر هوش مصنوعی نقش محوری در تصمیمگیری و عملیات ایفا میکنند. این گذار نیازمند رویکرد متفاوتی برای پذیرش فناوری است، رویکردی که بر استراتژی داده، ملاحظات اخلاقی و درک عمیق از قابلیتها و محدودیتهای هوش مصنوعی تأکید دارد.

نقش جدید مدیر ارشد اطلاعات:

ظهور تحول هوش مصنوعی فرصت بینظیری را برای مدیران ارشد اطلاعات (CIO) ایجاد میکند. برخلاف تحولات دیجیتال قبلی که اغلب تحت نظارت مدیران ارشد مالی یا مدیران ارشد عملیاتی بود، تحول هوش مصنوعی نیازمند تخصص فنی عمیق است و مدیران ارشد اطلاعات را در خط مقدم این تغییر استراتژیک قرار میدهد. مدیران عامل به طور فزایندهای برای راهنمایی در مورد چگونگی استفاده مؤثر از هوش مصنوعی به مدیران ارشد اطلاعات روی میآورند و سطح جدیدی از نفوذ و مسئولیت را برای رهبران فناوری اطلاعات ایجاد میکنند.

با این حال، این برجستگی تازه با چالشهایی نیز همراه است. مدیران عامل، تحت تأثیر تبلیغات پیرامون هوش مصنوعی، اغلب انتظارات غیرواقعی در مورد قابلیتها و تأثیر بالقوه آن دارند. مدیران ارشد اطلاعات باید این انتظارات را با دقت مدیریت کنند و هیجان پیرامون هوش مصنوعی را با واقعیتهای عملی پیادهسازی، از جمله نگرانیهای اخلاقی، خطرات امنیتی و نیاز به پایههای داده قوی، متعادل کنند.

پیمایش چالشها:

در حالی که پتانسیل هوش مصنوعی غیرقابل انکار است، مدیران ارشد اطلاعات باید برای هدایت موفقیتآمیز تحول هوش مصنوعی به چند چالش کلیدی بپردازند:

-

مدیریت انتظارات: مدیران ارشد اطلاعات باید مدیران عامل و هیئت مدیره را در مورد واقعیتهای هوش مصنوعی آموزش دهند و تبلیغات را از کاربردهای عملی جدا کنند. این شامل بیان واضح محدودیتهای فناوری فعلی هوش مصنوعی و نیاز به رویکرد مرحلهای برای پیادهسازی است.

-

ایجاد پایههای قوی: تحول هوش مصنوعی نیازمند زیرساخت داده، حاکمیت و استراتژی قوی است. مدیران ارشد اطلاعات باید به سرمایهگذاری در این زمینهها اولویت دهند تا اطمینان حاصل شود که ابتکارات هوش مصنوعی بر پایه محکمی بنا شدهاند.

-

پرداختن به نگرانیهای اخلاقی: هوش مصنوعی نگرانیهای اخلاقی قابلتوجهی از جمله سوگیری، انصاف و شفافیت را ایجاد میکند. مدیران ارشد اطلاعات باید دستورالعملهای اخلاقی روشنی را تدوین کنند و اطمینان حاصل کنند که سیستمهای هوش مصنوعی به طور مسئولانه توسعه و مستقر میشوند.

-

کاهش خطرات امنیتی: سیستمهای هوش مصنوعی میتوانند در برابر نقضهای امنیتی و حملات مخرب آسیبپذیر باشند. مدیران ارشد اطلاعات باید اقدامات امنیتی قوی را برای محافظت از دادههای حساس و اطمینان از یکپارچگی فرآیندهای مبتنی بر هوش مصنوعی اجرا کنند.

-

تمرکز بر موارد استفاده: مدیران ارشد اطلاعات به جای اینکه درگیر تبلیغات شوند، باید بر شناسایی موارد استفاده خاص که هوش مصنوعی میتواند ارزش تجاری ملموسی را ارائه دهد، تمرکز کنند. این شامل همکاری نزدیک با ذینفعان کسبوکار برای درک نیازهای آنها و اولویتبندی ابتکارات هوش مصنوعی بر این اساس است.

بنا کردن بر سرمایهگذاریهای موجود:

تحول هوش مصنوعی مستلزم کنار گذاشتن تلاشهای قبلی تحول دیجیتال نیست. در عوض، باید بهعنوان امتداد و تقویت آن ابتکارات در نظر گرفته شود. مدیران ارشد اطلاعات باید از زیرساخت دادههای موجود، فرآیندهای دیجیتال و سرمایهگذاریهای فناوری برای تسریع پذیرش هوش مصنوعی و به حداکثر رساندن تأثیر آن استفاده کنند.

با تمرکز بر کاربردهای عملی، ایجاد پایههای قوی و پرداختن به نگرانیهای اخلاقی و امنیتی، مدیران ارشد اطلاعات میتوانند چالشهای تحول هوش مصنوعی را با موفقیت پشت سر بگذارند و پتانسیل تحولآفرین آن را برای سازمانهای خود آزاد کنند. این امر مستلزم یک رویکرد متعادل است که هیجان پیرامون هوش مصنوعی را با درک واقعبینانه از قابلیتها و محدودیتهای آن ترکیب میکند. با انجام این کار، مدیران ارشد اطلاعات میتوانند سازمانهای خود را برای موفقیت در عصر هوش مصنوعی آماده کنند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: zdnet