خب، بیاید یه موضوع جالب در مورد هوش مصنوعی (همون AI که این روزا همهجا اسمش رو میشنویم) رو با هم بررسی کنیم. جدیداً یه نسل تازه از مدلهای هوش مصنوعی مد شده که قبل از اینکه جواب نهایی رو بدن، قدمبهقدم منطق خودشون رو برات مینویسن. یعنی مثلاً سوال میپرسی، اینا مثلاً مینویسن: «خب، اول اینو بررسی کردم، بعد اون رو حساب کردم، پس نتیجه این شد». این روند باعث شده خیلیها فکر کنن میتونن دقیق بفهمن که این هوش مصنوعیها تو ذهنشون چی میگذره و کارشون رو تفسیر کنن. شفافیت و قابل درک بودن منطقشون هم حسابی بولد شده.

اما یه سوال مهم پیش میاد: آیا واقعاً ما آدما میتونیم از این توضیحات قدمبهقدم بفهمیم که هوش مصنوعی چجوری به جواب رسیده؟ این مقاله اومده دقیقاً همین رو بررسی کنه.

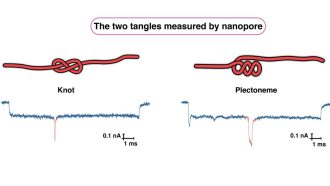

توی این تحقیق، یه کار بامزه انجام دادن. اومدن به آدمها سوالهایی دادن که جوابش به توضیحات قدمبهقدم هوش مصنوعی بستگی داشت. کاری که باید میکردن این بود که بفهمن کدوم مرحله واقعاً روی مراحل بعدی تاثیر گذاشته (یعنی اون قدم، باعث تغییر جواب شده یا نه). در واقع یه جورایی داشتن دنبال رابطهی علت و معلولی میگشتن.

حالا نتیجه چی شد؟ دقت شرکتکنندهها فقط ۲۹.۳ درصد بود! یعنی تقریباً در حد شانس داشتن حدس میزدن (شانس خالی هم ۲۵ درصد بود!). حتی وقتی به جواب جمعی بیشتر افراد (یعنی رأی اکثریت) نگاه کردن، دقت رسید به ۴۲ درصد که باز هم چندان بالا نیست.

اینجا یه نکته خیلی مهم وجود داره: این نشون میده بین چیزی که ما از متنهای استدلالی AI برداشت میکنیم و چیزی که واقعاً اون مدل داره حساب میکنه، یه فاصله اساسی وجود داره. یعنی مثلاً ممکنه فکر کنیم “آهان، حالا که این رو گفت پس حتماً این مرحله روی جواب تاثیر داشته” ولی در واقع مدل اصلاً اونطوری فکر نمیکنه یا این مرحله رو همینطوری نوشته.

خلاصه بحث مقاله اینه که نباید این توضیحات قدمبهقدم مدلها رو خیلی جدی گرفت یا فکر کنیم همین که خوندیمشون، پس همه چیز مشخصه. باید بدونیم این متنها در واقع یه جور اثر جانبی یا artefact هستن – یعنی خودشون یه چیزهایی دارن که باید حسابی کاوش بشه و نمیشه روشون راحت تکیه کرد.

در نهایت، نویسندهها میگن فهمیدن اینکه مدلهای زبانی (Language models یعنی همین مدلهایی که متنو مینویسن و حرف میزنن مثل ChatGPT) دقیقاً چطور از زبان استفاده میکنن – بدون اینکه الزاماً مثل آدمها فکر کنن – یکی از مهمترین موضوعات پژوهشی این حوزهست. پس باید با احتیاط بیشتری به استدلالهای AI نگاه کنیم و دنبال راههایی باشیم که واقعاً بتونیم ذهن این مدلها رو بخونیم، نه اینکه فقط ظاهر حرفاشون رو باور کنیم!

منبع: +