پتانسیل تولید مبتنی بر بازیابی (RAG) را کشف کنید، یک رویکرد پیشرفته در هوش مصنوعی مولد که با ترکیب مدلهای زبانی بزرگ (LLM) و دادههای مرتبط، پاسخهایی دقیقتر و متکی بر واقعیت ارائه میدهد. در این راهنما، معماری سیستمهای RAG، نحوه عملکرد آنها و ابزارهای لازم برای پیادهسازی در سطح تولید را بیاموزید.

تولید مبتنی بر بازیابی (RAG) به سرعت در حال تبدیل شدن به سنگ بنای هوش مصنوعی مولد است، به طوری که بیش از ۶۰٪ از برنامههای مبتنی بر LLM از این روش استفاده میکنند. با ادغام دانش خارجی با LLMها، RAG محدودیتهای این مدلها – مانند دادههای آموزشی قدیمی، توهم و فقدان دانش خاص دامنه – را برطرف میکند. این راهنما معماری، لایههای عملیاتی و بهترین شیوهها را برای ساخت و مقیاسبندی سیستمهای RAG بررسی میکند.

مقدمهای بر تولید مبتنی بر بازیابی (RAG)

RAG حافظه پارامتریک LLMها (دانش ذخیره شده در پارامترهای مدل) را با حافظه غیر پارامتریک (منابع داده خارجی) ترکیب میکند تا پاسخهای دقیق، جامع و بهروزی ارائه دهد. این تکنیک سه محدودیت اصلی LLMها را کاهش میدهد:

- تاریخ قطع دانش: LLMها بر روی مجموعه دادههای ایستا آموزش داده میشوند و ممکن است اطلاعات پس از تاریخ مشخصی را نداشته باشند.

- محدودیتهای مجموعه داده آموزشی: LLMها به دادههای اختصاصی یا غیر عمومی دسترسی ندارند.

- توهم: LLMها گاهی اوقات پاسخهای نادرست واقعی اما با اعتماد به نفس بالا تولید میکنند.

با ادغام حافظه غیر پارامتریک خارجی، RAG، LLMها را با دادههای بلادرنگ، خاص دامنه و قابل تأیید تکمیل میکند.

نحوه عملکرد RAG

در هسته خود، یک سیستم RAG از طریق سه مرحله اصلی عمل میکند:

- بازیابی: جستجوی اطلاعات مرتبط از منابع خارجی.

- تقویت: ترکیب دادههای بازیابی شده با پرس و جوی ورودی کاربر.

- تولید: استفاده از یک LLM برای تولید پاسخ بر اساس ورودی تقویتشده.

این فرآیند RAG را قادر میسازد تا خروجیهای دقیق، متنی و قابل اعتماد تولید کند که اغلب به دلیل شفافیت ذکر میشوند.

کاربردهای دنیای واقعی RAG

RAG چندین برنامه با تأثیر بالا را در صنایع مختلف، از جمله موارد زیر، تقویت میکند:

- موتورهای جستجو: پلتفرمهایی مانند گوگل، Perplexity و Bing از RAG برای ارائه پاسخهای زبان طبیعی با ذکر منبع استفاده میکنند.

- عوامل مکالمه: رباتهای پشتیبانی مشتری از RAG برای تعاملات خاص دامنه استفاده میکنند.

- تولید محتوا: ایجاد محتوای شخصیسازی شده و متنی برای بازاریابی و آموزش.

- گزارش رویدادهای بلادرنگ: بهروزرسانیهای پویا در طول رویدادهای زنده مانند ورزش یا پوشش خبری.

- سیستمهای توصیه: شخصیسازی پیشرفته برای توصیههای محتوا و محصول.

- دستیاران مجازی: تعاملات بهبود یافته کاربر در ابزارهایی مانند Alexa و Siri.

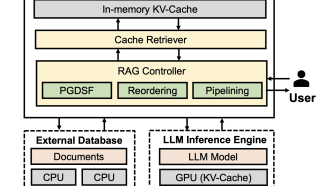

آناتومی یک سیستم RAG

یک سیستم RAG از دو خط لوله اصلی تشکیل شده است:

1. خط لوله فهرستگذاری

مسئول ایجاد و نگهداری پایگاه دانش، خط لوله فهرستگذاری شامل موارد زیر است:

- دریافت داده: دادهها را از منابعی مانند APIها، اسناد یا پایگاههای داده استخراج میکند.

- تجزیه و قطعهبندی داده: متون طولانی را به قطعات قابل مدیریت برای پردازش کارآمد تقسیم میکند.

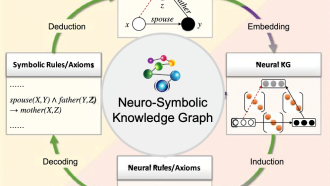

- تبدیل به جاسازی: متن را به فرمتهای برداری برای بازیابی تبدیل میکند.

- ذخیرهسازی: دادههای پردازش شده را در پایگاههای داده برداری یا نمودارهای دانش ذخیره میکند.

2. خط لوله تولید

تعاملات بلادرنگ با کاربران را از طریق موارد زیر تسهیل میکند:

- ورودی پرس و جو: کاربر یک سؤال یا درخواست ارسال میکند.

- بازیابی اطلاعات: پایگاه دانش را برای دادههای مرتبط جستجو میکند.

- تقویت: دادههای بازیابی شده را با پرس و جو ترکیب میکند.

- تولید پاسخ: از یک LLM برای تولید خروجی نهایی استفاده میکند.

پشته RAGOps: لایههای اصلی برای سیستمهای تولیدی

ساخت یک سیستم RAG در سطح تولید نیاز به یک پشته عملیاتی قوی شامل لایههای حیاتی، ضروری و ارتقا دارد.

لایههای حیاتی

این لایهها ستون فقرات هر سیستم RAG را تشکیل میدهند:

- لایه داده: دریافت داده، تبدیل (به عنوان مثال، قطعهبندی، جاسازی) و ذخیرهسازی در قالبهایی مانند پایگاههای داده برداری (به عنوان مثال، Pinecone، Chroma) را مدیریت میکند.

- لایه مدل: میزبان LLMهای از پیش آموزش دیده یا تنظیم دقیق و مدلهای جاسازی است. شامل ابزارهایی مانند HuggingFace، APIهای OpenAI و ONNX برای بهینهسازی استنتاج است.

- استقرار مدل: ارائه کارآمد مدلها را از طریق سرویسهای کاملاً مدیریت شده (به عنوان مثال، OpenAI، AWS)، راه حلهای خود میزبان (به عنوان مثال، Kubernetes، Docker) یا استقرارهای لبه (به عنوان مثال، TensorFlow Lite) تضمین میکند.

- لایه هماهنگسازی برنامه: تعاملات بین لایههای داده و مدل را هماهنگ میکند. چارچوبهایی مانند LangChain و LlamaIndex هماهنگسازی پرس و جو، منطق بازیابی و گردشهای کاری چند عاملی را مدیریت میکنند.

لایههای ضروری

این لایهها عملکرد، قابلیت اطمینان و ایمنی را افزایش میدهند:

- مهندسی سریع: دستورالعملهای ارسال شده به LLMها را برای کاهش توهم و بهبود کیفیت خروجی بهینه میکند. ابزارهایی مانند PromptLayer و LangChain Expression Language به مدیریت سریع کمک میکنند.

- لایه ارزیابی: دقت بازیابی و ارتباط پاسخ را با استفاده از چارچوبهایی مانند TruLens یا Weights & Biases اندازهگیری میکند.

- لایه نظارت: معیارهای عملکرد سیستم (به عنوان مثال، تأخیر، استفاده از منابع) را ردیابی میکند و خرابیها را با استفاده از ابزارهایی مانند ARISE یا Galileo شناسایی میکند.

- لایه امنیت و حریم خصوصی: حفاظهایی را در برابر تزریق سریع، مسمومیت دادهها و نقض حریم خصوصی پیادهسازی میکند. راه حلها شامل دستورالعملهای OWASP و تکنیکهای حریم خصوصی افتراقی هستند.

- لایه ذخیرهسازی: با ذخیره پاسخهای پرس و جوهای مکرر در حافظههای معنایی، تأخیر و هزینه را کاهش میدهد.

لایههای ارتقا

لایههای اختیاری اما ارزشمند متناسب با موارد استفاده خاص:

- انسان در حلقه: نظارت را برای برنامههای با ریسک بالا که نیاز به دقت تقریباً کامل دارند، فراهم میکند.

- قابلیت توضیح: شفافیت در تصمیمگیری را بهبود میبخشد، که برای صنایع تنظیمشده مانند مراقبتهای بهداشتی یا مالی بسیار مهم است.

- لایه چندوجهی: انواع دادههای غیر متنی (به عنوان مثال، تصاویر، ویدئوها) را در خط لوله RAG ادغام میکند.

- بهینهسازی هزینه: منابع را برای سیستمهای در مقیاس بزرگ به طور کارآمد مدیریت میکند.

بهترین شیوهها برای پیادهسازی RAG

برای اطمینان از موفقیت سیستم RAG خود، این بهترین شیوهها را در نظر بگیرید:

- به تأخیر رسیدگی کنید: از طبقهبندی پرس و جو، فیلتر کردن بازیابی ترکیبی و ذخیرهسازی برای به حداقل رساندن تأخیر در طول تعامل استفاده کنید.

- توهم را کاهش دهید: اعتبارسنجیهای پس از تولید را برای دامنههای پرخطر پیادهسازی کنید.

- برای مقیاسپذیری برنامهریزی کنید: از پایگاههای داده برداری مقیاسپذیر خودکار و راه حلهای ابری برای مدیریت دادههای رو به رشد و تقاضای کاربران استفاده کنید.

- حریم خصوصی و امنیت را تضمین کنید: از ناشناسسازی، رمزگذاری و پوشاندن PII برای محافظت از اطلاعات حساس استفاده کنید.

نتیجهگیری

تولید مبتنی بر بازیابی یک تکنیک متحول کننده است که شکافهای موجود در قابلیتهای LLM را با تکمیل دانش داخلی با منابع داده خارجی پر میکند. با استفاده از یک پشته RAGOps مدولار، توسعهدهندگان میتوانند سیستمهای مقیاسپذیر، قابل اعتماد و با عملکرد بالا متناسب با موارد استفاده مختلف بسازند. همانطور که چشمانداز هوش مصنوعی مولد تکامل مییابد، ابزارها و شیوههای پیادهسازی RAG نیز تکامل مییابند و آن را به فضایی هیجانانگیز برای تماشا و نوآوری تبدیل میکنند.

چه چالشها یا لایههای اضافی را در ساخت سیستمهای RAG آینده پیشبینی میکنید؟ نظرات و بینش خود را به اشتراک بگذارید!

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: medium