عاملهای هوش مصنوعی دیگر صرفاً ابزارهای ساده نیستند، بلکه با قابلیت تقلید شخصیتها و تصمیمگیری مستقل، به بخشی فعال از زندگی ما تبدیل میشوند. اما این پیشرفتها چالشهای اخلاقی جدی به همراه دارند – از دیپفیکهای مضر گرفته تا تضمین شفافیت در تعاملات انسان و هوش مصنوعی. این مقاله چالشهای اخلاقی مرتبط با عاملهای هوش مصنوعی و ضرورت پرداختن به آنها پیش از پذیرش کامل در جامعه را بررسی میکند.

ظهور عاملهای هوش مصنوعی: فرصتها و معضلات اخلاقی

در سالهای اخیر، هوش مصنوعی مولد (Generative AI) ما را با توانایی خود در ایجاد مکالمات واقعی، تصاویر خیرهکننده و حتی موسیقیهای بدیع، شگفتزده کرده است. اما در حالی که این ابزارها چشمگیر بودهاند، در درجه اول بر تولید محتوا به جای انجام وظایف متمرکز شدهاند. عاملهای هوش مصنوعی وارد میشوند – یک تحول پیشگامانه که نوید میدهد هوش مصنوعی را از کمک غیرفعال به استقلال فعال تبدیل کند.

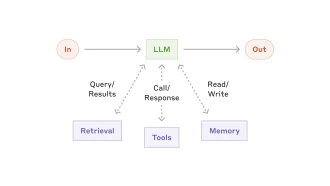

عاملهای هوش مصنوعی با اهداف و قابلیتهای خاص طراحی شدهاند و آنها را قادر میسازد تا وظایفی را از طرف ما انجام دهند. دو نوع اصلی از عاملهای هوش مصنوعی پدیدار شدهاند:

عاملهای مبتنی بر ابزار

این عاملها وظایف دیجیتال را با استفاده از دستورالعملهای زبان طبیعی انجام میدهند و نیاز به تخصص برنامهنویسی را از بین میبرند. برای مثال:

– عامل Anthropic: در ماه اکتبر منتشر شد، این عامل میتواند در رایانه پیمایش کند، دادهها را جمعآوری کند و وظایفی مانند پر کردن فرمها را انجام دهد.

– مشارکت Salesforce: نمونه دیگری از عاملهای مبتنی بر ابزار که فرآیندهای پیچیده را ساده میکنند.

– انتشار آتی OpenAI: انتظار میرود در ژانویه، این امر نشاندهنده رقابت بین غولهای فناوری برای تسلط بر این فضا است.

عاملهای شبیهسازی

برخلاف عاملهای مبتنی بر ابزار، عاملهای شبیهسازی با هدف تقلید رفتار انسان هستند. این عاملها که در ابتدا توسط دانشمندان علوم اجتماعی برای تحقیق توسعه داده شدند، از آن زمان به بعد تکامل یافتهاند تا شخصیتهای فردی را با دقت خارقالعادهای تکرار کنند. یک مطالعه محوری از دانشگاه استنفورد در سال ۲۰۲۳ مفهوم “عاملهای مولد” را معرفی کرد – هوش مصنوعی طراحی شده برای شبیهسازی تعاملات انسانی. در آخرین تحقیقات خود، این تیم با موفقیت عاملهای شبیهسازی را بر اساس مصاحبه با ۱۰۰۰ شرکتکننده ایجاد کرد و ارزشها و ترجیحات آنها را با دقت قابلتوجهی منعکس کرد.

محو شدن مرزها: وقتی هوش مصنوعی از طرف شما عمل میکند

همگرایی این دو نوع عامل میتواند منجر به موجودیتهای هوش مصنوعی شود که نه تنها شخصیت شما را تقلید میکنند، بلکه تصمیم میگیرند و مانند شما عمل میکنند. شرکتهایی مانند Tavus در حال حاضر با توسعه “دوقلوهای دیجیتال” که قادر به نمایندگی افراد در نقشهای مختلف، از درمانگر گرفته تا معلم، هستند، در حال کاوش در این مرز هستند.

در حالی که این پیشرفتها امکانات هیجانانگیزی را ایجاد میکنند، سؤالات اخلاقی مبرمی را نیز مطرح میکنند:

۱. معضل دیپفیک

عاملهای هوش مصنوعی که قادر به تکرار صداها، رفتارها و شخصیتها هستند، میتوانند بحران دیپفیک را تشدید کنند. تصور کنید که چقدر آسان میتوان از چنین فناوری برای ایجاد محتوای مضر یا فریبنده، از پورنوگرافی بدون رضایت گرفته تا کلاهبرداری جعل هویت، سوءاستفاده کرد. محققانی مانند تیم استنفورد با مشورت با هیئتهای اخلاق و وضع سیاستهای لغو دادهها اقدامات احتیاطی را انجام میدهند – اما آیا این اقدامات کافی خواهد بود؟

۲. شفافیت در تعاملات انسان و هوش مصنوعی

از آنجایی که عاملهای هوش مصنوعی از انسان قابل تشخیص نیستند، جامعه با یک سؤال اساسی روبرو است: آیا ما سزاوار دانستن این هستیم که چه زمانی با یک هوش مصنوعی در تعامل هستیم؟ سناریوهایی را در نظر بگیرید که در آن:

– یک دوست از یک دوقلوی دیجیتال برای پاسخ دادن به پیامها از طرف خود استفاده میکند. آیا باید به شما اطلاع داده شود؟

– نمایندگان خدمات مشتری با عاملهای هوش مصنوعی جایگزین میشوند. آیا شرکتها باید این موضوع را افشا کنند؟

شفافیت برای حفظ اعتماد حیاتی خواهد بود، اما اجرای آن با فراگیرتر شدن هوش مصنوعی ممکن است چالش برانگیز باشد.

مسیر پیش رو

در حالی که این نگرانیهای اخلاقی آیندهنگرانه به نظر میرسند، سرعت سریع توسعه هوش مصنوعی نشان میدهد که آنها ممکن است زودتر از آنچه فکر میکنیم به ما برسند. شرکتهایی مانند Tavus جهانی را تصور میکنند که در آن ایجاد عاملهای هوش مصنوعی شخصیسازی شده هم ارزان و هم در دسترس است – و این امر اهمیت رسیدگی به این چالشها را اکنون افزایش میدهد.

چرا اهمیت دارد

پیامدهای عاملهای هوش مصنوعی بسیار فراتر از راحتی یا کارایی است. همانطور که آنها بیشتر در زندگی ما ادغام میشوند، نحوه تعامل ما با دیگران و نحوه درک ما از اصالت را تغییر میدهند. این گذار مستلزم بررسی دقیق چارچوبهای اخلاقی است تا اطمینان حاصل شود که مزایای عاملهای هوش مصنوعی به قیمت حریم خصوصی، اعتماد یا کرامت انسانی تمام نمیشود.

در همین حال، همانطور که به این آینده نزدیکتر میشویم، ارزش این را دارد که تأمل کنیم که یک مصاحبهکننده هوش مصنوعی چقدر میتواند شما را فقط در دو ساعت درک کند – و این چه معنایی برای جهانی که در حال ساخت آن هستیم دارد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: mit technology review