نظریه موج-ذره لویی دوبروی، دریچهای نوین به مکانیک کوانتومی (Quantum Mechanics) گشود و تفسیرهای مرسوم را به چالش کشید. با وجود اینکه دوبروی به دلیل پیچیدگی نظریهاش، آن را کنار گذاشت، اما کار او الهامبخش دیوید بوهم شد و همچنان فیزیک مدرن را شکل میدهد و کاوشهای ژرفتری را در مورد دوگانگی موج-ذره میطلبد.

لویی دوبروی: مسیر پر فراز و نشیب یک فیزیکدان آیندهنگر

نقش لویی دوبروی، فیزیکدان فرانسوی، در مکانیک کوانتومی همچنان ستودنی است. پایاننامه دکترای پیشگامانه او در مورد دوگانگی موج-ذره الکترونها که یک قرن پیش ارائه شد، جایزه نوبل را برای او به ارمغان آورد و شالوده نظریه کوانتومی (Quantum Theory) را بنا نهاد. با این حال، مسیر دوبروی با نوآوری و تردید توأم بود، که منجر به کنار گذاشتن نظریه موج هدایتگر خود شد – تصمیمی که هنوز دانشمندان را شگفتزده میکند.

دوگانگی موج-ذره و رازهای کوانتومی

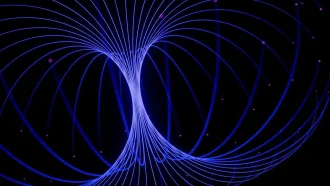

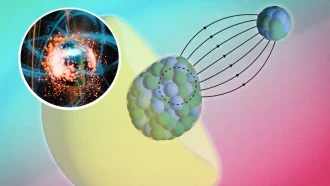

مکانیک کوانتومی در اوایل قرن بیستم به عنوان چارچوبی انقلابی برای درک ماده در مقیاسهای میکروسکوپی پدیدار شد. یکی از گیجکنندهترین مفاهیم آن، دوگانگی ذرات کوانتومی، مانند الکترونها، است که بسته به نحوه مشاهده، رفتار ذرهمانند و موجمانند از خود نشان میدهند. این ماهیت دوگانه، فیزیک کلاسیک را زیر سوال برد و نیاز به تفسیرهای جدید را ایجاد کرد.

تفسیر کپنهاگ به توضیح غالب تبدیل شد و ادعا کرد که پدیدههای کوانتومی را نمیتوان با منطق کلاسیک درک کرد. در حالی که به طور گسترده پذیرفته شد، بسیاری از دانشمندان، از جمله آلبرت انیشتین و لویی دوبروی، را بر آن داشت تا به دنبال چارچوبهای جایگزینی باشند که بتوانند درک روشنتر و قطعیتری از رفتار کوانتومی ارائه دهند.

نظریه موج هدایتگر دوبروی

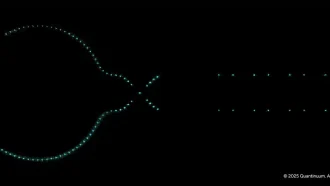

در سال ۱۹۲۷، دوبروی نظریه موج هدایتگر خود را معرفی کرد، جایگزینی جسورانه برای تفسیر کپنهاگ. این مدل پیشنهاد میکرد که ذرات توسط یک “موج کوانتومی” بنیادی هدایت میشوند که مسیر آنها را تعیین میکند. دوبروی با ربط دادن حرکت ذرات به یک موج هدایتگر نامرئی، توضیحی محتمل برای خواص موجمانند اسرارآمیز ذرات ارائه داد.

با این حال، این نظریه با چالشهایی روبرو بود:

- غیرموضعی بودن (Nonlocality): موج هدایتگر نشان میداد که حرکت یک ذره میتواند به وضعیت ذره دیگری وابسته باشد، حتی اگر با فواصل بسیار زیادی از هم جدا شده باشند – مفهومی که ظاهراً با نظریه نسبیت انیشتین در تناقض بود.

- پیچیدگی انتزاعی: برخلاف امواج معمولی در فضای سه بعدی، موج هدایتگر در یک فضای ریاضی چند بعدی بسیار انتزاعی وجود داشت، که درک فیزیکی آن را دشوار میکرد.

این پیچیدگیها دوبروی را دچار تردید کرد، که در نهایت این نظریه را به نفع کاوش در یک مفهوم جدید کنار گذاشت: “نظریه راه حل دوگانه”.

نظریه راه حل دوگانه: یک نگاه جدید

نظریه راه حل دوگانه دوبروی با ارائه رویکردی ملموستر، به دنبال پرداختن به انتزاعی بودن موج هدایتگر بود. این مدل یک موج فیزیکی را در فضای سه بعدی ملموس تصور میکرد و ارتباط واضحتری با پدیدههای قابل مشاهده برقرار میساخت.

با این حال، این چارچوب بلندپروازانه از نظر ریاضی پیچیده بود و در طول زندگی دوبروی نتوانست توجه جامعه علمی را به خود جلب کند. با وجود شناخت محدود، او تا پایان عمر خود به اصلاح نظریه راه حل دوگانه مشغول بود.

بازآفرینی توسط دیوید بوهم و تأثیر ماندگار

اگرچه دوبروی از نظریه موج هدایتگر فاصله گرفت، اما اهمیت آن دههها بعد دوباره آشکار شد. در سال ۱۹۵۲، دیوید بوهم، فیزیکدان آمریکایی، به طور مستقل این مفهوم را بازیابی و گسترش داد و آن را به چیزی تبدیل کرد که اکنون به عنوان مکانیک بوهمی شناخته میشود.

کار بوهم، غیرموضعی بودن و ماهیت انتزاعی موج هدایتگر را پذیرفت و الهامبخش موج جدیدی از تحقیقات در مورد پرسشهای بنیادین مکانیک کوانتومی شد. امروزه، نظریه موج هدایتگر موضوع پژوهشهای فعال است و محققان به دنبال تطبیق نتایج آن با فیزیک مدرن هستند.

در عین حال، نظریه راه حل دوگانه دوبروی کاملاً به فراموشی سپرده نشده است. فیزیکدانان معاصر همچنان به بررسی پتانسیل آن برای پر کردن خلاهای موجود در درک ما از پدیدههای کوانتومی در عین حفظ شهود کلاسیک ادامه میدهند.

میراث کنجکاوی و نوآوری

سیر تحولات لویی دوبروی گواهی بر پیچیدگیهای پیشرفت علمی است. تمایل او به زیر سوال بردن هنجارهای تثبیت شده و کاوش در ایدههای نامتعارف، زمینه را برای پیشرفتهای شگرف در مکانیک کوانتومی فراهم کرد. در حالی که او ممکن است به نظریههای خود تردید میورزید، تأثیر ماندگار آنها بر قدرت کنجکاوی و پشتکار در شکلدهی به درک ما از جهان تأکید میکند.

همانطور که محققان به بررسی رازهای دوگانگی موج-ذره و رفتار کوانتومی ادامه میدهند، میراث دوبروی یادآوری الهامبخشی از ماهیت پیوسته در حال تحول علم است. دستاوردهای او ما را فرا میخواند تا با عدم قطعیت کنار بیاییم، فرضیات را به چالش بکشیم و مرزهای دانش بشری را گسترش دهیم.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: scitechdaily