کشف کنید چگونه یکپارچهسازی یادگیری ماشین میتواند به شرکتها در بهبود سیستمهای نرمافزاری کمک کند. با بررسی مفاهیم کلیدی، ابزارهای پیشرفته و استراتژیهای عملی، به چالشهایی مانند سازگاری با سیستمهای قدیمی و مقیاسپذیری پرداخته و راهکارهایی برای تضمین یکپارچهسازی بینقص ارائه خواهیم داد.

یکپارچهسازی یادگیری ماشین در سیستمهای نرمافزاری موجود

یادگیری ماشین (ML) با شخصیسازی دقیق، خودکارسازی پیشرفته و افزایش بهرهوری فرآیندها، صنایع را متحول میکند. همزمان با گسترش روزافزون بهکارگیری فناوریهای هوش مصنوعی توسط سازمانها، یکپارچهسازی ML در سیستمهای موجود آنها برای حفظ مزیت رقابتی امری حیاتی است. با این حال، این فرآیند خالی از چالش نیست – سازگاری با سیستمهای قدیمی، مقیاسپذیری، مدیریت هزینه و مدیریت دادهها، همگی از جمله این چالشها هستند. در این راهنما، به بررسی مفاهیم، ابزارها و استراتژیهایی میپردازیم که میتوانند یکپارچهسازی ML را نه تنها امکانپذیر، بلکه موفقیتآمیز سازند.

مفاهیم کلیدی یکپارچهسازی

پیش از ورود به فرآیند یکپارچهسازی، درک برخی از مفاهیم بنیادی ضروری است. این الگوها چارچوبی را برای جایگذاری موثر مدلهای ML در پلتفرمهای موجود فراهم میکنند:

۱. معماریهای مبتنی بر میکروسرویسها و کانتینرها

- میکروسرویسها (Microservices): واحدهای کوچک و مستقلی از عملکرد هستند که در کنار هم یک برنامه بزرگتر را تشکیل میدهند. با در نظر گرفتن مدلهای ML به عنوان میکروسرویسهای مجزا، سازمانها میتوانند مقیاسپذیری و سهولت نگهداری را افزایش دهند.

- کانتینرها (Containers): ابزارهایی مانند Docker و Kubernetes نرمافزار و وابستگیهای آن را در واحدهای قابل حمل کپسولهسازی میکنند. کانتینرها محیطهای سازگار را در بین پلتفرمهای مختلف تضمین میکنند و استقرار مدلهای ML را تسهیل مینمایند.

ترکیب میکروسرویسها و کانتینرسازی امکان معماری ماژولار را فراهم میکند، بهگونهای که مدلهای ML میتوانند بدون ایجاد اختلال در کل سیستم، بهطور مستقل بهروزرسانی یا مقیاسپذیر شوند.

۲. APIها و سرویسهای RESTful

- APIها مدلهای ML را قادر میسازند تا با سایر اجزای یک سیستم تعامل داشته باشند. به عنوان مثال، یک REST API میتواند قابلیتهای پیشبینی یک مدل را در معرض دید قرار دهد و به برنامههای دیگر اجازه دهد درخواستهای HTTP ارسال کنند و نتایج را دریافت کنند.

- این رویکرد ماژولار، انعطافپذیری و قابلیت استفاده مجدد را تضمین میکند، زیرا مدلها به عنوان سرویسهای مستقل در چارچوب نرمافزاری گستردهتر عمل میکنند.

۳. MLOps: عملیات یادگیری ماشین (Machine Learning Operations)

MLOps شکاف بین توسعه ML و عملیات فناوری اطلاعات را پر میکند. این فرآیند، چرخه حیات مدلهای ML، از توسعه تا استقرار و نظارت مداوم را ساده میکند. جنبههای کلیدی عبارتند از:

– یکپارچهسازی و استقرار مداوم (CI/CD) برای بهروزرسانیهای بدون وقفه.

– جریانهای کاری خودکار برای کارهایی مانند آمادهسازی دادهها، اعتبارسنجی مدل و آموزش مجدد.

– اطمینان از همخوانی مدلها با دادههای در حال تکامل و نیازهای تجاری.

ابزارهای یکپارچهسازی مدل ML

برای یکپارچهسازی موفقیتآمیز مدلهای ML، استفاده از ابزارهای مناسب بسیار حائز اهمیت است. در اینجا خلاصهای از برخی از گزینههای محبوب ارائه شده است:

چارچوبها و کتابخانههای ML

- TensorFlow و PyTorch: این کتابخانههای جامع، از توسعه و استقرار مدل پشتیبانی میکنند.

- Scikit-learn: ایدهآل برای مدلهای سبک، سادگی و سازگاری بین پلتفرمی را ارائه میدهد.

ابزارهای کانتینرسازی و هماهنگسازی

- Docker: مدلها را با وابستگیها در کانتینرهای قابل حمل بستهبندی میکند و استقرار را ساده میکند.

- Kubernetes: هماهنگسازی مقیاسپذیر را برای مدیریت موثر منابع در محیطهای تولیدی تضمین میکند.

پلتفرمهای MLOps

- Kubeflow: ساخته شده بر روی Kubernetes، کل چرخه حیات ML را مدیریت میکند.

- MLflow: بر ردیابی آزمایش، رجیستری مدل و خطوط لوله استقرار تمرکز دارد.

سرویسهای ابری

پلتفرمهای ابری مانند AWS SageMaker، Google AI Platform (Vertex AI) و Azure ML راهحلهای جامعی را برای آموزش، استقرار و نظارت بر مدلهای ML ارائه میدهند. این ابزارها به طور یکپارچه با سایر سرویسهای ابری ادغام میشوند و یک بستر یکپارچه را برای سازمانهایی که در محیطهای ابری فعالیت میکنند، فراهم میکنند.

کاربرد دنیای واقعی: مطالعه موردی تجارت الکترونیک

یک پلتفرم تجارت الکترونیک را در نظر بگیرید که قصد دارد سیستم پیشنهاد محصول خود را بهبود بخشد. با یکپارچهسازی یک مدل ML که ترجیحات کاربر، تاریخچه خرید و الگوهای رفتاری را تجزیه و تحلیل میکند، شرکت میتواند پیشنهادات شخصیسازی شده ارائه دهد. در اینجا نحوه دستیابی به آن آمده است:

- معماری: یک ساختار میکروسرویس پیادهسازی شد و موتور توصیه به عنوان یک سرویس مستقل قابل دسترسی از طریق REST API مستقر شد.

- ابزارهای مورد استفاده:

- Docker برای بستهبندی مدل و وابستگیهای آن.

- Kubernetes برای هماهنگسازی سرویسهای کانتینری شده.

- TensorFlow برای توسعه و آموزش مدل توصیه.

- نتایج:

- بهروزرسانیهای بدون وقفه مدل بدون ایجاد اختلال در سیستم.

- افزایش تعامل کاربر و نرخ تبدیل بالاتر.

این رویکرد، قدرت ماژولار بودن و مقیاسپذیری را در یکپارچهسازی مدلهای ML در سیستمهای پیچیده نشان میدهد.

غلبه بر چالشها در یکپارچهسازی ML

در حالی که مزایا آشکار است، یکپارچهسازی ML در سیستمهای موجود با مجموعهای از چالشهای خاص خود همراه است:

سازگاری با سیستمهای قدیمی

- سیستمهای قدیمیتر ممکن است فاقد زیرساخت لازم برای پشتیبانی از مدلهای ML مدرن باشند.

- میانافزار یا APIها میتوانند به عنوان پل ارتباطی برای اتصال سیستمهای قدیمی با قابلیتهای جدید ML عمل کنند.

حریم خصوصی دادهها و انطباق

- مدیریت دادههای دنیای واقعی نگرانیهایی در مورد حریم خصوصی و پیچیدگیهای نظارتی بهوجود میآورد.

- سازمانها باید هنگام استفاده از مدلهای ML، انطباق با مقررات حفاظت از دادهها را تضمین کنند.

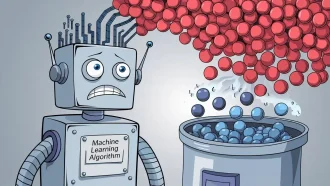

انحراف دادهها و نظارت بر مدل

- با گذشت زمان، تغییرات در الگوهای دادهها میتواند دقت مدل را کاهش دهد. این پدیده که به عنوان انحراف دادهها شناخته میشود، نیاز به بهروزرسانی و آموزش مجدد دوره ای مدل دارد.

- ابزارهای نظارت مداوم برای شناسایی و رفع این مسائل به صورت پیشگیرانه ضروری هستند.

نکات پایانی

یکپارچهسازی مدلهای ML در سیستمهای نرمافزاری موجود، گامی تحولآفرین برای سازمانهایی است که به دنبال نوآوری و بهبود بهرهوری عملیاتی هستند. با اتخاذ معماریهای ماژولار، استفاده از ابزارهای قدرتمند و مقابله مستقیم با چالشها، شرکتها میتوانند فرآیندهای یکپارچهسازی روان را تضمین کنند. خواه بهبود تجربه مشتری از طریق توصیههای شخصیسازی شده باشد یا خودکارسازی جریانهای کاری، پتانسیل یکپارچهسازی ML بسیار بالا است. نکته کلیدی داشتن رویکردی استراتژیک است – ایجاد تعادل بین ملاحظات فنی با اهداف تجاری برای به حداکثر رساندن تاثیر.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: kdnuggets