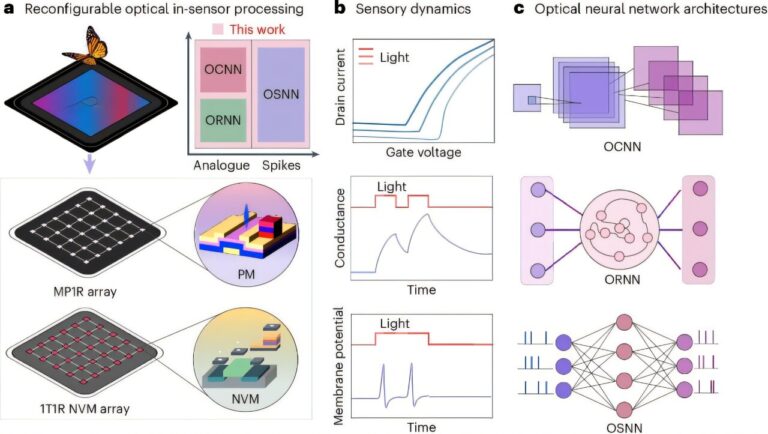

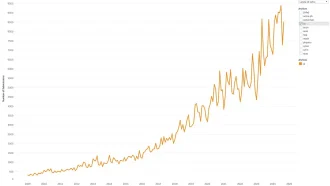

محققان دانشگاه پکن از پلتفرمی پیشگام رونمایی کردهاند که محاسبات و حسگری را در یک سیستم قابل پیکربندی مجدد ادغام میکند. این فناوری نوین از معماریهای مختلف شبکه عصبی پشتیبانی کرده و با الهام از سیستمهای بینایی بیولوژیکی، پردازش تصویر را به شکلی کارآمد و در زمان واقعی ممکن میسازد.

یک گام بلند در سیستمهای بینایی نورومورفیک

در دنیای رو به پیشرفت یادگیری ماشین و هوش مصنوعی، نوآوری در سختافزار برای پاسخگویی به نیازهای محاسباتی روزافزون، امری حیاتی است. سیستمهای سنتی اغلب با ناکارآمدیهایی ناشی از جدایی بین حسگرها، حافظه و پردازندهها مواجه هستند. این محدودیت، تحقیقات در مورد راهحلهای الهام گرفته از زیستشناسی – سیستمهایی که از یکپارچگی حسگری و پردازش در چشم انسان الگوبرداری میکنند – را سوق داده است. محققان دانشگاه پکن اکنون یک پلتفرم محاسبات نورومورفیک پیشرفته را معرفی کردهاند که عملکردهای حسگری، حافظه و پردازش را در یک دستگاه واحد ادغام میکند.

این دستاورد: یک پلتفرم پردازش درون-حسگر قابل پیکربندی مجدد

نکته کلیدی این نوآوری در معماری آن نهفته است. این سیستم یک آرایه 20×20 از فتوترانزیستورها را با ممریستورها ترکیب میکند. این پیکربندی که آرایه MP1R نامیده میشود، حسگری و محاسبات را در هم میآمیزد و به آن اجازه میدهد تا وظایف متنوعی از تشخیص تصویر گرفته تا تحلیل دادهها را انجام دهد.

ویژگیهای برجستهی پلتفرم:

- آرایه فتوترانزیستور:

این پلتفرم از ترانزیستورهای فیلم نازک اکسید روی-ایندیوم-گالیوم-روی آمورف (α-IGZO) برای ایجاد آرایهای از فتوترانزیستورها استفاده میکند که قادر به حس کردن نور و تنظیم پاسخ آن بر اساس طول موج است. برای مثال: - قرار گرفتن در معرض نور آبی: رفتار تقویت را فعال میکند.

-

قرار گرفتن در معرض نور قرمز: رفتار تضعیف را القا میکند.

-

ممریستورهای مات:

این ممریستورها که با آرایه فتوترانزیستور یکپارچه شدهاند، از ناهمگونیهای Ta/TaOx/NbOx/W ساخته شدهاند. آنها موارد زیر را ارائه میدهند: - نواحی مقاومتی خطی.

- قابلیتهای حافظه فرار.

- ویژگیهای سوئیچینگ آستانه.

این ترکیب، سیستم را قادر میسازد تا از روشهای مختلف رمزگذاری – آنالوگ، مبتنی بر سنبله و مکانی-زمانی – پشتیبانی کند و همزمان عملکردهای سیناپسی و نورونی را به طور مؤثر شبیهسازی کند.

پیوند زیستشناسی و یادگیری ماشین

این پلتفرم جدید از سیستمهای بینایی بیولوژیکی مانند چشم انسان الهام گرفته است، که کارایی قابل توجهی در پردازش تصویر در زمان واقعی نشان میدهند. برخلاف سیستمهای محاسباتی بینایی معمول مبتنی بر معماری CMOS von Neumann – که از افزونگی دادهها، مصرف بالای انرژی و تأخیر رنج میبرند – این رویکرد زیستشناختی، عملکردها را در یک دستگاه واحد متمرکز میکند.

سازگاری با معماریهای عصبی متنوع:

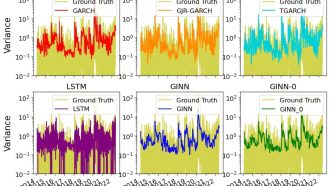

یکی از جنبههای برجستهی این سیستم، انعطافپذیری آن است. از طیف گستردهای از معماریهای شبکه عصبی پشتیبانی میکند، از جمله:

– شبکههای عصبی کانولوشن (CNNs): مناسب برای کارهای تشخیص تصویر و ویدئو.

– شبکههای عصبی بازگشتی (RNNs): مفید برای پردازش دادههای سریالی یا زمانی.

– شبکههای عصبی سنبلهای (SNNs): فعالیت نورون بیولوژیکی را برای دادههای مبتنی بر رویداد شبیهسازی میکنند.

این تطبیقپذیری تضمین میکند که پلتفرم میتواند الگوریتمهای یادگیری ماشین و الگوهای محاسباتی الهام گرفته از زیستشناسی را در خود جای دهد.

پیامدها برای کاربردهای دنیای واقعی

پیامدهای این نوآوری بسیار وسیع است. محققان با ادغام حسگری و پردازش در یک دستگاه واحد به موارد زیر دست یافتهاند:

- کاهش پیچیدگی شبکه: ادغام اصول پردازش، طراحی سیستم را ساده میکند.

- کاهش تأخیر: پردازش تصویر در زمان واقعی کارآمدتر میشود.

- بهینهسازی مصرف انرژی: سیستم انرژی کمتری مصرف میکند و آن را برای کاربردهای حساس به انرژی مناسب میسازد.

این مزایا، این پلتفرم را به ویژه برای کاربردهای پیشرفته هوش مصنوعی بینایی، مانند وسایل نقلیه خودران، رباتیک و سیستمهای نظارتی، نویدبخش میکند.

چالشها و مسیرهای آینده

علیرغم دستاوردهای آن، این پلتفرم هنوز در مراحل ابتدایی توسعه خود است. چندین چالش باقی مانده است، از جمله:

- چگالی سیستم و کارایی محاسباتی: محققان قصد دارند ادغام سهبعدی را برای افزایش این جنبهها بررسی کنند.

- بهینهسازی مصرف انرژی: پیشرفتهای بیشتری برای کارآمدتر کردن سیستم از نظر انرژی مورد نیاز است.

- سازگاری در شرایط کمنور: افزایش حساسیت به تغییرات نور، قابلیت استفاده آن را در محیطهای طبیعی و کمنور گسترش میدهد.

تیم دانشگاه پکن به غلبه بر این موانع امیدوار است. تلاشهای مستمر آنها میتواند زمینهساز سیستمهای بینایی نورومورفیک مقیاسپذیر در مقیاس بزرگ باشد.

چشماندازی برای آینده

این کار پیشگامانه گامی اساسی به سوی پلتفرمهای محاسباتی بینایی نورومورفیک فراگیر است. محققان با پر کردن شکاف بین سیستمهای الهام گرفته از زیستشناسی و الگوهای یادگیری ماشین، امکانات جدیدی را برای کاربردهای هوش مصنوعی در زمان واقعی و با مصرف انرژی کارآمد گشودهاند.

همانطور که آنها به اصلاح فناوری خود ادامه میدهند، میتوانیم پیشرفتهای بیشتری را در ادغام حسگری و محاسبات پیشبینی کنیم – که راه را برای ماشینهای هوشمندتر، سریعتر و سازگارتر هموار میکند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techxplore.com