دانشمندان اخیراً شواهدی کشف کردهاند که نشان میدهد LLVP های زمین، مناطقی اسرارآمیز و عظیم در نزدیکی هستهی زمین، ممکن است بقایای سیارهی تیا باشند. تیا، سیارهای کهن است که میلیاردها سال پیش با زمین برخورد کرده و تأثیر عمیقی بر شکلگیری سیارهی ما گذاشته است. این یافتهها افق جدیدی در درک ما از تاریخچهی زمین و تکامل اولیهی آن میگشاید.

سیارهی کهن پنهان در زمین

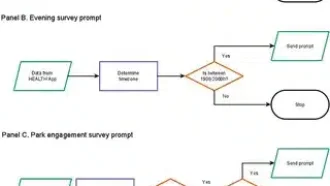

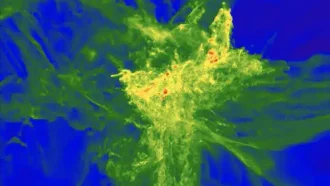

داستانی از برخورد و تحول کیهانی در اعماق زمین نهفته است. تحقیقات جدید نشان میدهد دو ساختار عظیم نزدیک هستهی زمین، که LLVP (مناطق وسیع با سرعت کم) نام دارند، میتوانند نشانههایی از یک برخورد سیارهای کهن را در خود داشته باشند. این ناهنجاریها که به بزرگی یک قاره هستند، در زیر آفریقا و اقیانوس آرام قرار دارند. آنها امواج لرزهای را با سرعت کمتری منتقل میکنند و ترکیبی متفاوت دارند. به همین دلیل، دانشمندان را دههها مجذوب خود کردهاند. حالا، یک مطالعهی جدید میگوید این مناطق میتوانند بقایای تیا، سیارهای گمشده که در دوران اولیهی تشکیل زمین با آن برخورد کرده، باشند.

برخورد کیهانی که جهان ما را ساخت

میلیاردها سال پیش، یک رویداد آسمانی بزرگ رخ داد: جرمی به اندازهی یک سیاره، به نام تیا، با زمین اولیه برخورد کرد. گمان میرود این برخورد عظیم منجر به تشکیل ماه شده و نقش مهمی در شکلگیری و تکامل اولیهی زمین داشته است. اما تا همین اواخر، سرنوشت بقایای تیا یک راز بود.

یک مطالعهی پیشگامانه در Nature منتشر شده که نشان میدهد بخشهایی از گوشتهی تیا در هنگام برخورد جذب درون زمین شده است. این بخشهای چگال، در نهایت در اعماق گوشته فرو رفته و LLVP ها را تشکیل دادهاند. این کشف، یک جای خالی مهم در درک ما از تشکیل زمین و فرآیندهایی که تکامل سیارهای را هدایت میکنند، پر میکند.

کشف LLVP ها

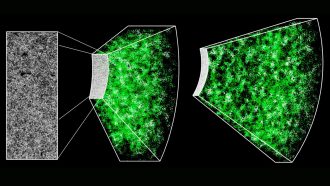

محققان با استفاده از روشهای پیشرفتهی تصویربرداری لرزهای، دو منطقهی عظیم نزدیک هستهی زمین را شناسایی کردند که با گوشتهی اطراف متفاوت هستند. این LLVP ها آهن بیشتری دارند و ۲ تا ۳.۵ درصد چگالترند. به همین دلیل در گوشتهی پایینی زمین پایدارترند. ویژگیهای خاص آنها مدتهاست زمینشناسان را شگفتزده کرده، اما این نظریهی جدید توضیح قانعکنندهای برای منشأ آنها ارائه میدهد.

تیم تحقیقاتی، به رهبری متخصصانی از Caltech، از شبیهسازیهای پیچیدهای برای مدلسازی برخورد تیا با زمین استفاده کردند. آنها با بررسی ویژگیهای گوشتهی تیا و نحوهی تعامل آن با درون زمین در طول برخورد، دریافتند که بخشهایی از مواد تیا احتمالاً به شکل تودههای چگال جدا شدهاند. این قطعات، که از انرژی شدید برخورد در امان مانده بودند، به تدریج به گوشتهی پایینی فرو رفتند و میلیاردها سال دست نخورده باقی ماندند.

چرا بقایای تیا پراکنده نشد؟

یکی از نکات جالب این مطالعه، این است که چطور مواد تیا با گوشتهی زمین مخلوط نشد. شبیهسازیها نشان داد گوشتهی پایینی خنکتر زمین مانند یک سپر عمل کرده و انرژی کمتری از برخورد جذب کرده است. به این ترتیب، به قطعات غنی از آهن اجازه داده تا تقریباً بدون تغییر باقی بمانند. این با گوشتهی بالایی که اختلاط و آشفتگی پرانرژیتری را تجربه کرده، متفاوت است.

با تجمع این قطعات چگال، LLVP هایی که امروز میبینیم تشکیل شدهاند. این یافته نه تنها ترکیب آنها را توضیح میدهد، بلکه پایداری آنها در مقیاسهای زمانی زمینشناسی را نیز روشن میکند.

فراتر از زمین: پیامدهایی برای علوم سیارهای

پیامدهای این کشف فراتر از سیارهی ماست. اگر بقایای تیا LLVP های زمین را تشکیل داده باشد، ساختارهای مشابهی ممکن است در سیارات دیگری که برخوردهای عظیمی را تجربه کردهاند، وجود داشته باشد. این ناهمگونیهای گوشته میتوانند سرنخهای ارزشمندی دربارهی تاریخچهی اولیه و دینامیک داخلی دیگر اجرام آسمانی ارائه دهند.

برای زمین، LLVP ها چیزی بیشتر از کنجکاویهای زمینشناسی هستند – آنها ممکن است نقش مهمی در تکامل سیاره داشته باشند. از تأثیر بر تکتونیک صفحهای گرفته تا کمک به پیدایش قارهها و حتی تأثیر بر میدان مغناطیسی زمین، این ساختارهای عمیق گوشته، شاهدانی خاموش از آغاز پرآشوب سیارهی ما هستند.

دریچهای به گذشتهی پر تلاطم زمین

این تحقیق بر ارتباط متقابل فرآیندهای سیارهای تأکید میکند و تصویر واضحتری از چگونگی هدایت تحولات توسط برخوردهای کیهانی ارائه میدهد. دانشمندان با ارتباط دادن برخورد تشکیلدهندهی ماه به LLVP ها، گام مهمی در کشف اسرار درون زمین برداشتهاند.

Paul Asimow، یکی از نویسندگان این مطالعه، بر اهمیت درک چگونگی تأثیر این ساختارهای عمیق بر زمین در طول میلیاردها سال تأکید میکند. LLVP ها گواهی بر فرآیندهای پویا و اغلب پر تلاطمی هستند که سیارات را شکل میدهند و نیروهای عمیق فعال در کیهان را به ما یادآوری میکنند.

همانطور که به بررسی درون زمین ادامه میدهیم، این بقایای تیا نگاهی اجمالی به رویدادهای پر هرج و مرجی که تاریخ اولیهی سیارهی ما را شکل دادهاند، ارائه میدهند. آنها داستانی را نه تنها از ویرانی، بلکه از مقاومت و تحول نیز بیان میکنند – داستانی که بر تلاش مداوم بشر برای درک جایگاه خود در جهان تأکید میکند.

LLVP ها، که نزدیک هستهی زمین قرار دارند، هم بقایای یک برخورد کهن و هم نمادهایی از تکامل سیارهای هستند. با هر کشف، به کشف اسرار پنهان در زیر پایمان و فراتر از ستارگان نزدیکتر میشویم.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: the brighter side of news