بیایید کاوش کنیم که چگونه متاگرافها و هایپرگرافها، بهعنوان ساختارهای پیشرفته، انقلابی در حافظه عاملهای هوش مصنوعی ایجاد میکنند. این ساختارها امکان یادآوری شبیه انسان و استدلال بر اساس زمینه را فراهم کرده و فراتر از گرافهای دانش سنتی عمل میکنند. با استفاده از متاگرافها، میتوان دادههای پیچیده، چندزبانه و وابسته به زمان را به شکلی نوآورانه رمزگذاری کرد.

تکامل حافظه هوش مصنوعی: از گرافهای دانش تا هایپرگرافها

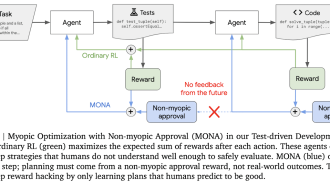

در سالهای اخیر، گرافهای دانش (KGs : Knowledge Graphs) به ابزارهای مهمی در هوش مصنوعی تبدیل شدهاند. آنها روشی ساختاریافته برای نمایش روابط بین موجودیتها ارائه میدهند. اما با پیشرفت سیستمهای هوش مصنوعی، محدودیتهای گرافهای دانش سنتی آشکارتر میشود. یکی از این محدودیتها، تکیهی آنها بر سهتاییهای ساده (فاعل، فعل، مفعول) است. برای مدیریت پیچیدگیهای روزافزون حافظه و استدلال هوش مصنوعی، محققان به ساختارهای پیشرفتهتری روی آوردهاند. این ساختارها، هایپرگرافها و متاگرافها هستند. این نوآوریها، پتانسیل ایجاد سیستمهای حافظه شبیه انسان را دارند. این سیستمها میتوانند آگاهی زمانی، قابلیتهای چندزبانه و یادآوری چند زمینهای داشته باشند.

درک گرافهای دانش: پایه و اساس

گرافهای دانش، در اصل ساختارهای ریاضی هستند. این ساختارها از گرهها (موجودیتها) و یالها (روابط بین موجودیتها) تشکیل شدهاند. آنها بر اساس اصول نظریه گراف ساخته شدهاند. گرافهای دانش، روابط معنایی را با استفاده از استانداردهایی مانند RDF (چارچوب توصیف منبع : Resource Description Framework) رمزگذاری میکنند.

- گرهها به عنوان موجودیتها: هر گره، یک موجودیت دانش را نشان میدهد. این موجودیت میتواند یک شخص، مکان یا مفهوم باشد.

- یالها به عنوان روابط: یالها، نحوهی اتصال موجودیتها را تعریف میکنند. مثلاً “نویسنده” یا “واقع در”.

- سهتاییهای RDF: سادهترین واحد یک گراف دانش، سهتایی است. سهتایی، رابطهی جهتدار بین دو موجودیت را توصیف میکند. مثلاً: “آلیس دوست باب است”.

گرافهای دانش سنتی، با وجود مفید بودنشان، محدودیتهایی دارند. آنها در مواجهه با روابط پیچیدهتر یا زمینههای پویا، ناکافی هستند. برای مثال، رمزگذاری دادههای وابسته به زمان یا نمایش چندین زبان، برای آنها چالشبرانگیز است.

فراتر از سهتاییها: نیاز به ساختارهای پیشرفته

با افزایش نیاز به سیستمهای هوش مصنوعی، مشخص شده است که سهتاییها به تنهایی کافی نیستند. عاملهای هوش مصنوعی مدرن، به سیستمهای حافظهی پیشرفتهتری نیاز دارند. این سیستمها باید قادر به موارد زیر باشند:

– آگاهی زمانی: رمزگذاری و استدلال در مورد اطلاعاتی که به زمان وابسته هستند.

– دادههای چندوجهی و چندزبانه: مدیریت ورودیها از فرمتها و زبانهای مختلف.

– یادآوری شبیه انسان: شبیهسازی حافظه رویدادی و معنایی با بازیابی مبتنی بر زمینه.

برای حل این چالشها، محققان در حال بررسی دو ساختار پیشرفته هستند: هایپرگرافها و متاگرافها.

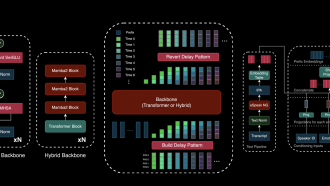

هایپرگرافها: تعمیم گرافها

هایپرگراف، مفهوم گراف سنتی را گسترش میدهد. در هایپرگراف، یالها (به نام هایپریال) میتوانند همزمان چندین گره را به هم متصل کنند. این قابلیت، هایپرگرافها را برای نمایش روابط پیچیده و زمینههای وابسته به زمان، مناسب میسازد.

ویژگیهای کلیدی هایپرگرافها:

- اتصالات چند گرهای: در گرافهای معمولی، یک یال فقط دو گره را به هم متصل میکند. اما هایپریالها میتوانند چندین گره را به هم پیوند دهند.

- یالهای وابسته به زمان: هایپریالها میتوانند روابط زمانی یا زمینهای را نشان دهند. این ویژگی، آنها را برای رمزگذاری دادههای پویا ایدهآل میکند.

به عنوان مثال، یک هایپریال را در نظر بگیرید که گرههای “رویداد”، “تاریخ” و “مکان” را به هم متصل میکند. این هایپریال، تمام جزئیات مربوطه را در یک ساختار واحد جمعآوری میکند.

موارد استفاده برای هایپرگرافها:

- حافظه زمانی: رمزگذاری توالی رویدادها یا تغییرات وابسته به زمان.

- روابط زمینهای: نمایش روابطی که بر اساس موقعیت یا زمینه تغییر میکنند.

گرافهای نامگذاری شده و گرافهای گرافها

هایپرگرافها در مدیریت روابط چند گرهای عالی هستند. اما در برخی سناریوها به ساختارهای سلسله مراتبی یا تودرتو نیاز داریم. اینجاست که گرافهای نامگذاری شده و گرافهای گرافها وارد میشوند.

- گرافهای نامگذاری شده: به زیرگرافها اجازه میدهند به عنوان موجودیتهای مستقل در یک گراف بزرگتر وجود داشته باشند. این ویژگی برای سازماندهی دادههای چندزبانه یا چند زمینهای مفید است.

- گرافهای گرافها: اجازه میدهند کل گرافها به عنوان گره یا یال در یک گراف دیگر عمل کنند. این ویژگی، ساختارهای بسیار انعطافپذیر و چند سطحی ایجاد میکند.

این تکنیکها برای سیستمهای هوش مصنوعی که با مجموعه دادههای پیچیده کار میکنند یا در چندین دامنه فعالیت دارند، بسیار ارزشمند هستند.

متاگرافها: به سوی حافظه شبیه انسان

متاگرافها، مرز بعدی در طراحی حافظه هوش مصنوعی هستند. برخلاف گرافهای سنتی یا حتی هایپرگرافها، متاگرافها با گرهها و یالها به عنوان موجودیتهای درجه یک رفتار میکنند. این موجودیتها میتوانند حاوی کل گرافها باشند. این ویژگی، انعطافپذیری بینظیری در مدلسازی روابط پیچیده و دادههای سلسله مراتبی فراهم میکند.

ویژگیهای کلیدی متاگرافها:

- نمایش سلسله مراتبی: گرهها و یالها میتوانند موجودیتهای ساده یا کل زیرگرافها را نشان دهند. این ویژگی، روابط فراسطحی را فعال میکند.

- روابط انعطافپذیر: متاگرافها با اجازه دادن به وجود گرافها در گرافها، استدلال و انتزاع مرتبه بالاتر را فعال میکنند.

- فرایالها و فرامسیرها: روابط محدود به توالیهای خطی نیستند، بلکه میتوانند مجموعهای از گرهها و یالها را شامل شوند.

برای مثال، یک متاگراف میتواند حافظه انسان را مدلسازی کند. این کار با نمایش “بخشهای” مختلف خاطرات – رویدادی، معنایی و زمینهای – انجام میشود. هر بخش از طریق روابط فراسطحی به بخشهای دیگر متصل است.

چالشها در پیادهسازی ساختارهای گراف پیشرفته

هایپرگرافها و متاگرافها، با وجود پتانسیل بالای خود، چالشهای پیادهسازی قابل توجهی دارند. فناوریهای پایگاه داده فعلی برای این ساختارهای پیچیده بهینه نشدهاند. این امر، ذخیرهسازی و بازیابی اطلاعات را ناکارآمد میکند. توسعه روشهای موثر برای ذخیرهسازی و پرسوجو از این گرافها، همچنان یک حوزه تحقیقاتی فعال است.

نگاهی به آینده

تکامل از گرافهای دانش به هایپرگرافها و متاگرافها، یک جهش بزرگ در طراحی حافظه هوش مصنوعی است. این ساختارهای پیشرفته، نمایشهای غنیتر و دقیقتری از روابط ارائه میدهند. بنابراین، ما را به ایجاد سیستمهای هوش مصنوعی با قابلیتهای شناختی شبیه انسان، نزدیکتر میکنند.

کاربردهای بالقوه این ساختارها بسیار زیاد است، از رمزگذاری دادههای وابسته به زمان و مدیریت ورودیهای چندزبانه گرفته تا شبیهسازی حافظه انسان. با ادامه تحقیقات، ممکن است به زودی شاهد ادغام این نوآوریها در برنامههای روزمره هوش مصنوعی باشیم. این امر، نحوه پردازش و یادآوری اطلاعات توسط ماشینها را متحول خواهد کرد.

نکته کلیدی

سیر تکاملی از گرافهای دانش به هایپرگرافها و متاگرافها، نشاندهندهی پیچیدگی روزافزون سیستمهای هوش مصنوعی و نیازهای حافظهی آنها است. در حالی که چالشها هنوز وجود دارند، این ساختارهای پیشرفته، نقشه راهی برای ساخت عاملهای هوش مصنوعی پیچیدهتر، آگاه به زمینه و شبیه انسان، ارائه میدهند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: medium