خب رفقا، این روزها تعداد مقالات علمی پزشکی شده هزار برابر! واقعاً اگه کسی بخواد همه این مطالب رو بخونه یا دونهدونه پردازش کنه واقعاً باید نماد قهرمان رو براش بزنن. اینجاست که هوش مصنوعی (AI) و مخصوصاً پردازش زبان طبیعی (NLP، یعنی سیستمهایی که میتونن متن رو بفهمن و تحلیل کنن) خیلی مهم و باحال میشن.

تا همین چند وقت پیش نسل قبلی مدلها مثل GPT-4 خیلی توی کارهایی مثل پاسخ به سوالهای پزشکی پیشرفت کرده بود ولی توی بعضی زمینهها هنوز عالی نبود. حالا بچهها اومدن و GPT-5 و نسخه دیگهای به اسم GPT-4o رو روی یه سری چالش جدی، که بهش میگن بنچمارک استاندارد BioNLP، بررسی کردن. خلاصه بگم، بنچمارک یعنی همون آزمون استانداردی که ببینیم هر مدل چقدر کارش درست در میاد.

این تیم ۱۲ تا دیتاست رو از ۶ خانواده کار مختلف تست کردن. مثلاً:

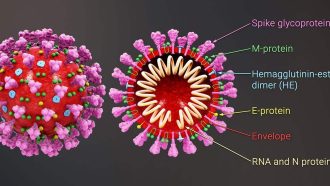

- نامگذاری موجودیتها (Named Entity Recognition یا NER): یعنی مدل بفهمه توی متن چی اسم داروئه، چی اسم بیماری، چی اسم ماده شیمیاییه و اینا.

- استخراج رابطهها (Relation Extraction): مدل باید تشخیص بده مثلاً فلان دارو به فلان بیماری ربط داره یا نه.

- دستهبندی چندگانه اسناد (Multi-label Document Classification): یعنی ممکنه یک مقاله همزمان هم درباره دیابت باشه هم قلب.

- پاسخ به سوال (Question Answering): خب مشهورترین کاربرد، یعنی به سوالاتی که میپرسیم جواب بده.

- خلاصهسازی متن (Text Summarization): که مدل یه متن بلند رو جمعبندی کنه.

- سادهکردن متن (Text Simplification): یعنی جملات سخت و تخصصی رو سادهتر توضیح بده.

حالا چه جوری آزمایش گرفتن؟ اومدن سه حالت تست کردن: مدل هیچ مثال نداره (zero-shot)، یه مثال داره (one-shot) و پنج تا مثال داره (five-shot). مثلاً میگی “این نمونه سوال رو ببین و حالا جواب بده”. همچنین از چند تا مدل همزمان تست گرفتن؛ مثل GPT-4 و GPT-3.5 و LLaMA-2-13B که مدل متنباز فرانسویهاس، تا مقایسه منصفانه باشه.

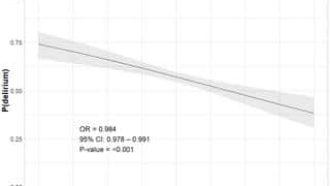

حالا نتیجه؟ GPT-5 ترکونده! تو حالت پنج مثال، امتیاز میانگینش رسید به 0.557، در حالی که GPT-4 فقط 0.506 گرفت و GPT-4o هم 0.508. مخصوصاً روی دیتاست MedQA (که خیلی معروفه برای سوالات پزشکی) GPT-5 به دقت ۹۴.۱٪ رسید! یعنی ۵۰ امتیاز بالاتر از بهترین مدل قبل خودش. حتی توی PubMedQA هم (یه دیتاست دیگه) با مدلهای آموزش دیده تخصصی رقابت کرد و امتیازش شد 0.734.

در کارای استخراجی هم، توی تشخیص مواد شیمیایی NER امتیاز F1 مدل (که یه جور معیار دقت پیشرفتهس) رسید به 0.886. همینطور برای استخراج رابطههای ChemProt (یه دیتاست تخصصی روابط مواد شیمیایی) امتیاز 0.616 رو زد. این یعنی حتی عملکردش از GPT-4 و GPT-4o بهتر بوده.

البته هنوز خلاصهسازی و NER بیماریها یه ذره عقبتر از مدلهایی هست که فقط برای همین کارا آموزش داده شدن (یعنی مدلهایی که بهشون «فرایند آموزش تخصصی» یا fine-tuning دادند). پس برای کارهایی که خیلی مهمه تا جزئیات رو دقیق و بینقص استخراج کنی، بهتره مدلهای ترکیبی یا مخصوص اون کار رو استفاده کنی.

نکته مهم این آزمایش این بود که دقیقاً تعیین کرد کجاها مدلهای عمومی مثل GPT-5 با همون پرامپت ساده (یعنی همون سوال و مثال دادن معمولی) جواب میده و کجاها باید بریم سراغ روشهای پیشرفتهتر، مثل افزونه جستوجو (retrieval-augmented) یا مدلهایی که مرحلهبندی و برنامهریزی دارن (planning-based scaffolds).

در کل نتیجه اینه: GPT-5 حالا رسماً واسه کارای سوال و جواب پزشکی یا همون reasoning-oriented QA داره سر و ته رو جمع میکنه و میتونه تو کارای عملیاتی در بیمارستانها یا تحقیقات پزشکی استفاده شه. ولی برای کارای سخت و دقیقتر هنوز هم مدلهای ویژه یا ترکیبی برتری دارن. خلاصه اگر دنبال هوش مصنوعی هستین که تو دنیای پزشکی کمکتون کنه، حالا دیگه GPT-5 یه گزینه جدی و آماده است! 😉

منبع: +