بحث در مورد استدلال و توانایی هوش مصنوعی (AI) نظرات گستردهای را برانگیخته است. این نظرات اغلب تحت تأثیر دیدگاههای انسانمحورانه قرار دارند. برخی معتقدند که استدلال هوش مصنوعی اصالت و ویژگیهای انسانی ندارد، در حالی که گروهی دیگر بر تواناییهای شناختی و قابل اندازهگیری آن تأکید میکنند. در این مقاله، مفهوم استدلال و تأثیر انسانانگاری بر درک ما از تواناییهای هوش مصنوعی بررسی میشود و معیارها، تعاریف و تحولات آن مورد تحلیل قرار میگیرد.

بررسی جنجال: آیا هوش مصنوعی میتواند استدلال کند؟

این سوال که آیا هوش مصنوعی میتواند استدلال کند، به بحثی داغ تبدیل شده است. نظرات در این مورد بسیار متفاوت است. برخی آن را کاملاً رد میکنند و برخی دیگر از پیشرفتهای انقلابی آن سخن میگویند. مدلهای جدید OpenAI، مانند GPT-4، این بحث را داغتر کردهاند. برخی منتقدان، این مدلها را صرفاً «تکمیل خودکار پیشرفته» یا «طوطیهای تصادفی» میدانند. در مقابل، برخی دیگر آنها را گامی به سوی عصر جدید هوش مصنوعی میبینند. در مرکز این اختلاف نظرها، یک سوال اساسی وجود دارد: منظور ما از «استدلال» چیست؟

تعریف «استدلال»

استدلال اغلب به عنوان یک توانایی شناختی تعریف میشود. این توانایی به حل مسائلی مربوط میشود که نیاز به تفکر منطقی دارند. این مسائل میتوانند در حوزههای مختلفی مانند ریاضیات، استدلال عقل سلیم، درک زبان یا استنتاج باشند. برخی منتقدان بر اصطلاحاتی مانند «استدلال واقعی» یا «استدلال مانند انسانها» تأکید دارند. اما این تعاریف اغلب نشاندهندهی سوگیری انسانمحورانه هستند. چنین دیدگاههایی بیانگر این است که استدلال برای معتبر بودن باید مشابه فرآیندهای فکری انسان باشد. این موضوع درک ما از تواناییهای هوش مصنوعی را محدود میکند.

به جای تمرکز بر شباهت استدلال هوش مصنوعی با انسان، رویکرد عینیتری وجود دارد. این رویکرد، ارزیابی توانایی هوش مصنوعی در حل مسائلی است که نیاز به استدلال دارند. این دیدگاه از انتظارات ذهنی جلوگیری میکند و به ما اجازه میدهد سیستمهای هوش مصنوعی را بر اساس عملکرد قابل اندازهگیری ارزیابی کنیم.

نقش معیارها

برای تعیین توانایی استدلال هوش مصنوعی، محققان از معیارهای استاندارد استفاده میکنند. این معیارها، تواناییهای شناختی را ارزیابی میکنند. برخی از این آزمونها عبارتند از:

- HellaSwag و WinoGrande: این آزمونها استدلال عقل سلیم را از طریق وظایفی مانند حل ضمیر ارزیابی میکنند.

- GLUE و SuperGLUE: این آزمونها درک زبان طبیعی را اندازهگیری میکنند.

- AI2 Reasoning Challenge (ARC): این آزمون استدلال زنجیرهای فکری و حل مسئله چند مرحلهای را بررسی میکند.

- InFoBench: این آزمون توانایی پیروی از دستورالعملها را ارزیابی میکند.

به عنوان مثال، سوالات WinoGrande توانایی حل ضمایر مبهم را میسنجند. مثلاً مشخص کردن اینکه «او» در جمله به چه کسی اشاره دارد: «آن از مری پرسید که کتابخانه چه ساعتی بسته میشود زیرا او فراموش کرده بود.» انسانها به راحتی این وظایف را انجام میدهند. اما این وظایف برای سیستمهای هوش مصنوعی که با ظرافتهای زبان آشنا نیستند، چالشبرانگیز است.

عملکرد هوش مصنوعی در وظایف استدلال

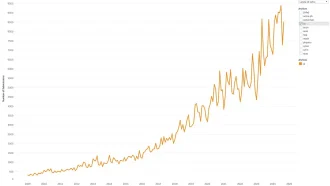

مدلهای پیشرفته هوش مصنوعی پیشرفت قابل توجهی در معیارهای مختلف نشان دادهاند. به عنوان مثال:

- در HellaSwag، GPT-4 Turbo به دقت ۹۶ درصد دست یافت و از Gemini Pro گوگل با ۹۲.۵ درصد پیشی گرفت.

- در MMLU، که یادگیری چند وظیفهای را اندازهگیری میکند، GPT-4 امتیاز حدود ۸۷ درصد را کسب کرد که کمی از ۹۰ درصد Gemini Ultra عقبتر است.

این نتایج نشان میدهد که مدلهای بزرگ زبانی (LLM) تواناییهای استدلالی فراتر از تطبیق الگو دارند. توانایی پیروی از دستورالعملهای پیچیده و تولید نتایج دقیق نشاندهندهی سطحی از عملکرد شناختی است که رد سادهانگارانهی آن را دشوار میکند.

پرداختن به انتقادات رایج

با وجود این پیشرفتها، برخی منتقدان هنوز بر این باورند که هوش مصنوعی فاقد استدلال «واقعی» یا «معتبر» است. این انتقادات اغلب به تعاریف ذهنی از استدلال وابسته هستند که ویژگیهای انسانگونه را بر نتایج قابل اندازهگیری ترجیح میدهند.

سوگیری انسانمحور

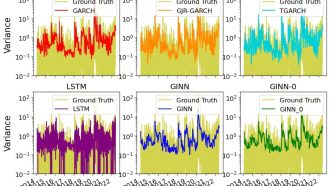

یک موضوع تکراری این باور است که استدلال معتبر باید شبیه شناخت انسان باشد. به عنوان مثال، نوام چامسکی معتقد است هوش مصنوعی نمیتواند مانند انسانها «واقعاً فکر کند» یا معنی را درک کند. همچنین، محققان اپل اخیراً محدودیتهایی در تواناییهای استنتاج هوش مصنوعی بیان کردهاند. آنها متوجه شدهاند که وقتی جزئیات بیربط به مسائل اضافه میشوند، عملکرد هوش مصنوعی کاهش مییابد.

این انتقادات حوزههایی را نشان میدهند که هوش مصنوعی با هوش انسانی متفاوت است. اما آنها همچنین سوگیری در برابر دانستن استدلال انسان به عنوان تنها شکل «معتبر» استدلال را برجسته میکنند. این دیدگاه احتمال وجود شکل جدید و غیرانسانی هوش در هوش مصنوعی را نادیده میگیرد.

مغالطه «طوطی تصادفی»

یکی دیگر از انتقادات رایج این است که مدلهای هوش مصنوعی مانند «طوطیهای تصادفی» هستند که الگوها را بدون درک تقلید میکنند. اما این توصیف، مکانیسمهای پیچیده LLMها را بیش از حد ساده میکند. سیستمهای هوش مصنوعی مدرن میتوانند از دستورالعملهای پیچیده پیروی کنند، با زمینههای متنوع سازگار شوند و مسائلی را در حوزههای مختلف حل کنند. این قابلیتها فراتر از حافظه یا تقلید ساده هستند.

همانطور که سباستین بوبک، محقق مایکروسافت، بیان میکند، توانایی هوش مصنوعی در پیروی از دستورالعملها و تولید پاسخهای مناسب نشاندهندهی نوعی درک است، حتی اگر با شناخت انسان متفاوت باشد.

تکامل استدلال هوش مصنوعی

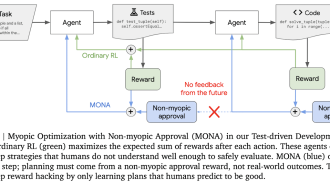

یکی از پیشرفتهای امیدوارکننده در استدلال هوش مصنوعی، مفهوم درخواست زنجیره فکری (Chain of Thought : CoT) است که توسط گوگل معرفی شده است. این رویکرد، سیستمهای هوش مصنوعی را به تقسیم مسائل به مراحل منطقی تشویق میکند و توانایی آنها را در مدیریت وظایف پیچیده بهبود میبخشد. به عنوان مثال، مدلهای جدید OpenAI از تکنیکهای CoT برای افزایش دقت استدلال استفاده میکنند.

با این حال، استدلال محدود به حل مسئله چند مرحلهای نیست. اشکال سادهتر استدلال، مانند استنتاج عقل سلیم، نیز در ارزیابی تواناییهای شناختی هوش مصنوعی مهم هستند. با در نظر گرفتن تنوع وظایف استدلال، میتوانیم درک دقیقتری از نقاط قوت و محدودیتهای هوش مصنوعی به دست آوریم.

یک هوش بیگانه

هوش مصنوعی مدرن نوعی هوش را نشان میدهد که با شناخت انسان متفاوت است. برخلاف انسانها که لحظات «آها» درک را تجربه میکنند، هوش مصنوعی به مدلهای احتمالی و تشخیص الگو متکی است. این تفاوت اغلب منجر به سوء تفاهم در مورد قابلیتهای آن میشود.

به عنوان مثال، محققان اپل دریافتند که LLMها در مواجهه با جزئیات بیربط در مسائل ریاضی با مشکل مواجه میشوند. انسانها میتوانند به راحتی اطلاعات اضافی را فیلتر کنند، اما سیستمهای هوش مصنوعی به دلیل تکیه بر نشانههای زمینهای دچار مشکل میشوند.

با وجود این محدودیتها، رد تواناییهای استدلال هوش مصنوعی به دلیل تفاوت آن با تفکر انسان، دیدگاه کلی را نادیده میگیرد. به جای انتظار تقلید هوش مصنوعی از هوش انسان، باید آن را به عنوان شکلی «بیگانه» از استدلال با نقاط قوت و ضعف منحصر به فرد بپذیریم.

افکار پایانی: تعریف مجدد استدلال

بحث در مورد توانایی استدلال هوش مصنوعی اغلب نشاندهندهی سوگیریها و فرضیات خودمان است. با اصرار بر شباهت استدلال با شناخت انسان، ممکن است پتانسیل هوش مصنوعی به عنوان شکلی متمایز از هوش را دست کم بگیریم. در عوض، باید بر نتایج قابل اندازهگیری تمرکز کنیم و روشهای متنوع استدلال را به رسمیت بشناسیم.

پیشرفت هوش مصنوعی در حل مسائل پیچیده و سازگاری با چالشهای جدید، نشاندهندهی رشد تواناییهای شناختی آن است. با اصلاح تعاریف و معیارهایمان، ممکن است دریابیم که استدلال مختص انسانها نیست، بلکه توانایی مشترکی است که در اشکال مختلف هوش وجود دارد.

در نهایت، پذیرش این دیدگاه وسیعتر نیازمند فروتنی است. باید بپذیریم که استدلال انسان تنها یک نمونه از طیف وسیعی از احتمالات شناختی است.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: medium