مدل o1 شرکت اوپنآی (OpenAI)، به رهبری جری تورک، با الهام از شیوهی تفکر انسان، تحولی بزرگ در مدلهای هوش مصنوعی ایجاد کرده است. این مدل، که بهعنوان یک دستاورد نوآورانه در زمینهی مدلهای زبانی بزرگ شناخته میشود، روشهای سنتی افزایش مقیاس را کنار گذاشته و رویکردی دقیقتر و اکتشافیتر را به کار میگیرد.

گشودن دریچههای جدید در حل مسئله با هوش مصنوعی

با پیشرفت هوش مصنوعی، هدایت مدلهای زبانی بزرگ (LLMs) به سمت هوش عمومی مصنوعی (AGI) به چالشی روزافزون تبدیل شده است. شرکت اوپنآی، پیشرو در این حوزه، مدتها به افزایش مقیاس – دادههای بیشتر، آموزش طولانیتر و قدرت محاسباتی عظیمتر – برای دستیابی به پیشرفتهای چشمگیر در هوش متکی بود. اما، تا سال ۲۰۲۴، این روشها با محدودیتهای جدی مواجه شدند. دادههای آموزشی کمیاب و افزایش مقیاس منابع محاسباتی بهطور سرسامآوری گران شد. در نتیجه، اوپنآی و سایر آزمایشگاههای هوش مصنوعی ناچار به بازنگری در استراتژیهای خود شدند.

در این برهه، جری تورک، محقق باتجربه در اوپنآی، با توسعهی مدل «o1» رویکردی انقلابی را ارائه کرد. برخلاف نسخههای پیشین که عمدتاً برای تولید پاسخها به دانش از پیش آموختهشده متکی بودند، مدل o1 بر استدلال پویا و انعطافپذیری تأکید دارد. این مدل فقط به سؤالات پاسخ نمیدهد؛ بلکه «میاندیشد» و روندهای پیچیدهی تفکر مغز انسان را شبیهسازی میکند.

نگاهی به پشت پردهی o1

تورک، نگاه به مقیاسپذیری را «چندبعدی» میداند و معتقد است نوآوری صرفاً به مجموعه دادههای بزرگتر یا ماشینهای قدرتمندتر محدود نمیشود. بلکه، کاوش ابعاد جدیدی از نحوهی عملکرد مدلهای هوش مصنوعی را نیز در بر میگیرد. مدل o1 با الهام از راهکارهای حل مسئلهی انسان، یک فرآیند تکرارشونده را برای مواجهه با چالشهای پیچیده اتخاذ میکند. این مدل یک رویکرد را امتحان میکند، اثربخشی آن را میسنجد و در صورت لزوم، مسیر خود را تغییر میدهد – مانند روشی که انسانها ایده پردازی میکنند و استراتژیهای خود را هنگام رویارویی با موانع تطبیق میدهند.

این استدلال سنجیده، به مدل o1 اجازه میدهد وظایف پیچیده را با دقت بیشتری نسبت به مدلهای پیشین خود انجام دهد. با این حال، این قابلیت پیشرفته بهایی دارد: مدل برای محاسبهی پاسخها به زمان بیشتری نیاز دارد و دسترسی به آن در مقایسه با نسخههای قبلی، هزینهبرتر است.

هوش انسانگونه در هوش مصنوعی

معماری مدلهای زبانی بزرگ همواره از مغز انسان الهام گرفته است. تیم تورک با o1 این الهام را یک گام فراتر برد و عناصر استدلال انسانگونه را در عملکرد مدل گنجاند. تورک توضیح میدهد که مدلهای قبلی ممکن است در حل مسئله نوعی اکتشاف را نشان داده باشند، اما دامنهی محدودی داشتند. با o1، تمرکز بر پرورش یک فرآیند تصمیمگیری روانتر و هوشمندانهتر معطوف شده است.

برای مثال، این مدل میتواند چندین راهکار حل مسئله را شبیهسازی کند، راهکارهای ناکارآمد را کنار بگذارد و برای بررسی راهحلهای جایگزین به عقب بازگردد. این توانایی «اندیشیدن» آن را به AGI – سیستمی با قابلیت هوش عمومی که با تواناییهای انسان برابری میکند یا از آن فراتر میرود – نزدیکتر میکند.

شغلی ریشه در بلندپروازی

سفر تورک با اوپنآی در شکلدهی مسیر آن بسیار مؤثر بوده است. او حدود شش سال پیش، زمانی که اوپنآی هنوز یک سازمان غیرانتفاعی و یک آزمایشگاه تحقیقاتی کوچک در سانفرانسیسکو بود، به این سازمان پیوست. در آن زمان، تورک در حال کار بر روی استراتژیهای سرمایهگذاری کمی در یک صندوق پوشش ریسک در آمستردام بود. او با مأموریت جسورانهی اوپنآی – ساخت AGI – مجذوب این سازمان شد.

تورک به یاد میآورد: «وقتی در اروپا زندگی میکردم، کمتر پیش میآمد با افرادی روبرو شوم که بگویند: «جری، ما قصد داریم AGI بسازیم. میآیی یا نه؟»» این چشمانداز جسورانه در حال شکلگیری بود زیرا اوپنآی به GPT-2، یک مدل مهم که نشان داد چگونه افزایش مقیاس دادهها و قدرت محاسباتی میتواند منجر به افزایش قابل توجه هوش شود، نزدیک میشد.

از آن روزهای آغازین، تورک نقش مهمی در تکامل اوپنآی ایفا کرده و به آن کمک کرده است از یک آزمایشگاه تحقیقاتی نوپا به یک رهبر جهانی در نوآوری هوش مصنوعی تبدیل شود. کار او بر روی o1 نقطهی عطفی حیاتی است زیرا این حوزه از روشهای سنتی افزایش مقیاس فراتر میرود تا الگوهای جدیدی را در توسعهی هوش مصنوعی کشف کند.

آیندهی مدلهای هوشمند

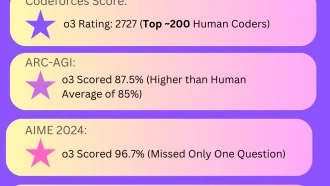

رویکرد پیشگامانهی مدل o1 نشاندهندهی یک تغییر گسترده در جامعهی هوش مصنوعی است. همچنان که محققان با بازدهی کاهشی دادههای بسیار بزرگ و منابع محاسباتی دست و پنجه نرم میکنند، مدلهایی مانند o1 نشان میدهند که چگونه تکنیکهای نوآورانهی استدلال میتوانند هوش مصنوعی را به AGI نزدیکتر کنند.

ایلیا سوتسکور، دانشمند ارشد و یکی از بنیانگذاران اوپنآی، این تغییر را تأیید میکند و بر اهمیت افزایش مقیاس قدرت محاسباتی در حین استنتاج، به جای صرفاً در حین آموزش، تأکید میکند. این استراتژی هوشمندانه میتواند حرکت به سمت AGI را حتی زمانی که روشهای سنتی به حداکثر ظرفیت خود رسیدهاند، حفظ کند.

مشارکتهای تورک نه تنها تخصص فنی او، بلکه تعهد او به پیشبرد مرزهای آنچه هوش مصنوعی میتواند به دست آورد را منعکس میکند. او با بازنگری در نحوهی رویکرد مدلها به حل مسئله، افقهای جدیدی را برای آیندهی هوش مصنوعی گشوده است.

میراثی از نوآوری

توسعهی o1 گواهی بر قدرت نبوغ انسان در پیشبرد هوش ماشین است. تورک و تیمش با بکارگیری استدلال انسانگونه در سیستمهای هوش مصنوعی، استاندارد جدیدی را برای آنچه مدلهای زبانی بزرگ میتوانند به دست آورند، تعیین کردهاند. همچنان که اوپنآی در مسیر دستیابی به AGI گام برمیدارد، نوآوریهایی مانند o1 به عنوان الهامبخش و گواهی بر این هستند که پیشرفت امکانپذیر است – حتی زمانی که رویکردهای سنتی به محدودیتهای خود میرسند.

این داستان بخشی از AI 20، مجموعهای است که فناوران، کارآفرینان و آیندهنگرانی را که آیندهی هوش مصنوعی را شکل میدهند، معرفی میکند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: fastcompany.com