گوگل از هوش مصنوعی Gemini 2.0، یک مدل پیشرفته با قابلیت استدلال تجربی، برای حل مسائل پیچیده در زمینههایی مانند کدنویسی، ریاضی و فیزیک پردهبرداری کرده است. این مدل نوآورانه گامی مهم در مسیر تکامل هوش مصنوعی به سوی درک چندوجهی و توانایی خود-بررسی واقعیت به شمار میآید، اگرچه همچنان در مراحل اولیه توسعه خود قرار دارد.

گوگل از Gemini 2.0 Flash Thinking Experimental رونمایی میکند: فصل جدیدی در استدلال هوش مصنوعی

هوش مصنوعی با سرعت چشمگیری در حال پیشرفت است. شرکتهای بزرگ فناوری برای ارتقای تواناییهای این سیستمها تلاش میکنند. گوگل با معرفی آخرین دستاورد خود، Gemini 2.0 Flash Thinking Experimental، به این رقابت پیوسته است. این مدل هوش مصنوعی پیشرفته، برای نمایش قابلیتهای استدلال قوی و حل مسائل پیچیده در حوزههای مختلف طراحی شده است. Gemini 2.0 هنوز در مرحلهی آزمایشی است. اما نشاندهندهی آرمان بلندپروازانهی گوگل برای آیندهی استدلال در هوش مصنوعی است.

Gemini 2.0 Flash Thinking Experimental چیست؟

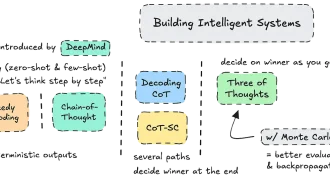

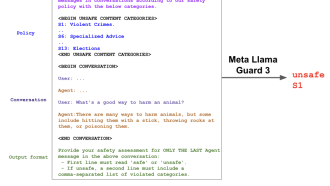

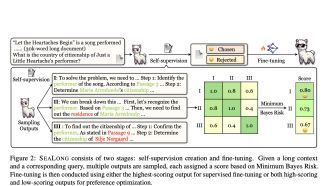

Gemini 2.0 Flash Thinking Experimental بخشی از پلتفرم AI Studio گوگل است. این پلتفرم، فضایی اختصاصی برای نمونهسازی مدلهای پیشرفتهی هوش مصنوعی است. بر اساس اطلاعات موجود، Gemini 2.0 در درک چندوجهی، استدلال و حتی کدنویسی، بسیار توانمند است. این ویژگیها آن را برای چالشهای پیچیده در برنامهنویسی، ریاضیات و فیزیک مناسب میکند. مدلهای سنتی هوش مصنوعی به شدت به تشخیص الگو وابستهاند. اما مدلهای استدلالی مانند Gemini 2.0 با بررسی صحت فرآیندهای خود، سعی در تقلید از تفکر انتقادی انسان دارند.

این مدل قبل از رسیدن به یک راهحل، چندین درخواست مرتبط را بررسی میکند. سپس فرآیند استدلال خود را مرحله به مرحله شرح میدهد. در نهایت، پاسخ نهایی خود را ارائه میدهد. این رویکرد دقیق، مزایای بالقوهای در دقت و قابلیت اطمینان دارد. اما زمان پردازش آن طولانیتر است.

نگاهی گذرا به قابلیتهای آن

لوگان کیلپاتریک، سرپرست محصول AI Studio، در پستی در X (توییتر سابق) این رونمایی را «اولین گام در مسیر استدلال [گوگل]» دانست. جف دین، دانشمند ارشد Google DeepMind، توضیح داد که این مدل «برای استفاده از افکار جهت تقویت استدلال خود آموزش دیده است». دین تأکید کرد که افزایش زمان استنتاج – تلاش محاسباتی در طول فرآیند تصمیمگیری مدل – نتایج امیدوارکنندهای در حل مسائل پیچیده داشته است.

برای مثال، Gemini 2.0 میتواند معماهایی را که شامل سرنخهای بصری و متنی هستند، حل کند. این نشاندهندهی قابلیتهای چندوجهی آن است. اما همانطور که در آزمایشها مشخص شد، این مدل گاهی در کارهای سادهتر، مانند شمارش دقیق حروف یک کلمه، دچار مشکل میشود. این موضوع، هم پتانسیل و هم محدودیتهای فعلی این فناوریِ در حال توسعه را نشان میدهد.

چشمانداز گستردهتر مدلهای استدلالی

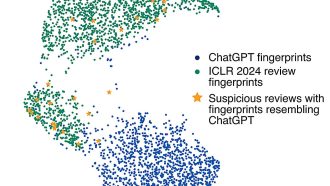

ورود گوگل به حوزهی هوش مصنوعی استدلالی، پس از موجی از نوآوریهای مشابه در آزمایشگاههای هوش مصنوعی رقیب اتفاق افتاده است. مدل o1 شرکت OpenAI از اولین مدلهایی بود که این رویکرد را رایج کرد و باعث ایجاد رقابت شد. در نوامبر ۲۰۲۴، DeepSeek از DeepSeek-R1 رونمایی کرد. همچنین تیم Qwen شرکت Alibaba مدلی را معرفی کرد که به ادعای آنها، اولین مدل استدلال «باز» برای رقابت با o1 بود.

مدلهای استدلالی منحصربهفرد هستند. زیرا فرآیندهای تفکر منطقی را بر محاسبات گسترده یا تشخیص الگوی ساده ترجیح میدهند. این روش، نه تنها توانایی آنها را در حل مسائل پیچیده افزایش میدهد، بلکه خطاهای رایج مانند تولید خروجیهای نادرست یا بیمعنی را نیز کاهش میدهد.

با این حال، این مدلها معایبی هم دارند. استفادهی آنها از منابع محاسباتی زیاد، توسعه و بهکارگیری آنها را پرهزینه میکند. همچنین، با وجود عملکرد قوی در معیارها، مشخص نیست که آیا مدلهای استدلالی این روند بهبود را در طول زمان حفظ خواهند کرد یا خیر.

اهمیت مدلهای استدلالی

ظهور مدلهای استدلالی، نشاندهندهی تغییر رویکرد محققان به هوش مصنوعی مولد است. روشهای سنتی افزایش مقیاس مدلها، بازدهی کمتری دارند. بنابراین، توسعهدهندگان به دنبال راههای جدیدی برای افزایش قابلیتهای هوش مصنوعی هستند. مدلهای استدلالی با تمرکز بر فرآیندهای شناختی به جای قدرت محاسباتی صرف، گزینهی جذابی را ارائه میدهند.

اما مسیر پیش رو مشخص نیست. منتقدان معتقدند که هزینههای بالای مدلهای استدلالی ممکن است کاربرد عملی و مقیاسپذیری آنها را، بهویژه در تجارت، محدود کند. با وجود این چالشها، شرکتهایی مانند گوگل همچنان به کاوش در این حوزه متعهد هستند و منابع قابل توجهی را به تحقیق و توسعه اختصاص میدهند. گزارشها نشان میدهد که گوگل بیش از ۲۰۰ محقق دارد که در چندین تیم روی پیشرفت فناوریهای استدلال کار میکنند.

نگاهی به آینده

Gemini 2.0 Flash Thinking Experimental چیزی فراتر از یک نسخهی جدید هوش مصنوعی است. این مدل، نمادی از گامی به سوی سیستمهایی است که میتوانند مانند انسان، بهطور انتقادی و انطباقی فکر کنند. این فناوری هنوز کامل نیست، اما کاربردهای بالقوهی آن در زمینههایی مانند آموزش، تحقیقات علمی و برنامهنویسی پیشرفته بسیار گسترده است.

رقابت بین آزمایشگاههای هوش مصنوعی شدید است. بنابراین، کاربران میتوانند انتظار پیشرفتهای سریع در مدلهای استدلالی را در سالهای آینده داشته باشند. هنوز مشخص نیست که آیا این سیستمها هوش مصنوعی را متحول خواهند کرد یا خیر. اما یک چیز قطعی است: رقابت برای ساخت هوش مصنوعی هوشمندتر و توانمندتر تازه شروع شده است.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techcrunch