محققان دانشگاه کارنگی ملون موفق به توسعه مدلی نوین از هوش مصنوعی شدهاند که ترکیبی از مدل GARCH و شبکههای حافظه کوتاهمدت و بلندمدت (LSTM) است. این مدل ترکیبی هوش مصنوعی با بهرهگیری از یادگیری ماشین مبتنی بر فیزیک و حقایق اثباتشدهی بازار، نوسانات بازار مالی را با دقتی بیسابقه پیشبینی میکند. رویکرد نوآورانه آن به بهبود قابلتوجه عملکرد نسبت به مدلهای سنتی منجر شده و افقهای جدیدی برای کاربردهای مختلف گشوده است.

افق جدیدی در پیشبینی نوسانات بازار مالی

نوسان، از عوامل مهم در بازارهای مالی است. این عامل بهطور مستقیم بر ریسک و بازده سرمایهگذاری تأثیر میگذارد. مدلهایی مانند چارچوب ناهمسانی واریانس شرطی خودرگرسیو (ARCH) برای چندین دهه در پیشبینی نوسانات سریهای زمانی نقش اساسی داشتهاند. اما این روشهای سنتی در تطبیق با ویژگیهای غیرخطی بازارهای پرنوسان با مشکل روبرو هستند. محققان دپارتمان مهندسی مکانیک دانشگاه کارنگی ملون، با درک این محدودیت، مدل ترکیبی پیشرفتهای توسعه دادهاند. این مدل، معیار جدیدی در پیشبینی نوسانات بازار مالی ایجاد کرده است.

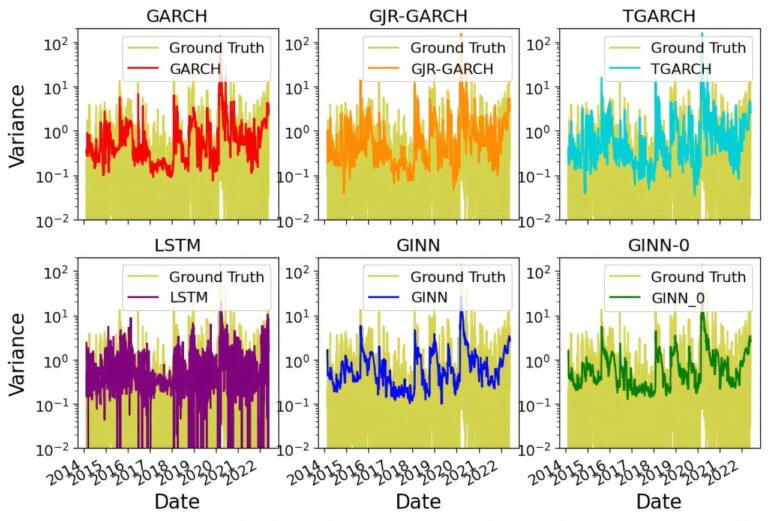

این چارچوب جدید که شبکه عصبی مبتنی بر GARCH (GINN) نام دارد، دقت آماری مدل GARCH را با قابلیت انطباق شبکه عصبی عمیق LSTM ترکیب میکند. GINN با ادغام این دو روش، هم روندهای کلی بازار و هم الگوهای پیچیدهی غیرخطی را که از دید رویکردهای مرسوم پنهان میمانند، شناسایی میکند.

تلفیق فیزیک و یادگیری ماشین

مدل GINN از یادگیری ماشین مبتنی بر فیزیک الهام گرفته است. این تکنیک، قوانین تثبیتشدهی فیزیک را در معماریهای هوش مصنوعی ادغام میکند. در این مدل، تیم تحقیقاتی از “حقایق اثباتشده” – الگوهای تجربی مستند در بازارهای مالی – برای بهبود فرآیند یادگیری استفاده کرده است. GINN با گنجاندن این بینشهای بازار در شبکه عصبی، هم از حقایق تاریخی و هم از قابلیتهای پیشبینی مدل GARCH بهره میبرد.

زدا زو، دانشجوی دکترای کارنگی ملون و نویسندهی اصلی این مطالعه، اهمیت این رویکرد ترکیبی را چنین بیان میکند:

“مدلهای سنتی یادگیری ماشین در معرض خطر ‘بیشبرازش’ قرار دارند. یعنی مدل بیش از حد با دادههای آموزشی خود تطبیق پیدا میکند. ما با ساخت یک مدل ترکیبی، قابلیت تعمیم و دقت را افزایش میدهیم.”

این استراتژی نوآورانه، بیشبرازش را کاهش میدهد و قدرت پیشبینی را به حداکثر میرساند. به همین دلیل، این مدل ابزاری قدرتمند برای کاربردهای دنیای واقعی است.

عملکرد برتر در بازارهای جهانی

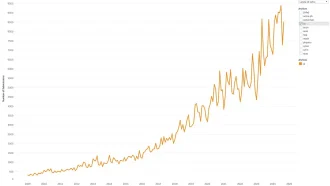

در آزمایشهای گسترده در مقایسه با مدلهای رقیب، GINN، مدل مستقل GARCH را با ۵٪ دقت بیشتر پشت سر گذاشت. این رویکرد ترکیبی، پیشرفتهای قابلتوجهی در پیشبینی نوسانات روزانهی قیمتهای بسته شدن در هفت شاخص اصلی بازار سهام در سراسر جهان نشان داد. این نتایج، توانایی GINN را برای تطبیق با شرایط مختلف بازار، که مزیتی حیاتی در چشمانداز مالی غیرقابلپیشبینی امروز است، برجسته میکند.

کریس مککامب، دانشیار مهندسی مکانیک در کارنگی ملون، پیامدهای گستردهی این کار را چنین بیان میکند:

“این نمونهای عالی از توانایی روشهای مهندسی در حوزههای دیگر است. با الهام از یادگیری ماشین مبتنی بر فیزیک و همکاری با متخصصان، راه جدیدی برای ساخت مدلهای سری زمانی برای پیشبینی ایجاد کردهایم.”

فراتر از امور مالی: کاربردهای گستردهتر

GINN کاربرد استثنایی در بازارهای مالی دارد، اما کاربردهای آن فراتر از این حوزه است. به گفتهی زو، این مدل برای هر کاربردی که شامل دادههای سری زمانی است، مانند ناوبری خودروی خودران و سیستمهای هوش مصنوعی مولد، مناسب است. این تطبیقپذیری، GINN را به ابزاری مؤثر در صنایعی که پیشبینیهای دقیق در آنها بسیار مهم است، تبدیل میکند.

ثمرهی همکاری

این مطالعه با همکاری متخصصانی از دانشگاه ایالتی پنسیلوانیا، دانشگاه نیویورک و دانشگاه لوند انجام شده است و نمونهای از نوآوری بینرشتهای است. این تحقیق که در مجموعه مقالات پنجمین کنفرانس بینالمللی ACM در مورد هوش مصنوعی در امور مالی منتشر شده است، ترکیبی از نبوغ مهندسی و تخصص حوزههای مختلف است و راه را برای پیشرفتهای آینده در مدلسازی سریهای زمانی هموار میکند.

گامی مهم در تجزیه و تحلیل پیشبینیکننده

معرفی GINN، پیشرفت قابلتوجهی در پیشبینی مالی و فراتر از آن است. این مدل ترکیبی با ادغام روشهای آماری و یادگیری ماشین، دقت، تطبیقپذیری و کاربرد را در زمینههای مختلف افزایش میدهد. از آنجایی که صنایع به طور فزایندهای به تجزیه و تحلیل پیشبینیکننده متکی هستند، نوآوریهایی مانند GINN بدون شک نقش مهمی در آیندهی آنها ایفا خواهند کرد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techxplore.com