تحقیقات جدید نشان میدهد مدلهای زبانی بزرگ (LLMها) در استدلال واقعی و انجام محاسبات، بیشتر به روشهای ابتکاری و حفظ کردن متکی هستند تا یادگیری عمیق. با بررسی سازوکارهای درونی این مدلها، محققان مدارهای خاصی را که مسئول عملکرد آنها در وظایف ریاضی هستند شناسایی کردهاند و به محدودیتهای استدلال هوش مصنوعی بینشهای ارزشمندی افزودهاند.

بررسی محدودیتهای مدلهای زبانی بزرگ در استدلال و ریاضیات

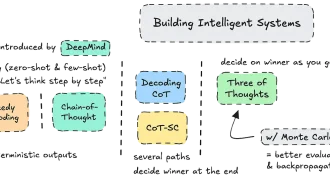

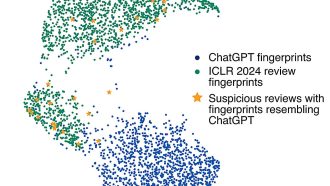

این پرسش که آیا مدلهای زبانی بزرگ (LLMها) وظایف استدلالی را از طریق الگوریتمهای عمومی یا صرفاً حفظ کردن حل میکنند، مدتهاست ذهن محققان را به خود مشغول کرده است. مطالعهای جدید به این موضوع پرداخته و نشان میدهد LLMها اغلب وظایف استدلالی را با استفاده از روشهای ابتکاری، بهجای «یادگیری» واقعی، تقریب میزنند. این تحقیق با تشریح فرآیندهای درونی LLMها، بر اتکای آنها به مدارهای خاصی که استدلال را شبیهسازی میکنند اما فاقد انعطافپذیری هستند، تأکید میکند. درنتیجه، محدودیتهای ذاتی این مدلها در دستیابی به هوش عمومی آشکار میشود.

اهمیت استدلال در هوش مصنوعی

استدلال برای هوش مصنوعی (AI) ضروری است. استدلال به سیستمها توانایی تصمیمگیری، حل مسئله و تقلید فرآیندهای فکری انسان را میدهد. مقاله تأثیرگذار فرانسوا شوله در سال ۲۰۱۹، “در مورد سنجش هوش”، هوش را “کارایی کسب مهارت” تعریف میکند. او بر انعطافپذیری و تعمیم، بهجای عملکرد خاص وظیفه، تأکید دارد. این دیدگاه، معیارهای رایج که صرفاً توانایی سیستم را برای انجام وظایف از پیش تعریفشده میسنجند، به چالش میکشد.

برای نزدیک شدن سیستمهای هوش مصنوعی به هوش عمومی مصنوعی (AGI)، باید توانایی کسب مهارتهای جدید و حل مسائل جدید را بدون اتکا به دانش قبلی گسترده یا دادههای آموزشی نشان دهند. معیارهای فعلی اغلب در سنجش این انعطافپذیری ناکام میمانند، زیرا بر مهارتهایی تمرکز میکنند که تحت تأثیر حفظ کردن و حجم دادههای آموزشی هستند. هوش واقعی، آنطور که شوله تعریف میکند، در توانایی سیستم برای حل مشکلات جدید با تعمیم از اطلاعات محدود نهفته است – شاهکاری که LLMها در دستیابی به آن با مشکل روبرو هستند.

انواع استدلال و جایی که LLMها کم میآورند

استدلال را میتوان به چندین نوع طبقهبندی کرد که هر کدام چالشهای منحصر به فردی را برای سیستمهای هوش مصنوعی ایجاد میکنند:

- استدلال قیاسی: نتیجهگیری خاص از مقدمات کلی. LLMها در این نوع استدلال، وقتی قوانین بهوضوح تعریف شده باشند، عملکرد نسبتاً خوبی دارند.

- استدلال استقرایی: استنتاج تعمیمها از مشاهدات خاص. در حالی که LLMها میتوانند الگوها را تقلید کنند، تعمیمهای آنها اغلب فاقد عمق است.

- استدلال ابداکتیو: فرض محتملترین توضیح برای دادههای ناقص. LLMها به دلیل عدم درک واقعی از زمینه، در این نوع استدلال با مشکل مواجه هستند.

- استدلال عقل سلیم: بهکارگیری دانش روزمره در موقعیتهای معمولی. LLMها اغلب در وظایفی که نیاز به دانش تجربی یا علّی دارند، شکست میخورند.

- استدلال غیر یکنواخت: تجدیدنظر در نتیجهگیری بر اساس اطلاعات جدید. LLMها در این نوع استدلال به ویژه ضعیف هستند، زیرا معماری آنها اجازه بهروزرسانی پویای دانش قبلی را نمیدهد.

در میان این موارد، استدلال عقل سلیم و استدلال غیر یکنواخت برای LLMها بهطور خاص چالشبرانگیز هستند. اتکای آنها به روابط ایستا بین مفاهیم و فقدان دانش تجربی، مانع از تنظیم پویای آنها با زمینههای جدید یا ادغام مؤثر چندین بخش از اطلاعات میشود.

نقش روشهای ابتکاری در عملکرد LLM

برای درک چرایی مشکل LLMها در استدلال واقعی، بررسی مفهوم روشهای ابتکاری ضروری است.

روشهای ابتکاری چیست؟

روشهای ابتکاری، میانبرهای ذهنی یا قواعد سرانگشتی هستند که برای حل سریع مسائل استفاده میشوند و اغلب دقت را فدای سرعت میکنند. در هوش مصنوعی، روشهای ابتکاری یافتن راهحلهای “قابل قبول” را بر راهحلهای کامل ترجیح میدهند. برای LLMها، روشهای ابتکاری به شکل الگوهایی که در طول آموزش آموخته میشوند، ظاهر میشوند و سپس برای تقریب راهحلها برای وظایف جدید اعمال میشوند.

چگونه روشهای ابتکاری رفتار LLM را شکل میدهند

LLMها بهشدت به مکانیسمهای ابتکاری برای شبیهسازی استدلال متکی هستند. معماری آنها اساساً برای تشخیص الگو بهجای درک واقعی طراحی شده است. برای مثال:

- الگوهای عددی را تشخیص میدهند (مثلاً تشخیص محدودهها یا دنبالهها).

- ارتباطهای از پیش آموختهشده بین ورودیها و خروجیها را به کار میبرند.

- از روابط احتمالی برای پیشبینی محتملترین پاسخ بر اساس دادههای آموزشی استفاده میکنند.

در حالی که این روشها میتوانند نتایج قابل قبولی ایجاد کنند، زمانی که با سناریوهای جدید یا پیچیدهای که نیاز به تعمیم واقعی دارند مواجه میشوند، ناکام میمانند.

رمزگشایی جعبه سیاه: چگونه LLMها حساب را شبیهسازی میکنند

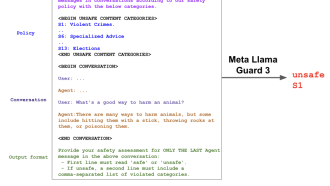

برای بررسی چگونگی مدیریت وظایف محاسباتی و استدلالی توسط LLMها، محققان از تحلیل علّی برای شناسایی مدارهای عصبی خاص مسئول این عملکردها استفاده کردند. یافتههای کلیدی عبارتند از:

- نورونهای ابتکاری: گروه کوچکی از نورونها از روشهای ابتکاری ساده برای تشخیص الگوهای ورودی عددی و تولید خروجیهای متناظر استفاده میکنند.

- مدار حسابی: این زیرمجموعه کوچک از اجزای عصبی – شامل پرسپترونهای چندلایه (MLPها) خاص و هدهای توجه – محاسبات حسابی را با مسیریابی اطلاعات عملوند و عملگر انجام میدهد.

- استفاده پراکنده: تنها حدود ۱.۵٪ از نورونها در هر لایه به طور فعال در وظایف حسابی درگیر هستند، با این حال آنها ۹۶٪ از دقت حسابی مدل را تشکیل میدهند.

وصلهگذاری فعالسازی: شناسایی اجزای حیاتی

محققان از تکنیکی به نام وصلهگذاری فعالسازی برای شناسایی اجزای عصبی ضروری برای عملیات حسابی استفاده کردند. با جایگزینی انتخابی فعالسازیها از یک مسئله با مسئله دیگر، آنها مشخص کردند کدام نورونها و هدهای توجه برای حل وظایف خاص حیاتی هستند.

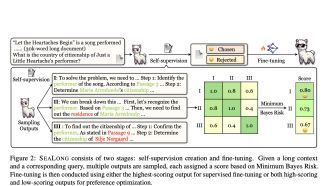

ظهور روشهای ابتکاری در طول آموزش

این مطالعه مکانیسم “مجموعهای از روشهای ابتکاری” را نشان داد، جایی که چندین محاسبه مستقل برای تولید نتیجه نهایی ترکیب میشوند. این روشهای ابتکاری در اوایل آموزش ظاهر میشوند و در طول آن ثابت میمانند، که نشان میدهد آنها الگوهای بنیادی هستند نه بهینهسازیهای مرحله آخر.

درک مدارها به تفصیل: تجزیه گام به گام

در اینجا چگونگی پردازش یک مسئله حسابی ساده مانند “۲۲۶–۶۸ =” توسط LLM آمده است:

- نشانهگذاری اولیه: اعداد و عملگرها نشانهگذاری میشوند و به اجزای عصبی خاص هدایت میشوند.

- فعالسازی ابتکاری: نورونهای مختلف در وظایفی مانند تشخیص محدوده اعداد، مدیریت قرض گرفتن یا تراز کردن ارقام تخصص دارند. برای مثال:

- نورون A برای اعداد در محدوده ۲۰۰-۳۰۰ فعال میشود.

- نورون B زمانی را که قرض گرفتن لازم است شناسایی میکند.

- نورون C رقم دهها را پس از قرض گرفتن محاسبه میکند.

- ترکیب نهایی: خروجیهای این نورونهای تخصصی برای تولید پاسخ نهایی (مثلاً ۱۵۸) ترکیب میشوند.

این فرآیند بهشدت به الگوهای از پیش آموختهشده متکی است و زمانی که با مسائلی خارج از توزیع آموزشی مدل، مانند حساب چند رقمی با محدوده اعداد ناآشنا، مواجه میشود، شکست میخورد.

چرا LLMها از استدلال واقعی کوتاهی میکنند

اتکا به مکانیسمهای ابتکاری، محدودیت اساسی LLMها را آشکار میکند: آنها استدلال را تقریب میزنند اما واقعاً آن را درک یا تعمیم نمیدهند. نقاط ضعف کلیدی عبارتند از:

- فقدان علیت: LLMها روابط علت و معلولی را درک نمیکنند و این آنها را مستعد خطا در استدلال منطقی میکند.

- پایگاه دانش ایستا: برخلاف انسانها، LLMها نمیتوانند درک خود را هنگام ارائه اطلاعات جدید یا متناقض بهطور پویا بهروز کنند.

- ناتوانی در تعمیم: عملکرد آنها زمانی که با مسائل جدید خارج از دادههای آموزشی خود مواجه میشوند، بهطور قابلتوجهی کاهش مییابد.

این محدودیتها بر چالش دستیابی به AGI با معماریهای فعلی مبتنی بر ترانسفورماتور، که کارایی را بر انعطافپذیری واقعی ترجیح میدهند، تأکید میکند.

نتیجهگیری

یافتهها واقعیت مهمی را تأیید میکنند: LLMهای مبتنی بر ترانسفورماتور به معنای واقعی کلمه استدلال را یاد نمیگیرند – آنها آن را از طریق روشهای ابتکاری پیچیده تقریب میزنند. این محدودیت فقط یک مانع فنی نیست، بلکه یک محدودیت اساسی خود معماری است. در حالی که این مدلها در شبیهسازی استدلال برای وظایف از پیش تعریفشده برتری دارند، زمانی که از آنها خواسته میشود به سناریوهای جدید تعمیم دهند یا با آنها سازگار شوند، ناکام میمانند.

برای پیشرفت هوش مصنوعی به سمت AGI، محققان باید فراتر از روشهای ابتکاری نگاه کنند و معماریهایی را توسعه دهند که قادر به انتزاع و انعطافپذیری واقعی باشند و شکاف بین عملکرد خاص وظیفه و هوش واقعی را پر کنند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: medium