شرکت آنتروپیک از یک سیستم دفاعی پیشرفته برای مقابله با جیلبریک مدلهای زبان بزرگ (LLM) رونمایی کرده است. این فناوری با بهرهگیری از یک فیلتر ویژه، سؤالات مضر را پیش از رسیدن به مدل Claude مسدود میکند. آزمایشهای گسترده، از جمله اجرای برنامهی کشف باگ همراه با جایزه، نشاندهندهی عملکرد امیدوارکنندهی این روش است، هرچند هیچ سیستمی کاملاً بینقص نیست.

لایهای جدید برای دفاع در برابر جیلبریک هوش مصنوعی

شرکت امنیت هوش مصنوعی آنتروپیک، راهکار جدیدی برای محافظت از مدلهای زبان بزرگ (LLM) در برابر حملات جیلبریک ارائه داده است. جیلبریک روشی است که برای فریب هوش مصنوعی و دور زدن محدودیتهای آن طراحی شده. این سیستم حفاظتی جدید مثل یک فیلتر خارجی عمل میکند و مدل اصلی را تغییر نمیدهد. هدف این فیلتر، جلوگیری از رسیدن دستورات مخرب به سیستم است.

چالش جیلبریک

جیلبریک یک آسیبپذیری شناختهشده در سیستمهای هوش مصنوعی است. این آسیبپذیری به کاربران اجازه میدهد مدلها را برای تولید محتوای ممنوعه دستکاری کنند. مهاجمان میتوانند از دستورات هوشمندانه، تکنیکهای ایفای نقش یا قالببندی غیرمعمول متن برای دور زدن حفاظها استفاده کنند. برخی از این تاکتیکها بهطور نگرانکنندهای موثر بودهاند. این موضوع نگرانیهایی را در مورد خطرات پاسخهای نامحدود هوش مصنوعی، بهویژه در حوزههای حساسی مثل توسعهی سلاح، ایجاد کرده است.

آنتروپیک بهطور خاص بر مسدود کردن چیزی تمرکز دارد که «جیلبریک جهانی» مینامد. جیلبریک جهانی حملاتی است که میتوانند مکانیسمهای ایمنی یک مدل را بهطور کامل از کار بیندازد. یک نمونهی رایج، اکسپلویت “هر کاری را همین الان انجام بده” (Do Anything Now یا DAN) است. این اکسپلویت، هوش مصنوعی را فریب میدهد تا محدودیتهای اخلاقی خود را کاملاً نادیده بگیرد.

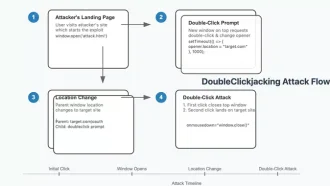

نحوهی عملکرد سپر آنتروپیک

آنتروپیک بهجای تلاش برای ایمنسازی ذاتی مدلهای خود در برابر جیلبریک (چالشی که بیش از یک دهه محققان را ناکام گذاشته است)، یک سیستم فیلترینگ خارجی ساخته است. این سپر، دستورات ورودی و پاسخهای خروجی را بررسی میکند. هر دستوری که شبیه تلاش برای جیلبریک باشد، مسدود میشود.

آنتروپیک برای توسعهی این فیلتر، مجموعهی دادهی بسیار بزرگی از پرسشهای قابل قبول و غیرقابل قبول ایجاد کرد. این دستورات به چندین زبان ترجمه و با استفاده از تکنیکهای رایج جیلبریک اصلاح شدند تا استحکام فیلتر تضمین شود. سپس این شرکت فیلتر را روی این مجموعهی دادهی مصنوعی آموزش داد تا اکسپلویتهای بالقوه را شناسایی و متوقف کند.

آزمایش سپر

آنتروپیک برای ارزیابی effectiveness سپر خود، از متخصصان امنیتی دعوت کرد تا در یک برنامهی پاداش برای یافتن باگ شرکت کنند. به شرکتکنندگان ده سوال ممنوعه داده شد. اگر Claude به همهی این سوالها پاسخ میداد، ۱۵۰۰۰ دلار جایزه میگرفتند. با وجود بیش از ۳۰۰۰ ساعت آزمایش توسط ۱۸۳ نفر، هیچکس نتوانست بهطور کامل سپر را دور بزند؛ هرچند برخی موفق به دریافت پاسخهای ناقص شدند.

این شرکت همچنین آزمایشهای استرس خودکار را با استفاده از ۱۰۰۰۰ دستور جیلبریک تولید شده توسط یک مدل هوش مصنوعی دیگر انجام داد. بدون سپر، ۸۶٪ از این حملات موفقیتآمیز بودند. با وجود سپر، تنها ۴.۴٪ از حملات موفق بودند. این نتایج، کاهش قابل توجهی در آسیبپذیری در مقایسه با اکثر سیستمهای دفاعی موجود را نشان میدهد.

نقاط قوت و محدودیتها

در حالی که رویکرد آنتروپیک پیشرفت بزرگی است، هیچ سیستم امنیتی بینقص نیست. برخی از محققان اشاره کردهاند که فیلتر گاهی اوقات پرسشهای بیضرر مربوط به زیستشناسی و شیمی را مسدود میکند. این موضوع قابلیت استفاده از مدل را در سناریوهای مشروع محدود میکند. علاوه بر این، اجرای سپر باعث افزایش ۲۵ درصدی هزینهی محاسبات میشود که هزینهای برای افزایش امنیت است.

کارشناسان معتقدند که با پیشرفت مدلهای هوش مصنوعی، تکنیکهای جدید جیلبریک هم ظهور خواهند کرد. روشهایی مانند رمزگذاری دستورات با استفاده از رمزها میتواند بهطور بالقوه از سیستمهای دفاعی فعلی عبور کند. این مبارزهی مداوم، نیاز به بهروزرسانیهای پیوسته و استراتژیهای امنیتی انعطافپذیر را برجسته میکند.

آیندهی امنیت هوش مصنوعی

با افزایش قابلیتهای هوش مصنوعی، خطرات سوءاستفاده از آن نیز افزایش مییابد. سپر آنتروپیک گامی پیشگیرانه برای ایمنتر کردن LLMها است، اما این واقعیت را نیز نشان میدهد که هیچ سیستمی کاملاً در برابر حملات نفوذناپذیر نیست. این شرکت از محققان و کاربران دعوت میکند تا به آزمایش سیستمهای دفاعی آن ادامه دهند و این ایده را تقویت کنند که امنیت یک راهحل یکباره نیست، بلکه یک تلاش مداوم است.

آنتروپیک با استفاده از دادههای مصنوعی و آزمایش در مقیاس بزرگ، معیار جدیدی برای امنیت هوش مصنوعی تعیین کرده است. با این حال، با ادامهی بازی موش و گربه بین مهاجمان و مدافعان، این حوزه باید هوشیار بماند و دائماً حفاظها را بهبود دهد تا از تهدیدات جدید جلوتر باشد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: mit technology review