خب، امروز میخوام براتون از یکی از تازهترین و جالبترین ایدههای حوزهٔ نظریه محاسبات بگم: «ماشین تورینگ Psi» یا حالا همون Psi-Turing Machine. خیلی از ماها اسم ماشین تورینگ رو شنیدیم – همون مدل معروفی که آلن تورینگ برای تعریف مفهوم رایانش یا همون محاسبات مطرح کرد. اما این بار ماجرا خیلی باحاله، چون این ماشینها یه ویژگی جدید گرفتن: خوداندیشی محدود!

حالا یعنی چی؟ بذار ساده بگم: توی این مدل جدید،ماشین تورینگ یه قابلیت داره که هر بار، به صورت خیلی محدود به خودش نگاه کنه و بفهمه داره چیکار میکنه. به این کار میگن introspection، یا همون خودشکافی و سؤال ازخود – که البته خیلی معمول نیست تو مدلهای کلاسیک!

اما یه نکته مهم: این نگاه کردن به خودش، محدود و کنترلشدهست! یعنی اصلاً نمیذارن ماشینها هرچقدر بخوان خودشون رو چک کنن. به این کنترل روش، بودجه اطلاعاتی (information budget) میگن. مثلاً هر بار ماشین میخواد introspect کنه، باید توی یه حد و حدود خاصی بمونه که اینجا با یه فرمول، یعنی B(d,n) = c×d×log₂ n تعیین میشه (یه جور سقف داده که مجاز داره تو هر مرحله استفاده کنه).

توی مقاله، این دکمهٔ نگاه به خود رو اسمش رو گذاشتن «رابط introspection به عمق ثابت» یا همون $\iota$. یعنی اصلاً نمیذارن هرچقدر ماشین دلش میخواد عمیق به خودش نگاه کنه.

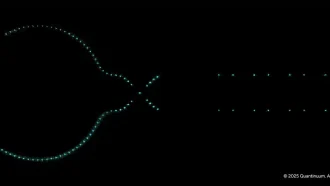

خب حالا چرا این داستان مهمه؟ چون توی نظریه محاسبات یه عالمه سؤالات و گرههای سخت هست که هنوز هیچکس حلشون نکرده؛ مثلاً پرسش معروف P ≠ NP، که میگه آیا مسائلی هست که بشه سریع بررسی کرد اما سریع حل کردنشون غیرممکن باشه؟ حالا تو این کار یه نسخه خاصتر دارند و نشون دادن که اگه همچین رابط introspection داشته باشیم، میشه نشون داد که P^Ψ ≠ NP^Ψ (یعنی با این رابط، ماشینهای از نوع Psi نمیتونن مثل هم همه مسائل رو حل کنن).

یه چیز دیگه هم آوردن به اسم «پلتفرمهای مستقل». یعنی اومدن مدلهای دیگهای مثل درخت تصمیم Psi (Psi-decision Tree) و مدارهای منطقی با محدودیت رابط (IC-AC^0 و IC-NC^1، که اینجا مدار منطقی یعنی جورچینهایی از گیتهای ساده که کار پردازش داده انجام میدن) هم تعریف کردن تا بشه این محدودیت introspection رو تو حوزههای دیگه شبیهسازی و بررسی کرد.

خلاصه، توی این مقاله، سه تا ابزار مهم هم معرفی شده:

- شمردن بودجه (budget counting): یعنی دقیقاً ببینیم هر الگوریتم چقد داره از سهمیه اطلاعاتی خودش استفاده میکنه.

- \Psi-Fooling و \Psi-Fano: اینا تکنیکهایی هستن که نشون میدن حتی با داشتن قابلیت introspection محدود، چه چیزهایی واقعاً سخت باقی میموند واسه ماشینها.

یه تکنیک باحال دیگه هم هست به اسم Anti-Simulation Hook. این یکی جلوی یه حقهٔ رایج رو میگیره: اینکه یه ماشین سعی کنه با تعداد زیادی تماس به نسخههای سطح پایینتر رابط introspection، نسخه سطح بالاترش رو شبیهسازی کنه (یعنی با تقلب و دور زدن محدودیتها قدرت بیشتری بگیره!). این مدل نشون میده که نه، از این روشها دیگه نمیشه تقلب کرد.

در کل هدفشون این بوده که یه «استاندارد مینیمال و واضح» درست کنن برای مدلی که توش هر قدم مصرف اطلاعات و میزان نگاه به خودش قابل حسابوکتابه. اینطوری، خیلی بهتر میشه مرزهای مسائل سخت («دیوارهای پیچیدگی» یا همون complexity barriers) و موضوعات اسرارآمیزی مثل natural proofs (یه مفهوم تخصصی توی اثبات سخت بودن مسائل) رو بررسی کرد.

در یک کلام: دارن سعی میکنن با یه مدل جدید، دقیقتر از همیشه بفهمن چرا بعضی مسائل حتی وقتی ماشین اجازه خودشکافیِ محدود داره، هنوز لاینحل باقی میمونن و مرز پیچیدگی یا همون complexity barrier، همچنان پابرجاست!

پس اگر دنبال یه ماجرای تازه تو دنیای کامپیوتر و ریاضی هستی که روایتش پر از ایدههای نو و کانسپتهای خفن باشه، psi-Turing Machine میتونه برات خیلی جذاب باشه!

منبع: +