خب بیاید با هم یه نگاهی بندازیم به دنیای هوش مصنوعی که چطور داره وارد بازی آمار تو تحقیقات پزشکی میشه و همهچی رو تغییر میده! ماجرا سر همین generative AIهاست — یعنی اون مدلهایی که مثل ChatGPT یا Claude خودشون میتونن متن یا حتی تصاویر بسازن و جواب بدن. تو این مقاله، یه سوال مهم بررسی شده: چطوری با پرامپتهای مختلف (یعنی همون جملهها و سوالهایی که به این مدلها میدیم)، میشه این رباتها رو وادار کرد جوابای آماری درست و قابل فهم بدن؟ مخصوصاً تو کارهای پزشکی که دقت خیلی مهمه.

اول بذارید یه توضیح کوتاه بدم: “Prompt engineering” یعنی هنر و فن طراحی کردن درست و حسابی پرامپتها یا همون سوالها و دستورات برای مدلهای هوش مصنوعی تا خروجی بهتری بدن.

توی این تحقیق، چهار جور روش پرامپت دادن رو تست کردن:

- Zero-shot: یعنی هیچی به مدل نمیگیم، فقط سوال آماری رو مستقیم میپرسیم! مثلاً میپرسی «میانگین این اعداد چنده؟»

- Explicit instruction: یعنی توضیح میدیم دقیقاً چه انتظاری داریم و چی رو باید چک کنه.

- Chain-of-thought: این یکی به مدل کمک میکنه که قدمبهقدم فکر و منطق خودش رو توضیح بده. مثل راهنمایی مرحله به مرحله!

- Hybrid: ترکیبی از دوتای بالایی! یعنی هم دستور صریح میدیم، هم مدل رو تشویق میکنیم استدلال کنه و حتی یه ساختار یا فرمت خاص رو رعایت کنه.

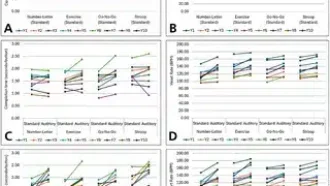

حالا رفتن این روشها رو روی چندتا دیتاست مصنوعی تست کردن که شامل وظایف آماری توصیفی (مثل میانگین و واریانس گرفتن) و استنباطی (یعنی نتیجهگیری آماری یا تست فرضیات) بوده.

برای ارزیابی هم یه حرکت باحال زدن: از GPT-4.1 و Claude 3.7 Sonnet جواب گرفتن و بعدش با Microsoft Copilot (که یه مدل دیگهست و مثل یه داور اتوماتیکه) اومدن خروجیها رو قضاوت کردن، ولی در کنارش یه آدم واقعی هم بررسی میکرد!

نتایج جالب بود. راهکار Zero-shot فقط برای کارای ساده مثل میانگین گرفتن جواب میده؛ ولی وقتی حرف از آمار استنباطی و تست فرضیات میشه، مدل خیلی جاها assumptionها رو اصلاً چک نمیکنه. Assumption یعنی اون پیشفرضهایی که لازمه تا تست آماری معنی بده، مثلاً دادهها باید نرمال باشن یا مستقل باشن و از این جور نکات فنی!

همینجا بود که روش Hybrid خودش رو نشون داد و بهترین و دقیقترین جوابا رو داد. چرا؟ چون مدل رو مجبور میکنی هم دلیل بیاره، هم فرمت نتیجه رو رعایت کنه و هم بهش صریح بگی چی رو چک کنه. نمرهها تو چهار تا معیار — چک پیشفرضها (assumption checking)، انتخاب درست تست آماری، کامل بودن جواب و کیفیت توضیح — نشون داد روش Hybrid بیرقیب بوده.

نکته خفن دیگه این بود که وقتی همون آزمایش رو با مدلهای جدیدتر — مثل Claude 4 Sonnet، Claude 4 Opus، o3 mini و o4 mini — انجام دادن، باز نتایج تقریبا همونی بود که با نسخههای قبلی گرفتن. یعنی این یافتهها رو فقط مخصوص یه مدل نیست و روی مدلهای مختلف OpenAI و Anthropic هم جواب داده. (OpenAI و Anthropic دو تا شرکت معروف ساخته مدلهای گفتگویی هستن!)

پس، نتیجه اینه: اگه داری تو تحقیق پزشکی با هوش مصنوعی تحلیل آماری میکنی، حتماً از پرامپتهای ساختاریافته (Hybrid) استفاده کن تا احتمال خطا بیاد پایین و جوابا قابل تکرار و علمی باشن.

در آخر: تاکید شده که مهندسی پرامپت دیگه یه مهارت کلیدی تو تحقیقات پزشکی با هوش مصنوعی به حساب میاد. بالاخره باید واسه پرامپتها یه سری قالب استاندارد و ابزار ارزیابی طراحی شه و تحقیقات بیشتری تو حوزههای آماری مختلف صورت بگیره تا علم دقیقتر و تکرارپذیرتر پیش بره. خلاصه، اگه دنبال خروجی درست از هوش مصنوعی تو آمار پزشکی باشی، باید بدونی چه جوری باهاش حرف بزنی و سوالا رو طراحی کنی!

منبع: +