بیاین یه نگاه بکنیم به دنیای اضطراب، یعنی اختلال روانی که خیلی از آدمها، مخصوصاً جوونها، تو دنیای پر از تکنولوژی امروز بهش گرفتار شدن. همه ما میدونیم اضطراب چقدر میتونه آزاردهنده باشه؛ نه فقط واسه شخص، بلکه حتی رو کارایی و زندگی اجتماعی جامعه هم تاثیر داره. حالا این روزا یه سری ابزارهای خیلی باحال و پیشرفته مثل یادگیری ماشینی (Machine Learning یعنی همون سیستمهایی که با داده آموزش میبینن و خودشون الگو پیدا میکنن) وارد عمل شدن تا شاید بتونیم اضطراب رو زودتر تشخیص بدیم یا حتی جلوی شدید شدنش رو بگیریم.

ماجرا از کجا شروع شد؟ دانشمندها احساس کردن که نیاز داریم ابزارهایی داشته باشیم تا خیلی زود بتونیم این اتفاق رو تشخیص بدیم و بهش واکنش نشون بدیم. هوش مصنوعی، به خاطر سرعت و دقت بالایی که داره، خیلی امیدبخشه، ولی واقعیت اینه که تا حالا یه بررسی کامل و مفصل از اینکه چه مدلهایی بهترین جواب رو دادن یا اینکه محدودیتاشون چی بوده، کمتر کار شده بود.

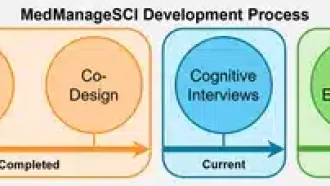

توی یه بررسی سیستماتیک (یعنی بررسی که کل تحقیقات موجود رو جمع و جور و تحلیل میکنه) جدید، اومدن کارایی مدلهای هوش مصنوعی تو پیشبینی اضطراب رو زیر ذرهبین گذاشتن. هدف بررسی این بوده که ببینیم چه الگوریتمهایی استفاده شدن، چه ویژگیهایی (Features یعنی همون خصوصیتها یا دادههایی که مدل روشون کار میکنه)، یا چه روشهایی برای تایید و بررسی عملکرد مدلها، تو تحقیقات مختلف استفاده کردن. خلاصه میخواستن بفهمن: کی و چی داره درست کار میکنه و چی هنوز جای کار داره.

حالا چه تحقیقایی تو این بررسی اومدن؟ فقط تحقیقایی رو انتخاب کردن که مستقیم با پیشبینی اضطراب با هوش مصنوعی سروکار داشتن، یا حتی شدت اضطراب رو با کمک دادههای بالینی (clinical) یا رفتاری اندازه میگرفتن. مثلاً پروژههایی که فقط درباره افسردگی بودن یا پیشتر بررسی شده بودن، حذف شدن؛ یا حتی تحقیقایی که توش دقیق درباره اضطراب نبود حرف میزدن، تو لیست نیومدن.

اونا بیشتر از Scopus و Google Scholar (دو تا منبع بزرگ مقالات علمی) و با کلیدواژههایی مثل “anxiety prediction” و “machine learning” و “mental health” دنبالش گشتن و فقط تحقیقاتی که از سال ۲۰۱۸ تا ۲۰۲۵ چاپ شده بودن، اومدن تو لیست. آخرین سرچ هم تیر ۲۰۲۵ انجام شده بوده، پس حسابی جدیده.

برای اینکه کارشون دقیق باشه، دوتا مرحله غربال کردن داشتن: اول اومدن مطمئن شدن که مقاله واقعاً ربط به اضطراب و هوش مصنوعی داره (یعنی کلیدواژهها توش اومده)، بعدش هم عنوان، مقدمه و نتیجه رو چک کردن که خدایی نکرده اشتباه نیارن. خودشا هم گفتن مقالههایی که فقط بر اساس گزارش خود شخص (self-report) بودن یا الگوریتمش روشن نبود چی کار میکنه، ممکنه سوگیری (Bias یعنی اینکه نتیجهها دیگه کارآمد یا منصفانه نباشن) داشته باشن.

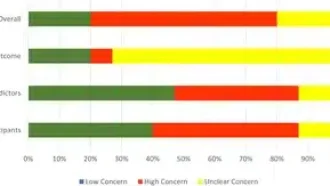

حالا بریم سر نتیجهها! کل تحقیقهایی که تو این بررسی اومدن ۱۹تا بودن و روی هم ۴۴,۶۰۸ نفر رو بررسی کردن که عدد خیلی خوبیه. برای تشخیص اضطراب بیشتر از پرسشنامههایی مثل GAD-7 و DASS-21 (اینها دوتا پرسشنامه استاندارد برای اندازهگیری اضطراب و استرس هستن) استفاده شده.

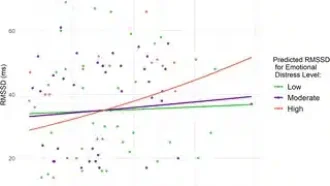

جالبه که بعضی مدلهای یادگیری ماشینی، مثل Random Forest و Gradient Boosting (هر دوشون مدلهایی هستن که با ترکیب کردن یه سری الگوریتم کوچیکتر، پیشبینی قویتر انجام میدن)، حسابی موفق بودن و تو مواردی تا ۹۸٪ دقت رسیدن! برای سنجش عملکرد، معمولاً از معیارهایی مثل F1-score (که تعادلی بین دقت و جامعیت مدل نشون میده)، AUC (یعنی مساحت زیر منحنی ROC که نشون میده مدل چقدر خوب دستهبندی میکنه) و Specificity (یعنی مدل چقدر خوب میتونه کسایی که اضطراب ندارن رو شناسایی کنه) استفاده میشه.

با اینکه نتیجهها امیدبخش بودن، اما هنوز کلی چالش داریم. مثلاً بیشتر تحقیقات رو نمونههای کوچیک و تقریباً مشابه انجام گرفتن که باعث میشه مدل بیش از حد دقیق رو اون نمونه جواب بده ولی تو دنیای واقعی لزوماً خوب عمل نکنه (به این میگن overfitting، یعنی مدل به جزئیات بیخود حساس میشه). یا اینکه خیلی وقتا یه مدل رو فقط با دادههایی که خودشون جمع کرده بودن بررسی کردن و بیرون تست نکردن (external validation یعنی باید مدل رو تو شرایط واقعی یا دادههای دیگه هم تست کنی).

یکی دیگه از معضلا اینه که بعضی مدلهای هوش مصنوعی جوری کار میکنن که کسی نمیفهمه دقیقاً تو ذهنشون چی میگذره! به اینها میگن “black-box” algorithms، یعنی مدلهایی که خروجیشونو میبینیم ولی دقیق نمیدونیم تو مغزشون چه اتفاقی داره میافته. خب این مدلها تو پزشکی خیلی مورد اعتماد قرار نمیگیرن، چون پزشک باید بفهمه مدل چرا این تصمیم رو گرفته.

توی جمعبندی این تحقیقات میگن اگه مدلهای هوش مصنوعی توضیحپذیر (Explainable AI یا XAI – یعنی مدلهایی که میشه منطق تصمیمگیریشو فهمید) رو ترکیب کنیم با دادههای متنوع و معتبر بالینی، اون وقت میتونیم واقعاً تو دنیای واقعی هم از این مدلها کمک بگیریم. یه نقطه ضعف دیگه هم این بود که کمتر تحقیقی سراغ پیشبینی اضطراب قبل از اینکه علائمش ظاهر بشه رفته بود، که خب اگه این کار رو بکنیم حتی میتونیم پیشگیری کنیم!

در کل، داستان اینه که یادگیری ماشینی داره به ما نشون میده میشه تو بحث اضطراب کاری کرد و شاید حتی بتونیم با کمکش کلی زودتر این مشکل رو شناسایی کنیم و زندگی خیلیها رو راحتتر کنیم؛ البته به شرط اینکه مدل رو شفافتر و دیتاهامون رو متنوعتر و درستتر کنیم و حواسمون باشه که مدل تو دنیای واقعی چطور عمل میکنه.

منبع: +