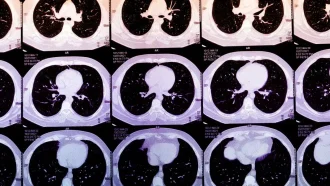

خب بچهها، اگه بخوایم درباره یکی از رایجترین و خطرناکترین سرطانهای ناحیه دهان حرف بزنیم، باید بدونین که “سرطان سلول سنگفرشی دهان” یا همون Oral Squamous Cell Carcinoma که به اختصار بهش OSCC میگن، حسابی تو این سالها زیاد شده. این تومور بیشتر جاهایی مثل لثه، دندون، فک، و مفصل گیجگاهی فکی رو درگیر میکنه، یعنی همون جایی که فک به جمجمه وصل میشه.

این نوع سرطان رو معمولا به سه دسته یا درجه تقسیم میکنن: “خوب تمایز یافته” (well-differentiated)، “تا حدی تمایز یافته” (moderately differentiated)، و “کم تمایز یافته” (poorly differentiated). هرچی به سمت کمتر تمایز یافته بری، بیماری خطرناکتر و کنترلش سختتر میشه. جالب اینه که نرخ ابتلا و مرگ و میر تو این مریضا واقعا بالاست.

حالا تا امروز روشای زیادی برای دستهبندی و تشخیص این درجات وجود داشته مثل AlexNet، CNN و U-Net و V-Net. اینا همشون مدلهای هوش مصنوعی هستن که تصاویر پزشکی رو بررسی میکنن. مثلاً CNN یعنی Convolutional Neural Network که همون شبکه عصبی کانولوشنیه و کلی تو پردازش تصویر کاربرد داره. اما مشکل این مدلها اینه که یا دقتشون پایینه (ACC یعنی Accuracy که همون درصد درست پیشبینی کردن مدله)، یا مقایسه بینشون سخته، یا داده کافی واسشون نیست، یا آموزششون خیلی طول میکشه و عملاً نمیشه روشون حساب باز کرد.

اینجا بود که یه تیم باحال اومدن یه روش جدید آوردن: مدل DeTr-DiGAtt! بذارین اسمشو باز کنم واستون: Deep Transformer Encoder-Assisted Dilated Convolution with Global Attention. این مدل از یه عالمه تکنولوژی بهروز و خفن استفاده میکنه که کارش تشخیص درجه OSCC تو عکسهاست. مثلاً Transformer Encoder یعنی یه لایه عمیق یادگیری که تو مدلهایی مثل ChatGPT و ترجمه اتومات قوی استفاده میشه. Dilated Convolution هم یعنی کانولوشنهای با فاصله که باعث میشه مدل ریزترین جزئیات تو تصویر رو بفهمه. Global Attention هم یعنی توجه سراسری مدل به همه جاهای عکس تا چیزی رو از قلم نندازه!

حالا برای اینکه مدلشون بهتر یاد بگیره و به کمبود داده نخوره، از GAN استفاده کردن. GAN یعنی Generative Adversarial Network که در واقع یه هوش مصنوعیه که خودش میتونه تصاویر واقعی و جدید تولید کنه تا مدل اصلی داده بیشتری برای آموزش داشته باشه. این، مشکل اوورسازی یا همون over-fitting رو هم حل میکنه که یعنی مدل فقط دادههای آموزش رو بلد نباشه و رو دادههای جدیدم خوب در بیاد.

بعد با فیلتر دوجانبه تطبیقی یا Adaptive Bilateral Filter (Ad-BF)، کیفیت عکسها رو بالا بردن و نویزای بیخودش رو گرفتن. نویز یعنی همون مزاحمت تصویری که تصویر رو تار یا قاطی میکنه.

برای بخشبندی (segmentation) دقیق قسمتهای سرطانی تو عکسها، از یه مدل پیشرفتهتر به اسم Improved Multi-Encoder Residual Squeeze U-Net یا همون Imp-MuRs-Unet استفاده کردن. این مدل، نسخه تقویتشده U-Net هست که قبلا هم گفتم یه مدل تخصصی برای بخشبندی تصویر تو پزشکیه.

در نهایت، مدل DeTr-DiGAtt اومده و این تصویرها رو براساس درجه سرطان دستهبندی کرده. واسه اینکه مدلشون بیشترین دقت رو بده، از یه الگوریتم خاص واسه تنظیم ابرپارامترها استفاده کردن به اسم Adaptive Grey Lag Goose Optimization Algorithm (Ad-GreLop). حالا این ابرپارامترها یعنی همون تنظیمات مهم مدل که تاثیر زیادی روی کاراییش دارن و این الگوریتم کمک میکنه که بهترین مقدارها رو پیدا کنی.

نتیجه چی شد؟ این روش خفن با دقت 98.59% (Accuracy)، امتیاز Dice 97.97% (Dice score یعنی میزان همپوشانی بین پیشبینی مدل و واقعیت)، و مقدار Intersection over Union یا IoU حدود 98.08% تونسته سرطان رو تشخیص بده که واقعاً عدد بالاییه و خیلی امیدبخش به نظر میاد!

پس خلاصه اینکه، با کمک هوش مصنوعی و این روش جدید، تشخیص و درجهبندی OSCC خیلی راحتتر و دقیقتر شده و امیدواری بیشتری واسه بیمارا و پزشکا آورده. واقعا تکنولوژی داره دنیا رو عوض میکنه!

منبع: +