حتماً براتون پیش اومده تو شبکههای اجتماعی مثل Reddit بگردین و ببینین که چقدر مردم راحت راجع به مشکلات سلامت روان خودشون حرف میزنن. خب یه سری محقق اومدن دقیقاً همین موضوع رو بررسی کردن و یه تحقیق جالب راه انداختن. میخوام خیلی راحت و خودمونی توضیح بدم دقیقاً چی کار کردن و به چه نتیجههایی رسیدن.

اول از همه، اینا اومدن یه مدل روانشناسی که اسمش Health Belief Model یا همون “مدل باور سلامتی” بود رو وسط کشیدن. حالا این مدل چیه؟ خلاصه بخوام بگم، یه مدل که میگه مردم چرا درباره یه بیماری یا تهدید سلامت یه جور خاص فکر میکنن، چی باعث میشه سراغ کمک برن یا برعکس، ازش فرار کنن. مثلا اینکه فکر میکنن ممکنه مریض بشن (حساسیتپذیری)، یا فکر میکنن بیماری واقعاً جدیه (شدت)، یا دیدن فایده و ضررهای کمک گرفتن، و حتی کاری که باعث میشه بالاخره یه اقدامی کنن (مثل یه تلنگر) و اینکه چقدر به خودشون اعتماد دارن (Self-efficacy یا همون خودکارآمدی که یعنی آدم فکر کنه واقعاً میتونه مشکلش رو حل کنه).

یعنی میخواستن بفهمن آدمایی که تو پستها درباره سلامت روان حرف میزنن، دقیقاً چطور درباره این چیزها فکر میکنن و چه احساسی دارن. برای این کار یه نمونهی ۵ هزار تایی از پستهای Reddit جمعآوری کردن و تازه یه قسمتیش رو دستی حتی بررسی و برچسب زدن! (یعنی کارشون هم تمیز، هم علمی بود.)

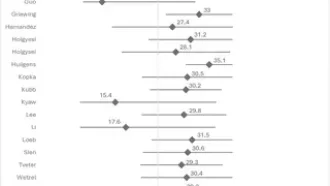

بعدش چندتا مدل مختلف یادگیری ماشینی (Machine Learning Models یعنی الگوریتمهایی که با داده آموزش میبینن و بعد خودشون چیزها رو شناسایی میکنن) رو امتحان کردن تا بتونن این مولفههای مدل سلامتی رو توی پستها تشخیص بدن.

حالا از سر و ته اگه بخوام بگم، مدل DistilBERT از همه بهتر جواب داد و تونست با دقتی بین ۷۵ تا ۸۴ درصد، بیشتر این مولفهها رو درست تشخیص بده. DistilBERT یه جور الگوریتم پیشرفته تو حوزه NLP یا همون پردازش زبان طبیعیه که کمک میکنه متنها رو بفهمن و دستهبندی کنن. البته تو فهمیدن شدت (Severity)، چون موضوع چندبرچسبی بود (یعنی ممکنه یه پست چند تا موضوع سنگین رو با هم داشته باشه)، دقتش پایین اومد و فقط ۴۷ درصد بود. برای همین، تیم تحقیق یه فکر بهتر کرد: اومدن از GPT-4 (که یکی از قویترین مدلهای زبان مصنوعی الان دنیاست) کمک گرفتن و با استخراج کلمات کلیدی و بعد بازبینی انسانی، دقت رو تا ۸۱ درصد رسوندن!

یه بخش جالب دیگه تحلیل احساسات تو پستها بود. اومدن با استفاده از چیزهایی مثل Word Cloud (که یه جور نمایش تصویری کلماته و هرچی کلمه بیشتر استفاده شده باشه بزرگتر نشون داده میشه)، هیتمپ (یعنی نقشه حرارتی برای نمایش فراوانی دادهها)، و تحلیل احساسات، دیدن وقتی مردم حس میکنن یه تهدید جدیه، مثلاً خطر خودکشی یا اضطراب شدید، خیلی بیشتر از جملات منفی یا ناراحتکننده استفاده میکنن. حتی نکته مهم این بود که خیلی از کاربرا ریشه اضطراب رو به شخصیت خودشون ربط می دادن، یعنی یه جورایی خودشون رو مقصر میدونستن، که اینم خودش کلی دردسر داره و نشون میده باید چقدر برای مداخلات هدفمند (یعنی کمکرسانی دقیق به آدمایی که مشکل جدی دارن) تلاش کنیم.

در نهایت تیم تحقیق پیشنهاد کردن که برای آینده، مدلها باید خودشون رو بیشتر با دادههای سلامت روان منطبق کنن، بتونن خیلی دقیقتر احساسات خاص و جزئی رو تو نوشتهها پیدا کنن، با کلمات نادر و عجیبغریب بهتر کنار بیان و البته به بحثهای اخلاقی نظارت روی حرفای مردم هم حسابی توجه بشه (یعنی اینکه وقتی دادههای مردم رو بررسی میکنی، هوای حریم خصوصی و اخلاق رو داشته باشی).

در کل، این تحقیق نشون داد با همه هوشمندی و قدرت مدلها، هنوزم نیاز به دست آدم و دقت انسانی، مخصوصاً تو کارای حساس مثل سلامت روان، خیلی بالاست و نباید همه چی رو بسپریم به هوش مصنوعی. ولی همین الان هم میشه کلی از الگوهای فکری و حسی آدمها رو تو شبکههای اجتماعی ردگیری کرد و براشون فکری جدی کرد.

منبع: +