خب بچهها بذارین خیلی راحت و خودمونی کل ماجرا رو تعریف کنم! موضوع این مقاله راجع به همون رباتهایی هست که داخل کامپیوتر کار میکنن، مثلاً یه سری کار رو تو فضای وب یا نرمافزار انجام میدن بدون اینکه خودمون مستقیم کنترلشون کنیم. به اینا میگن Computer Use Agents یا همون CUA، یعنی “عاملهایی که برامون با رابطهای گرافیکی (مثل ویندوز یا وبسایتها) کارهای مختلف انجام میدن”.

مشکل اصلی این رباتها اینه که برای اینکه حسابی باهوش بشن و بتونن کارهای واقعی و پیچیده انجام بدن، باید کلی داده دقیق بهشون داد و کلی آموزش ببینن. ولی جمع کردن این دادهها خیلی گرونه چون باید آدم واقعی بیاد بشینه کلی کار درست انجام بده تا ربات یاد بگیره. تازه خیلی وقتها این دادهها کافی و کامل هم نیستن.

حالا راه حل چیه؟ تا الان بعضیا اومدن با همین دادههایی که آدمها به صورت دستی درست کردن، مدلها رو آموزش دادن. ولی این مقیاسپذیر نیست؛ یعنی هر چقدر مدل بزرگتر یا متنوعتر بشه، دیگه نمیتونیم همیشه از نیروی انسانی استفاده کنیم چون زمان و پول زیادی میبره.

ایده جدید مقاله اینه: «خب اساساً چرا به جای آدمها، از خود رباتها استفاده نکنیم که خودشون کار کنن و داده بسازن؟!» ولی یه اشکال بزرگ اینجا هست؛ رباتهایی که خودشون هنوز صددرصد دقیق نیستن، وقتی یه کار واقعی انجام میدن، کلی حرکت اشتباه دارن. مثلاً فرض کنین یکی از هر ده حرکتش درسته، بقیهاش خرابه! این میشه داده پر از نویز و خطا که نمیشه روش حساب کرد.

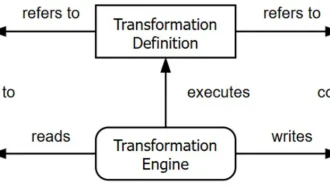

حالا نویسندهها اومدن یه حقهی بامزه زدن که بهش میگن “Step-level Filtering” یا همون فیلترینگ مرحلهای. این یعنی به جای اینکه کل یه کار یا وظیفه رو قبول یا رد کنیم، میایم دونهدونه همه مراحل رو چک میکنیم؛ هر کدوم از قدمها که درست بود رو نگه میداریم و بقیه رو پرت میکنیم دور! اینجوری یه عالمه داده باکیفیت و قابل اعتماد درمیاد، اونم بدون اینکه نیازی به بررسی یا برچسبگذاری توسط آدم باشه.

علاوه بر این، نویسندهها از چیزی که بهش میگن “Reasoning Augmentation” — یعنی تقویت فرایند تصمیمسازی و برنامهریزی مدلها با استدلال بیشتر — هم استفاده کردن تا حرکتهای بهتری از مدلها بیرون بکشن.

نتیجه این شد که تونستن یه دیتاست خیلی خفن به اسم WebSTAR درست کنن که شامل ۱۳،۳۰۰ تا مسیر انجام کار (بهش میگن trajectory) و ۱۰۰،۰۰۰ قدم درست و بااستدلال هست که همه رو با مدل OpenAI ساختن! دیگه لازم نیست کلی آدم استخدام کنی تا داده بسازن.

بعد با همین WebSTAR اومدن دو تا مدل معروف آموزش دادن، به اسم Qwen-2.5-VL-Instruct؛ یکی با ۷ میلیارد پارامتر، یکی با ۳۲ میلیارد. (پارامتر یعنی همون بخشهای قابل تنظیم هوش مصنوعی که هرچی بیشتر باشه مدل قویتره.)

جالبیش اینجا بود که مدل سبکترشون (همون ۷B) تونست توی یه تست خیلی مهم به اسم WebVoyager از مدل معروف UI-TARS-1.5-7B هم بیشتر از ۱۵٪ بهتر کار کنه — اونم فقط با آموزش بر اساس همین داده درست شده و بدون هیچ ترفند اضافهای!

ولی اینجا داستان تموم نمیشه. با همین ایده “امتیازدهی مرحلهای” (Step-level Grading)، یه دیتاست جدید هم درست کردن به اسم WebSCORE که توش هر قدم جدا جدا امتیازدهی شده. روی همین WebSCORE، یه مدل تشویقی (که بهش میگن Reward Model) به اسم StepRM درست کردن که کارش اینه بفهمه هر کار چقدر خوب بوده.

نکته جالب: این مدل StepRM با اینکه کوچیکتر و سریعتر از مدل اصلی o4-mini هست، ولی کیفیت امتیازدهیش عملاً مثل همونه، یعنی میتونه راحت و درست تو کارهای بزرگ و واقعی استفاده شه.

جمع بندی خودمونی: این کار نشون داده که اگه برای آموزش این رباتهای کامپیوتری به جای دادههای انسانی، دادههای ماشینی رو با یه سیستم فیلترینگ مرحلهای دقیق بسازیم، هم سریعتر پیشرفت میکنن، هم ارزانتر میشن، هم وقت کمتری صرف میشه. حاصل داستان هم دوتا دیتاست کاربردی (WebSTAR و WebSCORE) و یه مدل جایزهدهی سبکتر (StepRM) هست که هر کسی میتونه ازشون برای آموزش مدلهای هوشمند خودش اَستفاده کنه. خلاصه، یک قدم مهم برای رباتهای مجازی باهوشتر و همهفنحریف!

منبع: +