خب بچهها، بیاید یه موضوع مهم و دوستداشتنی رو با هم بررسی کنیم: آیا مدلهای هوش مصنوعی که برای پیشبینی وضعیت بیماران تو بیمارستانها استفاده میشن، واقعاً بیطرف و دقیق هستن؟!

یه تیم باحال از متخصصهای مختلف، یه دیتاثان (Datathon یعنی یه جور ماراتون داده؛ همه جمع میشن تا با دادهها ور برن و یه مسئله حل کنن) دو روزه برگزار کردن تا همین موضوع رو زیر ذرهبین ببرن. هدفشون این بود که بفهمن آیا مدلهای یادگیری ماشین پزشکی ممکنه یه جاهایی نسبت به بعضی از افراد یا گروههای بیمارها تبعیض قائل بشن یا نه، مخصوصاً مدل GOSSIS-1 که یه نمرهبندی بازمتن برای پیشبینی شدت بیماریه. (Open Source یعنی کدش آزاد و همه میتونن دسترسی داشته باشن.)

تو این دیتاثان، ۵ تا تیم شرکت داشتن که سهتاشون هم آدمایی بودن که هم تو پزشکی تجربه داشتن و هم تو انفورماتیک (Informatics یعنی شغلهایی که کارشون مدیریت اطلاعات و دادهست، مخصوصاً تو رشته سلامت). اکثر تیمها با پایتون کار کردن (برنامهنویسی معروف و دوستداشتنی مخصوص تحلیل دادهها!) و فقط یه تیم با R کار کرد.

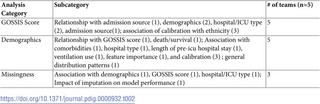

خب تیمها چه کارایی کردن؟ هر کدوم اول فرضیه خودشون رو چیدن (Hypothesis یعنی حدس علمی درباره اینکه چی ممکنه باعث سوگیری بشه)، بعد رفتن سراغ دادهها و حسابی تحلیلشون کردن ببینن آیا مدل هوش مصنوعی برای همه یکسان پیشبینی میکنه یا نه. چند تا موضوع اصلی که بررسی کردن اینا بودن:

- رابطه بین پیشبینیهای مدل GOSSIS-1 و ترکیب جمعیتی بیماران (مثلاً سن، جنسیت، قومیت و غیره)

- اینکه آیا برای افراد با خصوصیات مختلف، مدل پیشبینی متفاوتی انجام میده یا نه

- تاثیر عواملی مثل نوع مراقبت یا حتی اینکه دادههای بعضی بیماران ناقص بود یا نبود (Missingness یعنی بخشی از دادهها جا افتاده باشه)

- کلاً مدل چه جوری تو محیطهای بیمارستانی مختلف عمل میکنه

نتایج چی شد؟ خب چند تا نکته جالب پیدا شد! مثلاً اینکه:

- جمعیت مورد بررسی ممکنه نماینده همه نباشه؛ یعنی اگه یه مدل رو فقط با دادههای یه گروه خاص آموزش داده باشن، واسه بقیه خوب جواب نمیده. به این میگن بحث Representativeness یا نمایندگی دادهها.

- یه جاهایی مدل برای بعضی گروهها بهتر عمل میکرد و برای بعضیا بدتر! مثلاً مدل میتونست روی یه قومیت نتایج دقیقتری بده اما روی یه گروه دیگه پس بزنه. این یعنی مشکل Bias (سوگیری).

- حتی بین بیمارستانهای مختلف، کارایی مدل فرق میکرد. پس نمیشه گفت یه مدل برای همه جا و همه کس خوبه.

- یه چیز دیگه هم فهمیدن: اینکه کم بودن یا ناقص بودن دادهها میتونه باعث شه مدل اشتباه کنه یا اصلاً برای بعضی گروهها جواب نگیره.

در کل، این دیتاثان نشون داد واسه اینکه مدلهای یادگیری ماشین واقعاً عادلانه باشن، باید حواسمون باشه که دادهها، پیشفرضها و روش طراحی مدل ممکنه خودشون سوگیری بیارن. تازه این فقط مخصوص مدل پزشکی نیست! تو هر جایی که از هوش مصنوعی استفاده میشه، حواسمون باید جمع باشه.

در نهایت بچهها، این تجربه نشون داد که دیتاثانها (این مسابقههای تیمی دادهای) واقعاً میتونن ذهن آدم رو باز کنن و باعث شن مردم به مشکلات زیرپوستی مدلهای هوش مصنوعی بیشتر فکر کنن. خلاصه اگه دفعه بعد یکی گفت مدل یادگیری ماشین ما کاملاً بیطرفه، بدونین واقعاً باید با شک و سوال بهش نگاه کنین!

منبع: +