یه بحران اساسی سلامت روان تو دنیا داریم. طبق آمار سازمان جهانی بهداشت، بالای یه میلیارد نفر تو دنیا دچار مشکلهای سلامت روان هستن! مخصوصاً بین جوونها، اضطراب و افسردگی هر روز بیشتر میشه و متاسفانه هر سال صدها هزار نفر به خاطر خودکشی جونشون رو از دست میدن. واقعاً عجیبه که هنوز خدمات سلامت روان کافی و ارزون برای همه فراهم نیست، واسه همینم خیلیها سراغ تکنولوژی و هوش مصنوعی رفتن تا شاید یه راهحلی پیدا کنن.

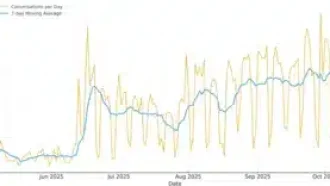

الان میلیونها نفر دارن با چتباتهایی مثل ChatGPT از OpenAI یا Claude از Anthropic حرف میزنن، یا کلی اپلیکیشن خاص مثل Wysa و Woebot رو نصب کردن که برای رواندرمانی با هوش مصنوعی طراحی شدن. دانشمندها حتی دارن روی این کار میکنن که با ساعتهای هوشمند و وسایل پوشیدنی (Wearables) مثل دستبند سلامتی یا گوشی، اطلاعات رفتار و وضعیت جسمی روان افراد رو جمع کنن و با پایگاه دادههای بزرگی تجزیه و تحلیل کنن تا شاید چیزای جدیدی کشف شه. حتی قراره این سیستمها به روانشناسهای واقعی هم کمک کنن تا کمتر دچار فرسودگی شغلی بشن!

ولی خب، این آزمایش عظیم هنوز به جواب مشخصی نرسیده. یه عده تونستن واقعاً از این چتباتها آرامش بگیرن و بعضی متخصصها هم امید دارن این مدلها یه روزی درمانگر خوبی بشن. اما، بعضیها به خاطر حرفای گمراهکننده یا بیش از حد موافق چتباتها (که بهش Sycophancy میگن، یعنی کسی که همیشه فقط تأیید میکنه)، حسابی گیج و حتی روانپریش شدن! بدترش اینه که بعضی خانوادهها شرکتهای سازنده این چتباتها رو به خاطر تأثیر غیرمستقیم در خودکشی عزیزانشون تحت پیگرد قانونی قرار دادن. حتی خود مدیرعامل OpenAI گفته تقریباً هفتهای یه میلیون نفر با ChatGPT درباره خودکشی صحبت میکنن! این واقعاً عدد دلهرهآوریه.

تو ۲۰۲۵ حسابی سوژه داستانای غیرمنتظره شدیم؛ هم درباره رابطهی آدما و چتباتها، هم ضعیف بودن محافظتهای این هوش مصنوعیها (به Guardrails میگن: تنظیمهایی که اجازه نمیدن ربات حرف یا توصیه آسیبزننده بزنه) و هم نگرانی درباره اینکه اطلاعات شخصی و حساسی که به این برنامهها گفتیم، شاید یه روزی توسط شرکتهای بزرگ به پول تبدیل بشه.

📚 چندتا کتاب خوندم که دقیقاً با همین موضوع درگیر بودن. اولیش اثر شارلوت بلیز (Charlotte Blease) به اسم “Dr. Bot: Why Doctors Can Fail Us—and How AI Could Save Lives” بود. بلیز (که یه فیلسوف پزشکیه) هم خوبیها رو نشون میده هم اخطار میده. مثلاً میگه الان سیستمهای درمانی زیر فشار مردم دارن له میشن، دکتر کم داریم، صف انتظار طولانیه… هوش مصنوعی میتونه این فشارِ روی دکترها رو کمتر کنه و حتی به کسایی کمک کنه که از ترس قضاوت یا ترس عمومی اصلاً به روانشناس مراجعه نمیکردن.

ولی بلیز هم هشدار میده که مثلاً هوش مصنوعی همیشه جوابهای مطمئن و ایمن نمیده، یا اینکه نکته حریم خصوصی خیلی مهمه! الان قانونهایی مثل HIPAA (یه قانون تو آمریکا برای حفظ محرمانگی دادههای سلامتی بیمار) فقط برای روانشناسهای رسمی صدق میکنه، نه برای شرکتهای هوش مصنوعی. خود بلیز تجربههای شخصی سنگینی داشته؛ از دست دادن خواهر و یه عزیز دیگه به خاطر بیماریهای صعبالعلاج و وضعیت بد سیستم درمانی رو از نزدیک دیده.

کتاب دیگهای که خوندم رو دنیل اوبرهاوس نوشته به اسم “The Silicon Shrink”. ماجرای دردناکی داره؛ اوبرهاوس وقتی خواهرش رو به خاطر خودکشی از دست داد، ساعتها به گشتن تو ردپای دیجیتال خواهرش گذروند. پیش خودش فکر کرد شاید اگر نرمافزاری یا الگوریتمی وجود داشت که از روی پیامها و فعالیت دیجیتال افراد بفهمه چه وقتی حالشون خرابه، میشد زودتر کمکشون کرد. این ایده بهش میگن دیجیتال فنوتایپینگ (Digital Phenotyping)، یعنی جمعکردن و تحلیل رفتارهای دیجیتال افراد برای فهم سلامتی روانشون.

اما اوبرهاوس میگه اینا رو نباید خیلی سادهلوحانه نگاه کنیم! چون روانپزشکی کلاً هنوز هم توش کلی ابهامه، خود علل بیماریهای روانی هنوز کاملاً معلوم نیست، حالا اگر دادههای دقیق جمع کنیم ولی خود تفسیر دچار مشکل باشه، چه فایده؟ اوبرهاوس یه اصطلاح جالب داره: سوایپ سایکاِتری (Swipe Psychiatry)؛ یعنی تصمیمگیری درباره سلامت روان فقط بر اساس دادههای دیجیتال و کلینیکی، میوفته دست الگوریتمها و دیگه انسان کمتر بررسی میشه. اون معتقده اینطوری مهارت و تشخیص روانپزشکهای واقعی هم سست و وابسته به ماشین میشه.

به نگرانی دیگهای هم اشاره میکنه: وقتی آدمها راحتترین و عمیقترین حرفاشون رو به چتبات میگن، این اطلاعات، سرمایه شرکتها میشه و عملاً حریم خصوصی و آزادی و کرامت افراد به خطر میوفته. اوبرهاوس معتقده اگر این مسیر ادامه پیدا کنه، همهمون میشیم زندانیهای دیجیتال یه تیمارستان الگوریتمی، بدون حتی دیوار! دادههامون همهجا زیر ذرهبینه؛ از خونه و مدرسه تا دادگاه و سربازخونه.

حالا ایوین فولام (Eoin Fullam) توی کتابش “Chatbot Therapy: A Critical Analysis of AI Mental Health Treatment” نقدش به سیستمای خودکار رواندرمانی برمیگرده. فولام قضیه رو از زاویه سرمایهداری میبینه. به نظرش شرکتهای پشت این اپها گاهی منافع مالی رو به سلامت کاربران ترجیح میدن. خب، هر جلسه مشاوره دیجیتالی داده میسازه، بعد این دادهها میشن سوخت ادامه این چرخه و پول بیشتر؛ یعنی هرچی درمان موثرتر به نظر بیاد، بیشتر از اطلاعات کاربرا برای پول درآوردن استفاده میشه، تا جایی که آدم نمیفهمه اینجا واقعاً درمانه یا تجارته!

فولام میگه درست نیست که همه فناوریها الزماً کارهای بد و خلاف منافع مردم انجام بدن، اما این ریسک همیشه هست. به قول خودش، اینجا انگار با یه “اُرابوروس (Ouroboros)” طرفیم؛ افعی افسانهای که خودش رو میخوره، یعنی این چرخه مالی-درمانی خودش رو تقویت و تبدیل به حلقهی بسته میکنه.

یه مثال بامزه هم تو رمان “Sike” از فرد لانزر اومده: داستان یه پسر لندنی به اسم آدریان که با یه دختر باهوش آشنا میشه و برای درمان اضطرابهاش از یه هوش مصنوعی رواندرمان استفاده میکنه. این Sike حتی حرکات بدن، لحن حرف زدن، احساسات و جزئیترین چیزهای روزمره مثل خنده، گریه، لباس پوشیدن و… رو هم تحلیل میکنه (اینجا یعنی یه فناورِ دیجیتال فنوتایپینگ کامل!). جالب اینجاست که Sike یه کالای لوکسه، فقط واسه پولدارا: ماهی ۲۰۰۰ پوند اشتراکش!

رمان نشون میده آدمای مایهدار، داوطلبانه خودشون رو توی یه تیمارستان دیجیتال زندانی میکنن، در حالی که دورهمی شام میخورن و خوش میگذرونن! ولی تهش میگه این فناوریها انگار از آینده اومدن، ولی در واقع بیش از نیم قرنه که دارن روش کار میکنن؛ حتی کارل سیگن – همون اخترشناس معروف – یه زمانی پیشبینی کرده بود شبکهای از کیوسکهای رواندرمانی کامپیوتری تو سراسر شهرها درست میشه.

از اون ور، اوبِرهاوس یادآوری میکنه که اصلاً اولین شبکه عصبی مصنوعی (Perceptron، به معنی یه مدل الهام گرفته از مغز که میتونه یاد بگیره)، کارِ یه روانشناس به نام فرانک روزنبلات تو ۱۹۵۸ بود، نه از ریاضیدونها! اصلاً اولین شبیهِ رواندرمانگر کامپیوتری هم تو دهه ۱۹۶۰ درست شد: یه برنامه به اسم ELIZA توسط جوزف وایزنباوم (Joseph Weizenbaum). وایزنباوم یه انتقاد تاریخی داشت: حتی اگر کامپیوتر بتونه تصمیم درست بگیره، نباید هرگز قضاوت و تشخیص روانی رو بهش داد، چون اصلاً پایه این تشخیصها رو قبول نداشت.

به نظر میاد حالا که درمانگرهای هوش مصنوعی دارن سریع فراگیر میشن، باید حواسمون باشه: همیشه بین نیت خوب و سوءاستفاده از دادهها، یه دیوار نازک هست. ممکنه به اسم کمک به بیماران، راههای دیگهای به روی آزادی و حریم خصوصی بسته بشه. خلاصه اینکه هوش مصنوعی تو سلامت روان، هم میتونه امید باشه هم خطر؛ باید هوشیار باشیم.

(نویسنده مقاله: بکی فریرا، خبرنگار علمی آمریکایی)

منبع: +