اگه تا حالا فکر کردی AIها چطور عکسارو میبینن و دربارهشون نتیجه میگیرن، این مقاله دقیقاً به دردته! حالا بین خودمون باشه، این روزا هوش مصنوعیها فقط یه مدل ساده نیستن که مثلاً فقط عکسو ببینه یا فقط متن بخونه — اکثرشون چندتا “عوامل” (agent) مختلف دارن، که هرکدوم یه کار خاص رو انجام میده. مثلاً یکی کار بینایی رو انجام میده، یکی منطقی فکر میکنه (مثلاً جمعبندی میکنه و تصمیم میگیره)، یکی هم مرتب میگرده توی دیتابیسهای بزرگ و کلی اطلاعات جمع میکنه. همه اینا رو کنار هم گذاشتی؟ خب حالا وقتشه اعتماد کنی! ولی چجوری؟

اول بذار اینو توضیح بدم: توی حالت “Zero-shot” قضیه یه کم جالب میشه. Zero-shot یعنی مدل هیچ آموزش خاصی روی دیتای خودت ندیده و فقط با همون اطلاعات کلی و خامی که داره، باید جواب بده! خیلی سخته دیگه و معمولاً احتمال اشتباهکردن مدل میره بالا. خب حالا فکر کن یه سیستم درست کردن که با همین شرایط سخت هم سعی میکنه بهت جواب درست بده و بازم بفهمه چقد میتونی بهش اعتماد کنی یا نه!

تیتر داستان:

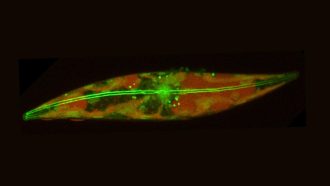

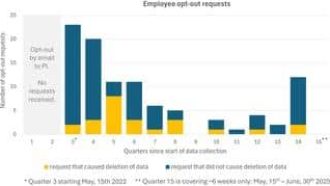

یک تیم تحقیقاتی باحال اومده یه چارچوب جدید ساخته که ترکیبی از چندتا agent (عامل) عمومی و چندتا ماژول فکرکن! سیستم خروجیش قشنگ مال تشخیص بیماری برگ سیب رو شبیهسازی کرده (آره، همونا که رو درخت میان و باغدارها کلی دردسر میکشن!). سه حالت مختلف رو برای کارشون تست کردن:

۱. حالت همهچی خام (Zero-shot): مدل رو آموزش ندادن، ولی با یه ترکیب خاص از ماژول “اعتماد به جواب نوی عامل” راه انداختنش.

۲. حالت آموزشدیده (Fine-tuned): مدل رو با دیتای خاص آموزش دادن، عملکردش بهتر میشه.

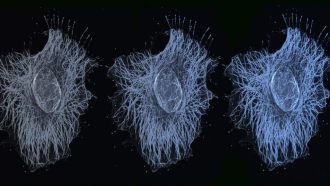

۳. حالت پیشرفته و قابل اعتماد: این بار علاوه بر ماژول orchestrator (همون مدیر مغز تیم که تصمیم میگیره کی حرف کی رو قبول کنه)، از روشی به اسم RAG و سیستمهای تصویری CLIP هم استفاده کردن تا شبیهترین تصاویر به عکس ورودی رو پیدا کنه و دوباره ارزیابی کنه. (بذار ساده بگم رفقا: RAG یعنی Retrieval-Augmented Generation، یعنی جواب دادن و تحلیل کردن با کمک جستجوی اطلاعات مرتبط. CLIP هم یه مدل هوش مصنوعیه که عکس و توضیحات متنی رو کنار هم یاد میگیره، اینطوری مثلاً اگه ازش بپرسی سیب کدومه، تو عکس شناساییش میکنه.)

حالا ریز کاریها و نتایج:

این سیستم برای اینکه بفهمه واقعاً قابل اعتماده یا نه، از شاخصهایی مثل ECE، OCR و CCC استفاده کرده (اینارو متر اضافه کن: ECE یعنی Expected Calibration Error، یه جور اندازهگیریه که میگه اعتماد AI به خروجیش چقد با واقعیت میخونه. OCR و CCC هم همینطور، اندازهگیریهای دقت اعتماد و همخوانی پیشبینی با واقعیته).

وقتی سیستم با کمک ماژول اعتماد (Trust-aware Orchestration) و RAG تنظیم شده، تونستن دقت جوابدهی رو تو حالت صفر (Zero-shot) تا حدود ۷۷.۹۴٪ بالا ببرن! در مجموع هم بالای ۸۵٪ عملکرد داشتن — فوقالعاده است برای شرایطی که هیچ آموزش خاصی به مدل داده نشده باشه.

جالب اینجاست که وقتی مدل GPT-4o رو تست کردن (همون مدل معروف متنباز OpenAI)، دیدن دقتش روی کالیبرهکردن اعتماد بهتره، یعنی وقتی مطمئنه احتمالاً نتیجه واقعاً درسته! اما یه مدل دیگه به اسم Qwen-2.5-VL بیشازحد اعتماد به نفس داشت و اشتباه میکرد یعنی Overconfident بود (overconfident یعنی مدل فکر میکنه کاملاً مطمئنه، ولی گول میخوره!).

یه نکته خفن دیگه: با کمک همین RAG، اگه مدل مطمئن نبود یا مشکوک جواب داد، بازم یه دور دیگه عکسها و جوابها رو با هم مقایسه میکنه و دوباره نظر میده — یعنی یه جور سیستم رجوع و بازبینی.

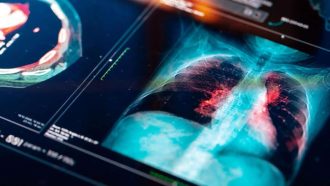

اصلاً اصل داستان اینه که perception یا همون درک تصویری (تشخیص بیماری روی عکس برگ سیب)، کاملاً جدا از meta-reasoning یا همون تصمیمسازی و مدیریت سیستم کار میکنه! اینطوری هر بخش قابل توسعه و تفسیره، یعنی هر وقت خواستی میتونی براش توضیح بدی چی کار میکنه یا حتی عوضش کنی. این مدل راحت میشه برای حوزههایی مثل تشخیص پزشکی، زیستشناسی و حتی جاهایی که اعتماد به AI خیلی مهمه گسترشش داد.

آخرشم نگه نداشتن واسه خودشون! کل نرمافزار، کدها، مدلها و نتایج رو روی گیتهاب قرار دادن تا هرکسی بتونه بررسی، تست یا ارتقاش بده. اگه دوست داشتی سرتو از پنجره بیرون بیاری و یه پروژه قابل اعتماد هوش مصنوعی بررسی کنی، این لینکشه:

https://github.com/Applied-AI-Research-Lab/Orchestrator-Agent-Trust

خلاصه، این روزا بحث اعتماد به هوش مصنوعی خیلی پیچیده شده؛ اگه یه بار خواستی یه سیستم ایجاد کنی که بتونی روش حساب کنی، حتماً این مودل کار آزمایششده رو چک کن. هم یادمیگیری چطور به agentها درست اعتماد کنی، هم سیستم Modular و قابل توسعه خواهی داشت! خیال راحت باش، میتونی همه بخشهاشو ببینی و حتی خودت امتحانش کنی. 😉

منبع: +