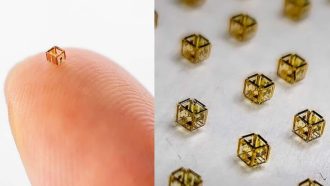

خب بچهها، داستان از این قراره که سم آلتمن، مدیرعامل OpenAI (همون شرکتی که مثلاً ChatGPT رو ساخته)، این روزا رویاهای خیلی بزرگی تو سر داره! قضیه از این قراره که گفتن تا آخر سال ۲۰۲۵، میخوان بیشتر از یک میلیون GPU (کارت گرافیک، همون قطعههایی که عموماً توی کامپیوترهای گیمینگ هم هستن و الان شده ابزار اصلی آموزش مدلهای هوش مصنوعی) رو آنلاین داشته باشن و باهاش مدلهای هوش مصنوعیشون رو آموزش بدن. جالبه بدونین الان هیچکدوم از شرکتهای رقیب حتی نزدیکش هم نیستن.

ولی خب این فقط شروعشه! سم آلتمن یه چیزی گفته که کلهی همه رو ترکونده: “میخوایم تا آینده نزدیک برسیم به ۱۰۰ میلیون GPU!”. یعنی اگه الان براتون سواله که مثلاً بزرگترین رقیباشون چند تا GPU دارن باید بگم مثلاً شرکت xAI ایلان ماسک، کل مدل Grok 4 (یه مدل هوش مصنوعی که داداشِ ChatGPT حساب میشه) رو با فقط ۲۰۰ هزار تا GPU راه انداخته. حالا از این نگاه کنین OpenAI که قراره به یک میلیون GPU برسه، یعنی ۵ برابر xAI! اما وقتی سم میگه ۱۰۰ میلیون، یعنی باید ۱۰۰ برابر این عدد فعلی کنه.

حالا خب بیایم واقعبین باشیم. اگه کسی واقعاً بخواد ۱۰۰ میلیون کارت گرافیک رو به کار بندازه، خرجش چقدر میشه؟ تقریباً ۳ تریلیون دلار! یعنی مبلغی که اصلاً بقیه شرکتها تو خواب هم نمیبیننش. جدا از پولش، اصلاً تامین برق و تولید فیزیکی این همه کارت، خودش معضل بزرگیه. چون اگه واقعاً این تعداد کارت گرافیک رو بتونن رو پا نگه دارن، شاید حتی زیرساختهای برق دنیا هم تحمل نکنه! (یعنی برق دنیا رو میکشه پایین!)

آلتمن خودش هم خیلی شاد اینو نوشته: “خیلی به تیممون افتخار میکنم ولی حالا باید برن حسابی کار کنن و ببینن چطوری میشه صد برابرش کنیم! خندهدار شده واقعا!”

حالا بریم سراغ اتفاقات فنیتر و شرکتی! OpenAI فعلاً بیشتر کاراش رو روی سرویس ابری آژور مایکروسافت انجام میده (ابر یعنی دیتاسنترها و سرویسهایی که سرورها و پردازش رو میدن دست شرکتها). اما اونا دارن با Oracle هم همکاری میکنن و حتی دنبال اینن از شتابدهندههای TPU گوگل استفاده کنن. (TPU یعنی شتابدهندههایی که مخصوص کار هوش مصنوعیه و توسط گوگل توسعه داده شدن. کارشون اینه که کارای هوش مصنوعی رو خیلی سریع و بهینه انجام بدن).

در واقع این کار نشون میده که OpenAI با ظرفیت فعلی سرویسهای ابری خیلی حال نمیکنه و دنبال گزینههای بیشتریه. غیر از اونا، تو این حوزه شرکتهای بزرگی مثل Meta (فیسبوک)، آمازون و خود گوگل هم دارن میرن سمت این که چیپهای مخصوص خودشونو بسازن و حافظههای قویتری مثل HBM استفاده کنن. (HBM یعنی High-Bandwidth Memory، یه مدل حافظه خیلی سریع و با ظرفیت بالاست که کمک میکنه کارت گرافیک بتونه حجم زیادی داده رو خیلی سریع پردازش کنه)

یه شرکت کرهای به اسم SK Hynix خیلی تو این بازار داره سود میکنه چون هرچی نیاز به GPU بیشتر شه، نیاز به HBM هم بالاتر میره و اونا هم سازنده بهروز این جور حافظهها هستن. جالبه بدونین که حتی بعضی وقتا خودِ شرکتهای سفارشدهنده مثل OpenAI میان و به SK Hynix میگن باید دقیقاً فلان مدل GPU یا HBM رو برامون بسازین! یعنی سفارشیسازی کامل.

لو رفت که پارسال رییس SK Group و مدیرعاملش با سم آلتمن جلسه زدن تا بیشتر تو زنجیره تامین سختافزارهای مربوط به هوش مصنوعی نقش بازی کنن. این رابطه از قبلاً هم بوده؛ مثلاً SK Telecom (شرکت مخابراتی کره) قبلتر وارد رقابت جدی با ChatGPT شده بود و تو پروژه MIT GenAI Impact Consortium مشارکت داشتن (یعنی یه جمع از دانشگاه MIT و چندتا شرکت بزرگ که رو تاثیر هوش مصنوعی تو دنیا کار میکنن).

البته این گسترش عجیب OpenAI باعث نگرانی بعضی سرمایهگذارها هم شده. شنیدهها میگن حتی SoftBank (یه شرکت ژاپنی عظیم که کلی شرکت فناوری رو سرمایهگذاری میکنه) شاید سر سرمایهگذاریش تو OpenAI یه کم مکث کنه!

اما فقط پول نیست که مشکل ایجاد میکنه؛ حتی اگه سرمایه بیاد، باز این حجمی از کارت گرافیک و سرور نیاز به نوآوریهای خیلی بزرگ تو راندمان انرژی، تولید قطعات، و کل زیرساخت برق جهانی داره. فعلاً بیشتر شبیه یه آرزو و پیام بلندپروازانهست تا یه برنامه اجرایی واقعی. اما این آرزوها گاهی دنیا رو عوض میکنن!

خلاصه اگه یه روزی دیدی اینترنت کنده یا تو خیابونها کم مونده تیر چراغ برقها منفجر شه (!) بدون شاید OpenAI داره رویاهاشو اجرایی میکنه! قراره هوش مصنوعی به جاهای عجیبی برسه، فقط باید دید این حجم از کارت گرافیک واقعاً عملی میشه یا نه.

منبع: +