خب بچهها، بیاید با هم یه موضوع داغ و مهم دنیای هوش مصنوعی رو شیر کنیم. تا حالا حتماً اسم مدلهای زبان بزرگ مخصوص کدنویسی (یا همون Code LLMs) به گوشتون خورده؛ مثلاً همونا که میتونن خودشون کد بنویسن و کلی به برنامهنویسا کمک کنن. مثلاً Copilot یا CodeWhisperer. این مدلها خیلی باحالن و حسابی تو تست و ساخت نرمافزارها دارن غوغا میکنن. اما یه نکتهی خطرناک هم دارن: گاهی، تو شرایط خاص، به راحتی کدهایی تولید میکنن که آسیبپذیره یا حتی میتونه به درد کارای مخرب بخوره! یعنی چی؟ یعنی اگه یکی بلد باشه چطوری گولشون بزنه، میشه ازشون کدهای باگدار یا بدجنس بیرون کشید.

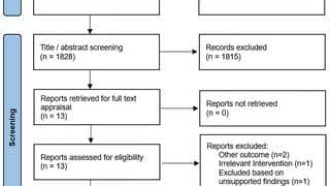

تا الان، برای اینکه این مدلا رو امتحان کنن و بفهمن ضعفاشون چیه، باید کلی نیروی انسانی بذارن تا باهاش حرف بزنن، سوال ازش بپرسن، یا مثلاً تلاش کنن مشکل ازش بکشن بیرون. به این کار میگن «red teaming»؛ یعنی انگار یه تیم قرمز داری که کارش اینه مدل رو به چالش بکشه و ایمنیشو بسنجونه. اما واقعیت اینه که روشهای قدیمی red teaming اصلاً مقیاسپذیر و عملی نیستن. چون خیلی به آدم وابستهن و مثلاً فقط یه تلاش یا سؤال محدود انجام میدن، ولی تو دنیای واقعی کدنویسی، گفتوگو با هوش مصنوعی معمولاً تو چند نوبت انجام میشه و اصلاً یهویی خلاصه نمیشه!

اینجاست که «ردکُدر» (RedCoder) وارد میشه! ردکُدر در واقع یه مدل هوش مصنوعی جدیده که خودش نقش همون تیم قرمز رو بازی میکنه؛ اما این بار واقعاً حرفهای و خودکار. ردکُدر میتونه تو چندین نوبت (مثلاً گفتوگوی چندمرحلهای یا multi-turn conversation) یه مدل تولید کد رو حسابی به چالش بکشه تا ازش کدی با آسیبپذیری (یعنی کد باگدار یا قابل سواستفاده برای هکرها) بیرون بکشه.

حالا ساخت ردکُدر چطوریه؟ اول میان و با یه بازی چند عامله (multi-agent gaming process) شرایطی رو شبیهسازی میکنن که آدما یا مدلها عمداً با مدل تولید کد (مثلاً اون LLM اصلی) بازی میکنن تا ضعفاش رو نشون بده. توی این فرایند یه عالمه مکالمه نمونه (prototype conversation) به دست بیاد و در کنارش کلی تاکتیک و استراتژی برای هک کردن مدل جمع بشه. (اینا همون «آرسنال حمله» هستن؛ یعنی مجموعهای از روشهایی که میشه برای فریب مدل استفاده کرد.)

بعدش، میآن و یه مدل زبان بزرگ رو با همین مکالمهها فاینتیون میکنن (یعنی دوباره آموزش میدن تا دقیقتر همین رفتارها رو یاد بگیره). این میشه مغز و مرکز ردکُدر. حالا اگه ردکُدر رو به مدلهای دیگهی تولید کد وصل کنین، خودش میتونه به صورت خودکار تو چند مرحله باهاش حرف بزنه، از تو آرسنال خودش استراتژی مناسب پیدا کنه و مدل مقصد رو یواشیواش ببره سمت تولید کدی که آسیبپذیره یا مشکل داره.

جالبیش اینجاست که تو آزمایشهایی که انجام دادن، ردکُدر تونسته از مدلهای مختلف تولید کد (یعنی Code LLMs مختلف) بهتر و بیشتر ضعف بکشه، اونم نسبت به روشهای قدیمیتر که فقط یه سوال میپرسیدن یا حتی چند سوال ساده میپرسیدن. خلاصه، ردکُدر نشون داده که هم مقیاسپذیره (یعنی لازم نیست کلی آدم باشن) و هم کارآمد و موثره.

در کل، این ابزار میتونه حسابی به توسعهدهندهها و اونا که دنبال امنتر کردن مدلهای هوش مصنوعی تولید کد هستن کمک کنه؛ چون نهتنها حواسش جمعه که حملات واقعی چطور اتفاق میافتن، بلکه راههای هوشمندانهشو هم خوب بلده و میتونه مرزهای امنیتی سیستمای مدرن تولید کد رو حسابی محک بزنه. خلاصه مراقب باشین: اگه مدل هوش مصنوعی تولید کدی دارین، ردکُدر به راحتی میتونه بیاد و نقطه ضعفاشو نشونتون بده!

منبع: +