داستان امروز یه کم عجیب و در عین حال خیلی مهمه. بیا تصور کن تو شهر آمستردام تصمیم میگیرن که برای رسیدگی منصفانهتر به متقاضیهای خدمات اجتماعی (همون کمکهزینه یا وِلفِر)، از هوش مصنوعی و الگوریتم کمک بگیرن. یعنی یه جور سیستمی که خودش بررسی کنه، تشخیص بده چه کسی واقعاً لازم داره، چه کسی نه – اینجوری دیگه کلی وقت صرف نمیشه و قراره تبعیض و بیعدالتی هم کمتر بشه.

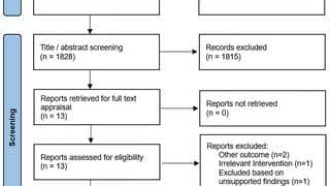

اما خب… نتیجه اونی نشد که فکر میکردن! با اینکه هدفشون انصاف بود، اما باز کلی مشکل و تبعیض تو کار پیدا شد. حالا چرا اینجوری شد؟ اصلاً میشه واقعاً یه سیستم منصف برای این کار ساخت یا نه؟ اینا سوالهایی بودن که توی یه میزگرد جالب از MIT Technology Review با حضور آماندا سیلورمن (ویراستار)، آیلیین گوو (خبرنگار تحقیقی) و گابریل گایگر (از Lighthouse Reports) کلی دربارهش بحث کردن.

اولین چیزی که باید بدونی اینه که وقتی میگیم “الگوریتم”، منظورمون یه فرمول یا سیستمه که مشخص میکنه با چه روشی دادهها بررسی بشن. مثلاً یه الگوریتم میتونه تصمیم بگیره فلانی حَق داره کمکهزینه بگیره یا نه. حالا وقتی پای هوش مصنوعی وسط میاد، یعنی این الگوریتمها خودشون یاد میگیرن و تصمیم میگیرن بدون دخالت مستقیم آدمها.

بحث اصلی این بود که حتی وقتی کلی آدم تلاش میکنن انصاف رو تو کار وارد کنن، باز این الگوریتمها، به خاطر دادههایی که بهشون داده شده یا حتی روش طراحیشون، میتونن ناخودآگاه مغرض و جانبدار بشن. “بایاس” یعنی همین جانبداری یا حالت تبعیضآمیز تو تصمیمگیری. فرض کن اگه سیستم تو دادههاش بیشتر از یه منطقه خاص یا یه گروه خاص آدم داره، احتمال داره سمت اونها جهتدار بشه.

تجربه آمستردام یه پروژه آزمایشی بزرگ بود. اونا میخواستن ببینن میشه یه مدل تشخیص تقلب درست کرد که هیچکسی رو ناعادلانه متهم نکنه؟ اما متاسفانه باز هم دیدن این مدلها ممکنه آدمایی رو که واقعا نیازمند کمکان به اشتباه وارد لیست مظنونین کنه یا حتی حقشون رو ضایع کنه. یعنی همون مشکلی که هیچکس دوست نداره دوباره اتفاق بیافته!

یه نکته جالبی که توی بحثهاشون مطرح شد این بود که این بایاسها گاهی توی سیستمها پنهان میمونن و کسی متوجه حضورشون نمیشه. یعنی اگر سیستم رو به حال خودش بذاریم، ممکنه آدمهایی که وضعیت مالی ضعیفی دارن، بیخود گرفتار بشن و اصلا راهی برای اعتراض هم نداشته باشن.

توی مقالههای مرتبط که توصیه شده، کلی راجع به خطرات واقعی هوش مصنوعی و الگوریتمای قضاوت و داوری صحبت شده بود. مثلاً یه اصطلاح “Machine Bias” بود که یعنی جانبداری الگوریتمها موقع تصمیمگیری ماشینها – مثلاً وقتی هوش مصنوعی تو دادگاه برای قضاوت زندانیها استفاده بشه و تصمیمهایی بگیره که خودمونم نمیتونیم دلیلش رو بفهمیم!

حالا راهحل چیه؟ چجوری میشه از این بایاسها جلوگیری کرد؟ یکی از راههایی که تو تحقیقات Lighthouse Reports گفته شد، اینه که سیستمهای هوش مصنوعی و الگوریتمی باید شفاف باشن و آدمها بتونن بفهمن دقیقا چطوری نتیجهگیری میکنن. “شفافیت” یعنی بشه فرآیند تصمیمگیری و دادههایی که منجر به اون تصمیم شده رو بررسی کرد. علاوه بر این لازمه یه جور کنترل و نظارت بیرونی هم روی این سیستمها باشه (Regulatory bodies یعنی همین نهادای نظارتی که مستقل هستن و هوای مردم رو دارن!).

در مجموع، استفاده از الگوریتم تو خدمات اجتماعی شاید هیجانانگیز باشه اما بدون کلی مراقبت و روش درست، هنوز نمیتونه تضمین کنه که همه چیز منصفانه پیش میره. خلاصه هنوز کلی کار داریم تا هوش مصنوعی واقعاً بیطرف و عادل بشه، مخصوصاً تو حوزههایی مثل کمکهزینه اجتماعی که با زندگی روزمره مردم سروکار داره.

اگه دوست داشتی بیشتر بدونی یا ته و توی ماجراها رو دربیاری، یه نگاه به منبعهایی که معرفی کردن بنداز: مقالههای تحقیقاتی MIT و Lighthouse Reports و کلی گزارش دیگه درباره چالشهای الگوریتمها و هوش مصنوعی تو خدمات اجتماعی.

منبع: +