خب بچهها، اگه توی دنیای هوش مصنوعی و این مدلهایی که کلی حرف میزنن و عکس میبینن رو دنبال میکنید، حتماً اسم LLMها (Large Language Models یعنی مدلهای زبانی بزرگ که میتونن متن رو درک و تولید کنن) و LVLMها (Large Vision-Language Models که همزمان هم متن رو میفهمن و هم تصویر) به گوشتون خورده. این مدلها خیلی باحالن و کارای عجیب و غریبی میتونن انجام بدن. اما یه مشکل اساسی دارن: وقتی دستورها پیچیده و چندمرحلهای میشن، حالا چه متنی باشن و چه ترکیبی از متن و تصویر، خیلی وقتا قاطی میکنن و نمیتونن درست جواب بدن!

اینجاست که یه راهحل خفن به اسم CIMR وارد میشه! اسمش رو بخوام ساده بگم، CIMR یعنی: “Contextualized Iterative Multimodal Reasoning”. ترجمه دمدستی: “استدلال چندمرحلهای و متن-تصویر همراه با بازبینی و اصلاح خودش توی هر مرحله، با توجه به بقیه اطلاعات”. یعنی چی؟ یعنی این مدل خودش رو جای ما آدمها میذاره و هر بار که میخواد به سوالی جواب بده، نه تنها سعی میکنه جواب بده، بلکه خودش جوابش رو چک میکنه و اگر اشتباه بود، دوباره براساس بازخوردها (همون Feedback) و اطلاعاتی که از متن و تصویر میگیره، اصلاحش میکنه!

اینطوری فرض کنید CIMR دو تا مرحله داره:

- اول یه دور فکر میکنه و جواب میده.

- بعد، خودش جوابش رو بررسی میکنه، از بازخوردهای متنی و تصویری استفاده میکنه (مثلاً میفهمه کجای عکس یا متن میتونه به حل مسأله کمک کنه)، و باز اگه لازم باشه جواب رو ویرایش میکنه. این فرآیند انقدر تکرار میشه که به جواب نهایی و درست برسه.

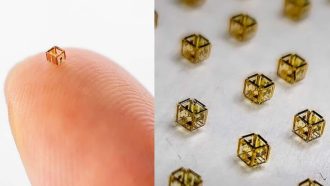

یکی از بخشهای توپ CIMR یه ماجرا به اسم “dynamic fusion module” داره. منظورش چیه؟ یعنی یه بخشی که اطلاعات تصویر، متن و حتی موقعیت فعلی سؤال رو همه رو با هم مخلوط میکنه و جوری با هم ترکیب میکنه که مدل بهترین تصمیم رو بگیره. این کار باعث میشه جواب خیلی دقیقتر و منطقیتر باشه.

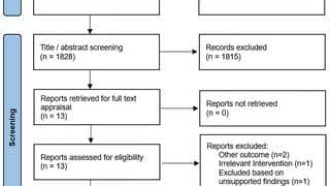

برای اینکه ببینن این مدل واقعاً کار میکنه یا نه، محققان CIMR رو با یک مدل قبلی معروف به اسم LLaVA-1.5-7B (که خودش خیلی قویه!) روی دیتاستی به اسم Visual Instruction Tuning (VIT) آموزش دادن و بعد کلی تست سخت ازش گرفتن. برای ارزیابی نهایی هم از یه دیتاست تازه به اسم Multi-modal Action Planning (MAP) استفاده کردن. دیتاست یعنی مجموعهای از سؤالها و جوابها و تصاویر که مدل باید روش امتحان پس بده!

نتیجه چی شد؟ مدل CIMR تونست به دقت ۹۱.۵٪ برسه! (این یعنی تقریباً همه سؤالها رو درست جواب داده) این عدد بسیار بالاست، مخصوصاً وقتی بدونید که مدل گنده و حرفهای مثل GPT-4V حتی عددش ۸۹.۲٪ شده، و مدلهای دیگه مثلاً LLaVA-1.5 حدود ۷۸.۵٪ و MiniGPT-4 نزدیک ۷۵.۳٪ و InstructBLIP هم ۷۲.۸ درصد بوده. یعنی این مدل جدید واقعاً تونسته توی کارهای ترکیبی و پیچیده (که هم متن دارن هم تصویر و نیاز به استدلال دارن)، از بقیه مدلها بهتر عمل کنه.

در کل، این داستان CIMR نشون میده که اگه مدلهای هوش مصنوعی بتونن موقع جواب دادن، چندبار خودشون رو چک کنن و بازخورد بگیرن و اطلاعات تصویر و متن رو به صورت پویا با هم ترکیب کنن، واقعاً میشه به برطرف کردن مشکلات سخت و چندمرحلهای امید داشت. یعنی هوش مصنوعی نه فقط حرفهایتر و دقیقتر میشه، بلکه میتونه کارهایی بکنه که تا همین چند ماه پیش براش غیرممکن بود!

پس خلاصه وار، اگه یه روزی یه مدل دیدید که هم میتونه عکس رو تفسیر کنه، هم متن رو بخونه، هم جواب درست رو بسازه، هم خودش رو تصحیح کنه و هم از بقیه قویتر باشه، احتمالاً با یه چیزی شبیه CIMR طرف هستید!

منبع: +