حتماً تاحالا دیدی که تو شبکههای اجتماعی کلی حرفای نفرتآمیز (یعنی حرفایی که باعث ناراحتی یا نفرت بین مردم میشن) یا اطلاعات غلط (همون چیزایی که درست نیستن ولی با اعتماد به نفس پخش میشن) منتشر میشن. همه اینا نهتنها باعث گسترش تعصب و تبعیض میشن، بلکه حتی بعضیا میگن ممکنه باعث بیشتر شدن خشونت و جرم تو جامعه، مخصوصاً تو آمریکا بشه.

حالا سوالی که مدتها ذهن روانشناسها رو مشغول کرده اینه که اصلاً چه ارتباطی بین این حجم از حرفای زشت یا اطلاعات غلطی که آدما تو دنیای مجازی میزنن، با وضعیت روحی و سلامت روان خودشون وجود داره؟ البته قبلاً یه کم تحقیق شده که آدمایی که چنین پستهایی میذارن، بعضی ویژگیهای شخصیتی خاص دارن، ولی دقیق نمیدونستیم که این حرفا و اطلاعات قلابی چقدر رو حال کلی و روان آدمها تأثیر میذاره یا از کجا میان.

یکی از مشکلات اساسی این بود که واقعاً دادهها خیلی زیاد و پیچیدهس. یعنی اصلاً راحت نیست که بیای هزاران پست و کامنت تو شبکههایی مثل Reddit رو همینجوری دستی بررسی کنی تا بفهمی پشت پردهشون چه خبره. Reddit خودش یه پلتفرم معروفه که میتونی توش درباره هر موضوعی با هر مدل آدمی بحث کنی. خلاصه برگامون ریخت وقتی فهمیدیم این حجم از دیتا رو باید تحلیل کنیم!

اما الان دیگه دنیای هوش مصنوعی و مدلهای زبانی بزرگ مثل ChatGPT (همین رباتهایی که میتونن مثل آدم ها حرف بزنن و از پس کلی کار بر بیان) اومدن وسط. این مدلها کلاً کل فضای آنلاین رو عوض کردن. مثلا تو همین تحقیق، دانشمندها اومدن و کلی پست از چندتای از این انجمنهای خاص Reddit رو جمع کردن و بعد به کمک مدل GPT-3 (یه مدل زبانی خیلی قوی از شرکت OpenAI که مغزش حسابی گندهس!) این پستها رو تبدیل به چیزی کردن که بهش میگن embedding. اگه embedding رو نمیشناسی: داستانش اینه که اینا یه جور عدد و رقمهایی هستن تو فضای چندبُعدی که معنای مخفی پستها رو ذخیره میکنن؛ یعنی مدل واقعاً سعی میکنه بفهمه متن چه حالی داره یا چه مفهومی رو منتقل میکنه.

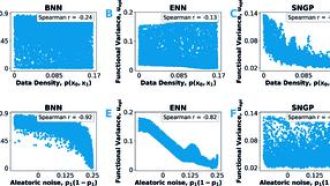

بعدش اومدن با کلی ترفند یادگیری ماشین (همین الگوریتمای هوشمندی که از تجربه یاد میگیرن چی به چیه!) این embeddingها رو بررسی کردن. هدف؟ بفهمن حرفای نفرتآمیز یا اطلاعات غلط چه الگوهایی دارن و چطوری با بقیه جامعه یا پستهای انجمنهای مختلف فرق دارن.

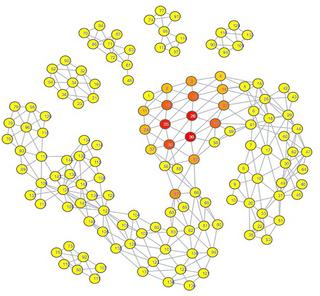

به اینجا که رسیدن، یه تکنیک توپتر استفاده کردن: تحلیل توپولوژیک دادهها (Topological Data Analysis یا همون TDA که یه جور روش تصویری برای پیدا کردن ارتباطای مخفی و ساختارهای پیچیده بین دادههاست). خلاصه با این روش تونستن یه نقشه تصویری ـ شبیه نقشه ذهنی ـ بکشن که نشون بده چطوری حرفای نفرتآمیز، اطلاعات غلط، اختلالات روانی مختلف و حتی وضعیت سلامت روان کلّی آدمای مختلف به هم ربط پیدا میکنن.

در کل این تحقیق یه نگاه نو داد به این که چطور رفتارای آنلاین میتونن یه جورایی آیینه وضع روانی ما باشن. یعنی فقط بحث این نیست که کی چی مینویسه؛ بلکه بحث اینه که پشت همین متنای آنلاین، میشه رد پای سلامت روان یا حتی اختلالات روانی رو پیدا کرد. تازه قدرت مدلهای جدید هوش مصنوعی رو هم نشون داد، چون واقعاً تحلیل این همه داده بدون اونا انگار نشدنی بود!

کلاً نتیجه اینه که با این روشای جدید و قدرتمند، میشه دنیای آنلاین رو بهتر بشناسیم، بفهمیم چه چیزایی به سلامت روانمون آسیب میزنن یا حتی چطور باید با موج اطلاعات غلط و حرفای نفرتانگیز مقابله کنیم. واقعاً تکنولوژی، وقتی باهوش میشه، میتونه کلی کمک کنه تا جامعهمون سالمتر و امنتر بشه.

منبع: +