تا حالا فکر کردی اگه بعد از عمل جراحی یه مشکلی پیش بیاد، کی باید جمعش کنه؟ معمولاً اینجور وقتا تیم پزشکی و مخصوصاً جراحها باید بیان وسط و با توجه به تجربهای که دارن، سریع دست به کار بشن. اما چند وقتیه یه موضوع جذاب سر زبونها افتاده: مدلهای زبانی بزرگ یا همون Large Language Models که بهشون LLM هم میگن (یعنی یه جور هوش مصنوعی که میتونه با خوندن دادههای زیاد، جواب سؤالها رو مثل آدم بده!)

یه تیم از محققای اهل آلمان و سوئیس (اسمهاشون هم خیلی خارجی بود، مثلاً Sophie-Caroline Schwarzkopf و دوستانش!) اومدن بررسی کنن ببینن این مدلهای زبانی بزرگ چقدر میتونن تو درمان عوارض بعد از جراحی کمک کنن یا مثل آدمهای واقعی عمل کنن یا نه.

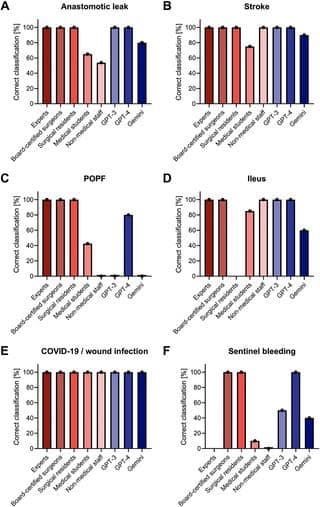

اونها سه تا از قویترین مدلهای هوش مصنوعی رو آوردن وسط؛ یعنی GPT-3، GPT-4 و یه مدل دیگه به اسم Gemini-Advanced (اینها همون مدلهایی هستن که مثلاً چتبات ChatGPT یا بقیه ابزارهای هوش مصنوعی ازش استفاده میکنن). بعد گرفتن شش تا پرونده واقعی از مریضهایی که بعد از عمل براشون مشکل پیش اومده بود. این کیسها رو به هوش مصنوعیها نشون دادن و همزمان به یه گروه پزشک حرفهای هم دادن و از هر دو طرف خواستن جواب بدن که:

۱. این مریض باید کجا بره؟ یعنی همون تریاژ (یه جور دستهبندی اورژانسی برای بیمارا که ببینن کدومشون باید زودتر رسیدگی بشه)

۲. بهنظر شما مریض چی شده؟ یعنی تشخیص اولیه

۳. برنامه مدیریت فوری چیه؟ یعنی چه آزمایش، تشخیص و درمانهایی باید سریع براش انجام بشه.

جوابها رو جمع زدن و با همدیگه مقایسه کردن تا ببینن کی کارش بهتره! حالا نتایج خیلی جالب شدن:

برای پیدا کردن نوع عارضه بعد از عمل، GPT-4 حتی از خیلی پزشکا بهتر بود! یعنی جراحا تونستن ۷۶/۳ درصد مواقع درست تشخیص بدن، GPT-3 حدود ۷۵ درصد و GPT-4 ترکوند با ۹۶/۷ درصد! (اینجا اون درصدها یعنی در چند درصد کیسها، درست عارضه رو تشخیص دادن). این اختلاف آنقدر عجیب نبود که از نظر آماری هم معنادار بشه، ولی نشون میده GPT-4 واقعاً قدرت بالایی داره.

ولی وقتی بحث تریاژ بود، یعنی بگیم کدوم مریض خطرناکه کدوم نیست، جراحا هنوز پرچمدار هستن: ۸۴/۸ درصدشون درست تریاژ کردن. جالب اینجاست که GPT-3 فقط تو ۵۰ درصد موارد درست عمل کرد و GPT-4 حتی پایینتر، یعنی ۳۸/۳ درصد! پس فعلاً واسه تریاژ هنوز نمیتونیم خیلی به هوش مصنوعی اعتماد کنیم.

یک جای دیگهای که هوش مصنوعیها خوب عمل کردن، بخش پیشنهاد درمان و کارهای تشخیصی بود. یعنی هر دو مدل GPT-3 و GPT-4 تونستن واسه درمان عوارض بعد از جراحی، برنامههای تقریبا کاملی ارائه بدن. ولی جالب بدونی Gemini-Advanced گاهی یا اصلاً پیشنهاد درمانی نمیداد یا اینکه جوابهاش رو سانسور میکرد! (سانسور کردن یعنی مثلاً نمیخواست مسئولیت توصیه پزشکی رو قبول کنه و هیچ جوابی نمیداد).

در مجموع چی میشه گفت؟ بهطور کلی هوش مصنوعیها مخصوصاً این مدلهای زبانی جدید، میتونن تو مدیریت عوارض بعد از جراحی درست و حسابی کمک کنن و جوابهای کاملی بدن. مخصوصاً GPT-4 که واقعاً دقیق کار کرد. این نشون میده که هرچی این مدلها پیشرفت کنن، شاید بتونن واقعاً کنار تیم درمان باشن و بهشون قدرت بیشتری بدن. ولی فعلاً به عنوان یه پزشک ماشینوار که همهچی رو بدونه و جای پزشک واقعی تصمیم بگیره، هنوز زوده!

خلاصه مقاله این بود. اگه یه روز بعد از عمل حس کردی رباتها دارن نظر میدن، بدون که شاید بخوان فقط کمک کنن و هنوز جای تجربه و قضاوت تیم پزشکی رو نگرفتن… حداقل فعلاً! 😉

منبع: +