حتماً تو این مدت زیاد اسم مدلهای Transformer رو شنیدی – مثلاً همین ChatGPT که الان داری باهاش حرف میزنی هم با این ساختار کار میکنه. این مدلها وقتی روی کلی اطلاعات مختلف آموزش داده میشن و بعد برای موضوع خاص مثل پزشکی یا تحلیل اطلاعات بیمارستان (یه جورایی سوابق پزشکی بیمارا که بهش میگن Electronic Health Records یا همون EHR)، دوباره آموزش میگیرن، حسابی باهوش و دقیق میشن. ولی یه مشکل هست: دادههایی که تو پزشکی برچسبدار هستن (یعنی دقیقاً مشخصه این دادهها به چه بیماری، دارو یا اتفاقی مربوطه)، واقعاً کمه؛ تازه رویدادهای پزشکی هم خیلی پیچیده و پراکندن، یعنی هر دادهای ممکنه هر چند وقت یکبار ثبت بشه یا کلی اتفاق بینش بیفته.

حالا معمولاً این مدلها با یه سازوکار به اسم Self-attention یعنی «توجه به خود» کار میکنن، که خلاصهش اینه که مدل یاد میگیره کدوم بخشهای داده برای پیشبینی مهمترن. مثلاً تو یه دنباله زمانی از آزمایشهای یک بیمار، مدل باید تشخیص بده که آزمایش قند مثلاً با داروی خاص ربط داره یا نه. ولی وقتی دادهها کم باشه، یا این ارتباطها خیلی ظریف و پراکنده باشن، همین self-attention هم ممکنه کارایی بالایی نداشته باشه و خیلی چیزا رو از دست بده.

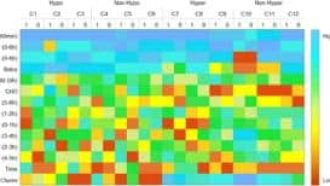

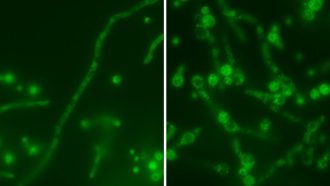

اینجا یه راهکار خلاقانه به اسم Adaptive Noise-Augmented Attention یا به اختصار ANAA معرفی شده. بخوام ساده بگم، این روش میاد یه مقدار نویز یا به هم ریختگی «هوشمند» به وزنهای بخش توجه (attention weights) اضافه میکنه و بعدش با یه «هسته گاوسی دو بعدی» (2D Gaussian kernel، یعنی یه جور فیلتر آماری که کمک میکنه توجهها پخشتر و هموارتر باشن) روی نقشه توجه کار میکنه. نتیجه چی میشه؟ اینطوری توجه مدل دیگه فقط رو چند رویداد محدود گیر نمیکنه و شانس بیشتری داره که رو رویدادهایی که شاید در حالت عادی به چشم مدل نمیاومدن هم حساس بشه و اطلاعات بیشتری از کل دنباله بگیره.

برخلاف روشهایی که مجبور بودن کل مدل رو از اول بازطراحی کنن و دوباره آموزش بدن (که واقعاً وقتگیر و گرون در میاد)، این ANAA فقط موقع دقیقتر کردن مدل (یه مرحله به اسم Fine-tuning که یعنی مدل رو برای یه وظیفه خاص مثل پیشبینی بیماری خاص تنظیم میکنن) اضافه میشه. یعنی لازم نیست کل مدل رو از نو ساخت یا کلی منابع خرج کرد.

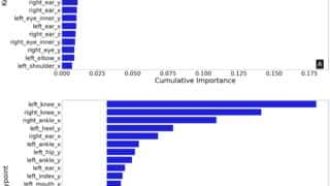

تیم پژوهشی نشون دادن که استفاده از ANAA تو چندین وظیفه پزشکی مختلف، باعث شده مدلها با همین دادههای کم کارایی بهتری نشون بدن. نکته باحال دیگه اینه که بررسی کردن نویز و صافکردن توجه باعث شده مدل بتونه ارتباطهای زمانی (Temporal dependencies یعنی اینکه یک رویداد پزشکی چطور به وقایع آینده و گذشته بیمار ربط داره) رو بهتر یاد بگیره و حتی بشه رفتار مدل رو تفسیر کرد که واقعاً به چی داره توجه میکنه.

در کل، راهکار ANAA خودش رو به عنوان یه روش ساده اما کاربردی نشون داده واسه وقتایی که مدل Transformer داریم اما نه داده زیاد داریم، نه وقت بازطراحی کلی. یه کوچولو نویز بهجا، یه کم پخشکردن توجه با فیلتر گاوسی، و نتیجهاش مدلهای باهوشتر که چیزهای ظریف رو هم میبینن! همین ایده ساده ممکنه باعث پیشرفت حسابی تو کاربردهای پزشکی و سیستمهای سلامتی دیجیتال بشه.

منبع: +