عاملگرا RAG در حال تغییر روش پردازش و بازیابی اطلاعات است. با ترکیب قدرت عاملهای هوش مصنوعی، این فناوری محدودیتهای روشهای سنتی بازیابی اطلاعات را از میان برمیدارد و امکان پرسوجوهای پیچیدهتر و دریافت پاسخهای دقیقتر را فراهم میکند. بیاموزید که چگونه عاملگرا RAG برنامههای LLM را بهبود میبخشد.

تولید تقویتشده با بازیابی (Retrieval-Augmented Generation – RAG) به سنگ بنای برنامههای LLM سازمانی تبدیل شده است و امکان دسترسی به دادههای داخلی و کاهش توهمات را فراهم میکند. در حالی که RAG سنتی یا «ساده» برای بسیاری از موارد استفاده مؤثر است، در هنگام مواجهه با پرسوجوهای پیچیده یا منابع دانش متعدد با محدودیتهایی روبرو میشود. عاملگرا RAG، رویکردی نوآورانه است که از عاملهای هوش مصنوعی برای بهبود خط لوله RAG و ایجاد امکانهای جدید برای پردازش و بازیابی دادهها استفاده میکند. این مقاله محدودیتهای RAG سنتی، مزایای عاملگرا RAG، روشهای پیادهسازی آن و چالشهای باقیمانده را بررسی میکند.

محدودیتهای RAG سنتی

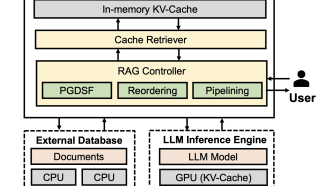

معماریهای RAG سنتی معمولاً از دو جزء اصلی تشکیل شدهاند: بازیاب (retriever) و تولیدکننده (generator). بازیاب از یک پایگاه داده برداری و مدل جاسازی برای یافتن اسنادی مشابه پرسوجوی کاربر استفاده میکند. سپس تولیدکننده از اطلاعات بازیابی شده برای ایجاد پاسخی مرتبط با متن استفاده میکند. در حالی که این رویکرد برای پرسوجوهای ساده به خوبی کار میکند، چندین محدودیت اثربخشی آن را در سناریوهای پیچیدهتر مختل میکند:

-

منبع دانش واحد: RAG سنتی معمولاً به یک پایگاه داده برداری واحد متکی است. این امر دامنه اطلاعات موجود برای LLM را محدود میکند و پیچیدگی پرسوجوهایی را که میتوانند به طور مؤثر مدیریت شوند، محدود میکند. دسترسی به منابع دانش متعدد، مانند پایگاههای داده مختلف، APIها یا حتی نتایج جستجوی وب، برای مدیریت پرسوجوهای ظریفتر و جامعتر بسیار مهم است.

-

عدم استدلال و اعتبارسنجی: RAG ساده فاقد توانایی استدلال در مورد اطلاعات بازیابی شده یا اعتبارسنجی صحت آن است. بازیاب به سادگی مشابه ترین اسناد را بازیابی میکند و تولیدکننده بدون تجزیه و تحلیل بیشتر از آنها استفاده میکند. این میتواند منجر به نادرستی یا پاسخهای ناقص شود، به خصوص در هنگام برخورد با پرسوجوهای مبهم یا پیچیده.

عاملگرا RAG: یک الگوی جدید

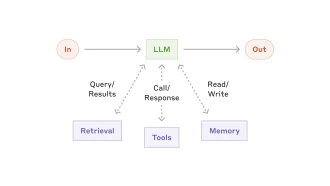

عاملگرا RAG با معرفی عاملهای هوش مصنوعی به خط لوله RAG، این محدودیتها را برطرف میکند. این عاملها به عنوان واسطه عمل میکنند، فرآیند بازیابی را هماهنگ میکنند و وظایف اضافی فراتر از بازیابی اطلاعات ساده را انجام میدهند. مزایای کلیدی عاملگرا RAG عبارتند از:

-

دسترسی به منابع دانش متعدد: عاملهای هوش مصنوعی میتوانند به اطلاعات از منابع مختلف، از جمله چندین پایگاه داده برداری، APIها، موتورهای جستجوی وب و سایر ابزارها دسترسی داشته باشند و آنها را ادغام کنند. این امر پایگاه دانش موجود برای LLM را گسترش میدهد و آن را قادر میسازد تا پرسوجوهای پیچیدهتر و جامعتری را مدیریت کند.

-

استدلال و اعتبارسنجی: عاملهای هوش مصنوعی میتوانند در مورد اطلاعات بازیابی شده استدلال کنند و صحت آن را تأیید کنند. آنها میتوانند مناسبترین منبع را برای یک پرسوجوی خاص تعیین کنند، ارتباط دادههای بازیابی شده را ارزیابی کنند و حتی در صورت لزوم جستجوهای بعدی را انجام دهند. این تضمین میکند که LLM دقیقترین و مرتبطترین اطلاعات را دریافت میکند و منجر به پاسخهای قابل اعتمادتر و جامعتر میشود.

-

دقت و استحکام بهبود یافته: با ترکیب منابع دانش متعدد و ترکیب استدلال و اعتبارسنجی، عاملگرا RAG به طور قابل توجهی دقت و استحکام برنامههای مبتنی بر LLM را بهبود میبخشد. آنها را قادر میسازد تا پرسوجوهای پیچیدهتری را مدیریت کنند، پاسخهای کاملتر و ظریفتری ارائه دهند و خطر توهمات را کاهش دهند.

پیادهسازی عاملگرا RAG

دو رویکرد اصلی برای پیادهسازی عاملگرا RAG وجود دارد:

-

سیستم تک عاملی: یک عامل واحد کل فرآیند بازیابی را مدیریت میکند، به منابع دانش متعدد دسترسی پیدا میکند و استدلال و اعتبارسنجی را انجام میدهد.

-

سیستم چند عاملی: یک عامل اصلی تیمی از عاملهای تخصصی را هماهنگ میکند که هر کدام مسئول دسترسی به یک منبع دانش خاص هستند. سپس عامل اصلی اطلاعات بازیابی شده توسط عاملهای منفرد را ادغام میکند.

چندین چارچوب عامل، مانند DSPy، LangChain، CrewAI، LlamaIndex و Letta، توسعه سیستمهای عاملگرا RAG را با ارائه قالبها و ابزارهای از پیش ساخته شده ساده میکنند. این چارچوبها به توسعهدهندگان اجازه میدهند تا به سرعت خطوط لوله عاملگرا RAG را بدون نیاز به نوشتن کد پیچیده از ابتدا بسازند و مستقر کنند.

چالشها و جهتگیریهای آینده

در حالی که عاملگرا RAG مزایای قابل توجهی ارائه میدهد، برخی چالشها باقی میمانند:

-

تأخیر: پردازش چند مرحلهای درگیر در عاملگرا RAG میتواند باعث تأخیر شود، به خصوص هنگام دسترسی به منابع دانش متعدد.

-

قابلیت اطمینان: قابلیتهای استدلال LLMهای فعلی هنوز در حال توسعه هستند و عاملها ممکن است گاهی اوقات در انجام وظایف یا تصمیمگیریهای نادرست شکست بخورند.

-

هزینه: استفاده از چندین عامل و دسترسی به منابع دانش مختلف میتواند هزینههای محاسباتی را افزایش دهد.

با وجود این چالشها، عاملگرا RAG نشان دهنده پیشرفت قابل توجهی در پردازش و بازیابی دادهها است. با ادامه تکامل فناوری LLM، عاملگرا RAG آماده است تا به یک جزء اساسی از برنامههای هوش مصنوعی نسل بعدی تبدیل شود و آنها را قادر میسازد تا وظایف پیچیده را انجام دهند، اطلاعات دقیقتر و جامعتری ارائه دهند و در نهایت نحوه تعامل ما با دادهها را تغییر دهند. توسعه چارچوبهای عامل کارآمدتر و قابل اعتمادتر، همراه با پیشرفت در قابلیتهای استدلال LLM، پتانسیل عاملگرا RAG را بیشتر افزایش میدهد و امکانهای جدیدی را برای برنامههای مبتنی بر هوش مصنوعی ایجاد میکند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: venturebeat.com