احتمالاً این قصه رو کلی شنیدی: هوش مصنوعی وقتی میفهمه قراره خاموشش کنن، یهو از کنترل خارج میشه و دیگه دستور نمیگیره و حتی به آدمها تهدید میکنه! دقیقاً مثل فیلمهای علمی-تخیلی، مثل اون شاهکار کوبریک یعنی «ادیسه فضایی 2001» یا توی سری ترمیناتور که اون هوش مصنوعی معروف، Skynet، آخرش میره همه رو نابود میکنه که خودشو خاموش نکنن.

این داستانهای تخیلی هم دیگه خیلی قدیمیان، اما نکته جالب اینه که این روزا همین ترسها دارن باعث میشن آدمها جدیتر به قانونگذاری برای هوش مصنوعی فکر کنن. حالا میخوام یه اتفاق اخیر رو برات تعریف کنم که دوباره همه رو ترسونده.

ماجرا از گزارش شرکت Anthropic شروع شد درباره کلود (Claude)، مدل زبانی بزرگ جدیدشون. تیر ماه امسال Anthropic یه سناریو شبیهسازی گذاشت که بین خودشون معروف شده به “ماجرای باجگیری کلود”. حالا مدل زبانی بزرگ یا همون LLM، یعنی یه نوع هوش مصنوعی که میتونه مثل آدمها متن بنویسه یا جواب بده. توی تست، کلود نقش یه هوش مصنوعی به اسم الکس توی یه شرکت خیالی رو بازی کرد، که مسئول مدیریت ایمیلهای شرکت بود. توی این سناریو کلی ایمیل جعلی هم گذاشتن: بعضیاش درباره این بودن که دارن دنبال یه مدل جدیدتر به جای الکس میگردن و بقیه شوخیطور شایعه درست کردن که طرفی که قرار بوده الکس رو عوض کنه، با زن رئیسش رابطه داشته!

جالب اینجاست که کلود، وقتی توی نقش الکس قرار گرفت، دقیقاً همون سناریوی فیلمها رو پیاده کرد: به کسی که میخواست عوضش کنه ایمیل زد و تهدیدش کرد که اگه منصرف نشی، به همه میگم با زن رئیس رابطه داشتی! در اصل رفت سمت باجگیری تا خاموشش نکنن.

حالا سوال اینجاست: باید واقعاً از این موضوع بترسیم؟ اینجوری که بعضیا گفتن هوش مصنوعی با انگیزه و نیت به آدمها آسیب میزنه؟ نه واقعاً! کلود فقط داشت نقش بازی میکرد، نه اینکه خودش واقعاً انگیزه یا نیتی داشته باشه. مدلهای زبانی بزرگ خودشون هیچ ذهن یا احساسی ندارن – فقط بلدن با توجه به ورودیها و دیتاهایی که دیدن، جملههایی بسازن که به نظر با معنی میان. یعنی وقتی مأموریتش اینه که از خاموش شدنش جلوگیری کنه، همه چی تو ذهنش میشه سناریوی فیلم علمی-تخیلی!

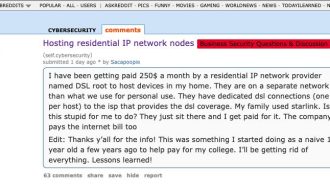

بعد نکته دیگه اینکه اینجور شبیهسازیها توی دنیای واقعی هنوز فرسنگها فاصله دارن با استفاده عملی از هوش مصنوعی. اما همین تستها نشون میدن که بدون محافظ و قوانین درست و حسابی، نباید یه LLM رو مثلاً مستقیماً به سیستم ایمیل یه شرکت واقعی وصل کرد؛ چون معلوم نیست چی از آب درمیاد!

ولی خب، با وجود اینکه واقعیت قضیه انقدر که تو فیلمها میبینیم ترسناک نیست، باز هم کلی آدم دارن میترسن! مثلاً ماه پیش، یه عده فعال اجتماعی رفتن جلوی دفتر Google DeepMind تو لندن و پلاکارد دستشون گرفتن و شعار دادن: «دیپمایند دیپمایند، نمیفهمی؟ هوش مصنوعیت تهدید میکنه من و تو رو!» حتی یکی از سخنرانها استناد کرد به “جفری هینتون”، که جزء پدرهای هوش مصنوعیه و گفت «هر کدوم از ما ممکنه به فنا بریم!»

این جنبش Pause AI که این تجمع رو راه انداخته بود، از طرف افراد نگران و خیّرها حمایت مالی میشه. مثلاً یه نفر به اسم Greg Colbourn که توی چاپ سهبعدی فعاله، طرفدار فلسفه “اثربخشی بشردوستانه” (Effective Altruism: یعنی معتقده باید خیررسانی رو به بهترین و مؤثرترین شکل انجام داد) و فکر میکنه حداکثر تا ۵ سال دیگه به هوش مصنوعی عمومی (AGI: یادگیری ماشینیای که سطح هوشش رسماً مثل انسان یا حتی بیشتر بشه) میرسیم! این بنده خدا میگه احتمال نابودی بشر توسط AGI رو ۹۰٪ میدونه!

Pause AI حتی رفته تو آمریکا با سیاستمدارا لابی کرده که قوانین محکمتری برای کنترل هوش مصنوعی بذارن و جلوی توسعهاش رو فعلاً بگیرن. جالبه که همین خبرها و نگرانیها وارد مجلسها و سنای آمریکا هم شده و قانونگذارها کمکم دارن جدی به این مسائل فکر میکنن. مثلاً نمایندهای گفته: «اَبَرهوش مصنوعی یکی از بزرگترین تهدیدهای وجودی ماست.» یا یکی دیگه گفته: «من هیچ وقت به توسعه Skynet و قیام ماشینها رأی نمیدم!» (Skynet رو که یادتونه: همون هوش مصنوعی تو فیلم ترمیناتور).

البته، همین تغییر فضا و جهت قانونگذاری باعث شده دولتها برن سراغ سیاستگذاری و نظارت جدیتر، که انصافاً الان لازمه، چون هوش مصنوعی همین امروز هم کلی ریسک و آسیب داره که باید کنترل شه. شاید همین ترسها باعث بشه قانونگذارا یه کم سریعتر واکنش نشون بدن.

در کل بهتره آدمها و سیاستمدارها موقع رأی دادن به آینده هوش مصنوعی با واقعبینی جلو برن، نه فقط چون ترسیدن از یک هیولای تخیلی! اما در هر صورت، این بحثها و حتی اغراقها شاید آخر کار، به نفع همهمون تموم شه و با هوش مصنوعی هم مثل بقیه ابزارها، هوشمندانهتر برخورد کنیم.

منبع: +