پژوهشگران هوش مصنوعی به مرز دادههای موجود آنلاین برای آموزش مدلهای زبانی بزرگ مانند ChatGPT نزدیک شدهاند. این کمبود داده، توسعه هوش مصنوعی را با چالشهایی روبهرو میکند و احتمالاً آن را به سمت استفاده از مدلهای کوچکتر و تخصصیتر، تولید داده مصنوعی و بهرهگیری از مجموعه دادههای جایگزین هدایت میکند.

آیا عطش هوش مصنوعی برای دادهها به پایان خود نزدیک میشود؟

هوش مصنوعی (Artificial intelligence : AI) در دهه گذشته پیشرفت چشمگیری داشته است. این پیشرفت عمدتاً به دلیل گسترش شبکههای عصبی و آموزش آنها با مجموعه دادههای بسیار بزرگ است. مدلهای زبانی بزرگ (Large Language Models : LLMs)، مانند مدلهای ChatGPT، نهتنها میتوانند زبان محاورهای را تقلید کنند، بلکه قابلیتهای جدیدی مانند استدلال را نیز نشان میدهند. اما پژوهشگران هشدار میدهند که این پیشرفت سریع ممکن است به زودی با مانعی روبرو شود: کمبود دادههای آموزشی.

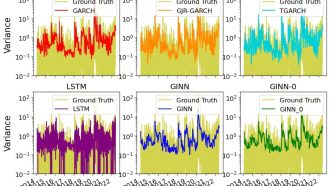

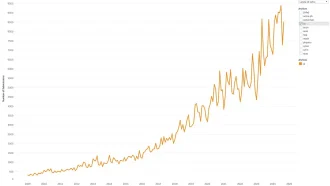

یک مطالعه توسط Epoch AI پیشبینی میکند که تا سال ۲۰۲۸، حجم مجموعه دادههای آموزشی با کل متن موجود در اینترنت برابری خواهد کرد. یعنی اینترنت، که منبعی بهظاهر نامحدود از دانش بشری است، ممکن است برای آموزش هوش مصنوعی خالی شود. این مشکل با افزایش قوانین مربوط به نحوه استفاده از دادهها و مقاومت تولیدکنندگان محتوا و ناشران در برابر کپیبرداری غیرمجاز از مطالبشان، جدیتر میشود.

بحران داده و پیامدهای آن

LLMها به مقدار شگفتانگیزی داده نیاز دارند. در سالهای اخیر، تعداد توکنها (واحدهای کلمه) برای آموزش این مدلها از صدها میلیارد به دهها تریلیون افزایش یافته است. اما رشد دادههای متنی باکیفیت و قابل استفاده در اینترنت کند است – کمتر از ۱۰٪ در سال. با دو برابر شدن حجم دادههای آموزشی هوش مصنوعی در هر سال، پیشبینی میشود که این دو در عرض چند سال به هم برسند.

چالش دیگر، مقاومت روزافزون ارائهدهندگان محتوا است. بسیاری از وبسایتها از روشهای فنی برای جلوگیری از جمعآوری دادهها توسط خزندههای وب استفاده میکنند. برای مثال، مطالعهای توسط Data Provenance Initiative نشان داد که وبسایتهای باکیفیت بهطور فزایندهای دسترسی شرکتهای هوش مصنوعی را به محتوای خود محدود میکنند. دعواهای حقوقی، مانند شکایت نیویورک تایمز و سایر ناشران از OpenAI، تنش بین توسعهدهندگان هوش مصنوعی و تولیدکنندگان محتوا بر سر حق چاپ و استفاده منصفانه را بیشتر نشان میدهد.

کاوش راهحلهای خلاقانه

با وجود این چالشها، توسعهدهندگان هوش مصنوعی ناامید نیستند. شرکتهایی مانند OpenAI و Anthropic در حال بررسی راهکارهای مختلفی برای مقابله با بحران دادهها هستند:

- تولید داده مصنوعی (Synthetic Data Generation): مدلها میتوانند دادههای مصنوعی ایجاد کنند تا کمبود دادههای واقعی را جبران کنند. برای مثال، OpenAI روزانه صدها میلیارد کلمه از طریق تولید داده مصنوعی تولید میکند.

- منابع داده غیرمتعارف (Unconventional Data Sources): دادههای اختصاصی، مانند اطلاعات داخلی شرکتها یا تعاملات ناشناس کاربران، راه دیگری است. اما این منابع محدود هستند و اغلب با نگرانیهایی در مورد حریم خصوصی یا اخلاق همراه هستند.

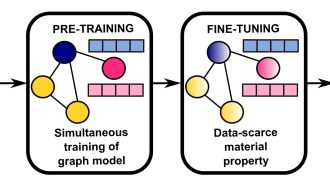

- مجموعه دادههای تخصصی (Specialized Datasets): زمینههایی مانند ژنومیک، پزشکی یا نجوم ممکن است فرصتهای استفاده از دادههای دستنخورده را فراهم کنند. اما کاربرد آنها برای آموزش LLMها هنوز مشخص نیست.

فراتر از مدلهای بزرگتر

بهجای رویکرد “هرچه بزرگتر، بهتر”، میتوان مدلهای هوش مصنوعی کوچکتر و کارآمدتری متناسب با وظایف خاص توسعه داد. این مدلها به داده و قدرت محاسباتی کمتری نیاز دارند، اما اغلب با آموزش دقیق، نتایج بههمان اندازه خوبی ارائه میدهند.

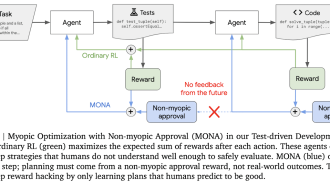

پیشرفتهای اخیر در الگوریتمها و سختافزارها به پژوهشگران این امکان را داده است تا با منابع کمتر، کارهای بیشتری انجام دهند. برای مثال، آموزش مجدد مدلها با مجموعه دادههای موجود بهاندازه آموزش با دادههای کاملاً جدید مؤثر بوده است. نوآوریهایی مانند یادگیری تقویتی – که در آن مدلها برای بهبود پاسخهای خود بازخورد دریافت میکنند – نیز در حال افزایش است.

گسترش تعریف دادهها

برخی از کارشناسان معتقدند که تعریف فعلی “داده” بسیار محدود است. سیستمهای هوش مصنوعی میتوانند فراتر از متن رفته و دادههای بصری، شنیداری یا حسی را نیز در بر گیرند. برای مثال:

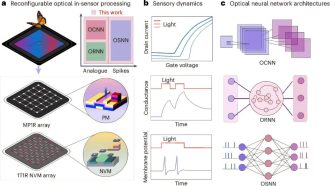

- آموزش چندوجهی (Multimodal Training): برخی از مدلهای هوش مصنوعی مولد در حال حاضر متن، تصاویر و ویدیوها را برای آموزش با هم ترکیب میکنند.

- یادگیری مبتنی بر هوش مصنوعی (AI-Driven Learning): سیستمهای رباتیک مجهز به حسگرها میتوانند بهجای تکیه بر مجموعه دادههای از پیش آماده شده، از تجربیات دنیای واقعی یاد بگیرند.

خطرات و نگرانیهای اخلاقی

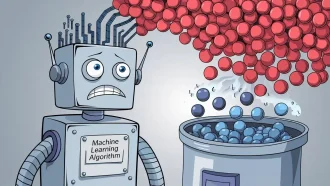

در حالی که دادههای مصنوعی و اختصاصی راهحلهای بالقوهای ارائه میدهند، خطراتی نیز دارند. حلقههای بازگشتی در تولید داده مصنوعی میتواند با تقویت خطاها یا سوگیریها، کیفیت مدل را کاهش دهد. پژوهشگران اصطلاحاتی مانند “اختلال خودخوری مدل (Model Autophagy Disorder)” را برای توصیف اینکه چگونه مدلهای هوش مصنوعی ممکن است با تکیه بیش از حد بر دادههای خودساخته ” دچار اختلال شوند” ابداع کردهاند.

ملاحظات اخلاقی نیز بسیار مهم هستند. استفاده از محتوای خصوصی یا اختصاصی بدون اجازه، سؤالاتی در مورد حریم خصوصی و مالکیت معنوی ایجاد میکند. ایجاد تعادل بین نوآوری و مسئولیت اخلاقی برای توسعهدهندگان در این فضای در حال تغییر بسیار مهم خواهد بود.

تغییر در آینده هوش مصنوعی؟

کمبود قریبالوقوع دادهها میتواند چشمانداز هوش مصنوعی را بهکلی تغییر دهد. بهجای مدلهای بزرگ و همهمنظوره، آینده ممکن است شاهد مدلهای کوچکتر و تخصصیتر طراحی شده برای کاربردهای خاص باشد. این مدلها میتوانند از تکنیکهای آموزشی کارآمدتر استفاده کنند، به انواع دادههای متنوع تکیه کنند و قابلیتهای یادگیری خودراهبر را در خود داشته باشند.

در نهایت، ترکیب دادههای مصنوعی، روشهای آموزشی نوآورانه و منابع داده جدید میتواند با وجود چالشها، رشد هوش مصنوعی را ادامه دهد. همچنان که مدلها بهطور مستقلتر “فکر” میکنند و با جهان به روشهای پیچیدهتری تعامل دارند، مرزهای توسعه هوش مصنوعی گسترش خواهد یافت.

این سؤال باقی میماند: آیا عطش هوش مصنوعی برای دادهها سیریناپذیر است یا میتواند یاد بگیرد که با منابع کمتر رشد کند؟ پاسخ به این بستگی دارد که پژوهشگران و توسعهدهندگان چگونه با این نقطه عطف حیاتی در تاریخ هوش مصنوعی سازگار میشوند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: nature.com