کدهای تولیدشده توسط هوش مصنوعی نگرانیهای پیچیدهای را برای توسعهدهندگان و سازمانها به همراه دارد. از چالشهای مالکیت معنوی گرفته تا پیامدهای فاجعهبار، این مسئولیتها اهمیت زیادی پیدا کردهاند. در این میان، ابهامات قانونی پیرامون ابزارهایی مانند ChatGPT نشاندهنده نیاز به بررسی دقیقتر این مسائل است و میتواند تأثیرات عمیقی بر آینده فناوری داشته باشد.

پیچیدگیهای مسئولیت در کد تولید شده توسط هوش مصنوعی

هوش مصنوعی (AI) به یکی از ارکان توسعه نرمافزار مدرن تبدیل شده است. همین امر، بحث مسئولیت در قبال کد تولید شده توسط هوش مصنوعی را به موضوعی مهم تبدیل کرده است. توسعهدهندگان و کسبوکارها باید با خطرات احتمالی، از جمله اختلافات مالکیت معنوی و شکستهای فاجعهبار، مقابله کنند. درک این چالشهای حقوقی و فنی برای هر کسی که از ابزارهای هوش مصنوعی مانند ChatGPT یا Copilot استفاده میکند، ضروری است.

درک مسئولیت عملکردی

ریچارد سانتالسا، وکیلی متخصص در حوزه فناوری و عضو انجمن مطبوعات اینترنتی، چشمانداز حقوقی فعلی را کاملاً مبهم توصیف میکند. به گفتهی سانتالسا، کد تولید شده توسط هوش مصنوعی، در حال حاضر پیامدهای قانونی مشابه کد نوشته شده توسط انسان دارد. باید توجه داشت که هیچ کدی، چه توسط انسان نوشته شده باشد و چه توسط هوش مصنوعی تولید شده باشد، بدون خطا نیست. توسعه نرمافزار مدتهاست که به کتابخانهها و SDKهای خارجی متکی بوده است، اغلب بدون بررسی کامل. کد تولید شده توسط هوش مصنوعی، حداقل در حال حاضر، در همین دسته قرار میگیرد.

این دیدگاه نکتهی مهمی را برجسته میکند: مسئولیت اغلب بر عهدهی کسانی است که این کد را به کار میگیرند و ادغام میکنند. توافقنامههای سطح خدمات به ندرت بیعیبی و نقصی را تضمین میکنند و هوش مصنوعی این واقعیت را تغییر نمیدهد. توسعهدهندگان باید هوشیار باشند، به خصوص با افزایش استفاده از ابزارهای هوش مصنوعی در فرآیندهای توسعه.

تهدید ترولهای قانونی

شان اوبراین، مدرس امنیت سایبری در دانشکده حقوق ییل و بنیانگذار آزمایشگاه حریم خصوصی ییل، به مسئلهی نگرانکنندهای اشاره میکند: احتمال تولید کد اختصاصی یا دارای حق چاپ توسط ابزارهای هوش مصنوعی. با توجه به آموزش پلتفرمهایی مانند ChatGPT و Copilot بر روی مجموعه دادههای عظیم – شامل منابع متنباز و اختصاصی – توسعهدهندگان ممکن است ناخواسته چنین کدی را در پروژههای خود وارد کنند. این موضوع زمینه را برای نوع جدیدی از سوءاستفادههای قانونی فراهم میکند.

اوبراین پیشبینی میکند صنعتی مشابه سوءاستفاده از ثبت اختراع، شکل بگیرد. در این صنعت، شرکتها از توسعهدهندگان به دلیل استفاده از کد تولید شده توسط هوش مصنوعی که ادعا میشود مجوزهای اختصاصی را نقض میکند، شکایت خواهند کرد. با افزایش اتکای توسعهدهندگان به ابزارهای هوش مصنوعی، اکوسیستمهای نرمافزاری ممکن است با عناصر اختصاصی آلوده شوند و منجر به ادعاهای توقف و انصراف شوند. پیامدهای این موضوع برای کسبوکارها و کدنویسان بسیار سنگین است، زیرا حتی استفادهی ناخواسته از چنین کدی میتواند منجر به دعاوی پرهزینه شود.

دستکاری و خرابکاری دادههای آموزشی هوش مصنوعی

یکی دیگر از نگرانیها، احتمال خرابکاری در دادههای آموزشی هوش مصنوعی است. هکرها، دولتهای متخاصم و حتی افراد با نیت بد میتوانند دادههای نادرست یا مغرضانه را به سیستمهای هوش مصنوعی تزریق کنند. این امر میتواند اعتبار خروجیهای هوش مصنوعی را به خطر بیندازد و مسئولیت را پیچیدهتر کند. چه برای منافع مالی و چه برای ایجاد اختلال، چنین اقداماتی خطر قابل توجهی برای یکپارچگی ابزارهای هوش مصنوعی ایجاد میکند.

همچنین، رابرت پیاسنتین، وکیل کانادایی، اشاره میکند که دادههای آموزشی ناقص یا مغرضانه میتواند منجر به خروجیهایی شود که آسیبزا هستند. اگر یک سیستم هوش مصنوعی بر اساس دادههای آموزشی ناقص، توصیههای نادرست یا مضر ارائه دهد، میتواند زمینه را برای شکایتهای قانونی باز کند. سازمانها باید نه تنها کیفیت خروجیهای هوش مصنوعی خود، بلکه منبع دادههای آموزشی این سیستمها را نیز مورد بررسی قرار دهند.

چه کسی مسئول شکست است؟

وقتی کد تولید شده توسط هوش مصنوعی منجر به نتایج فاجعهبار شود، مسئلهی مسئولیت مبهمتر میشود. اگر یک محصول به دلیل یک کتابخانه یا ماژول معیوب – چه تولید شده توسط انسان و چه توسط هوش مصنوعی – از کار بیفتد، در نهایت چه کسی مسئول است؟ معمولاً مسئولیت بین چندین طرف تقسیم میشود: سازندهی محصول، توسعهدهندهی کتابخانه و سازمانی که تصمیم به ادغام کد گرفته است.

با این حال، ورود هوش مصنوعی به این معادله، پیچیدگیها را بیشتر میکند. در حالی که توسعهدهندگان مسئولیت قابل توجهی در آزمایش و اعتبارسنجی کد تولید شده توسط هوش مصنوعی دارند، دعاوی میتوانند ارائهدهندگان هوش مصنوعی و حتی منابع دادههای آموزشی را هدف قرار دهند. در حال حاضر، شفافیت قانونی وجود ندارد، زیرا موارد کمی در این زمینه بررسی شدهاند. تا زمانی که رویهی مشخصی ایجاد نشود، کسبوکارها و توسعهدهندگان باید با احتیاط عمل کنند.

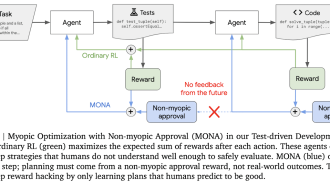

بهترین شیوهها برای مدیریت مسئولیت هوش مصنوعی

در این فضای حقوقی نامشخص، اقدامات پیشگیرانه بسیار مهم هستند:

- آزمایش کامل: توسعهدهندگان باید کد تولید شده توسط هوش مصنوعی را به طور دقیق آزمایش کنند تا از عملکرد و امنیت آن اطمینان حاصل کنند. با خروجیهای هوش مصنوعی به عنوان مقدماتی رفتار کنید که نیاز به بررسی دقیق دارند.

- درک مجوز: از مسائل مربوط به مجوزهای احتمالی مرتبط با محتوای اختصاصی یا دارای حق چاپ آگاه باشید. از استفاده از کدی که منشأ آن مشخص نیست، خودداری کنید.

- نظارت بر دادههای آموزشی: سازمانهایی که از مدلهای هوش مصنوعی سفارشی استفاده میکنند، باید مجموعه دادههای آموزشی خود را از نظر سوگیری یا نادرستی بررسی کنند.

- آمادگی قانونی: با کارشناسان حقوقی مشورت کنید تا میزان مسئولیت خود را درک کرده و سیاستهای روشنی برای استفاده از ابزارهای هوش مصنوعی ایجاد کنید.

نگاه به آینده

با ادامهی انقلاب هوش مصنوعی در توسعه نرمافزار، سوالات مربوط به مسئولیت همچنان مطرح خواهند بود. توسعهدهندگان و سازمانها باید با احتیاط در این چالشها گام بردارند و نوآوری را با مسئولیتپذیری هماهنگ کنند. در حال حاضر، بهترین راهکار، آگاه ماندن، آزمایش دقیق و آمادگی برای شرایطی است که رویههای قانونی هنوز در حال تکامل هستند.

با درک این خطرات و انجام اقدامات احتیاطی مناسب، کسبوکارها میتوانند از پتانسیل تغییر دهندهی هوش مصنوعی بهره ببرند و همزمان ریسکهای حقوقی را به حداقل برسانند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: zdnet