فرض کن داری با دوستت در مورد هوش مصنوعی (AI همون کامپیوترای خیلی باهوش که دیگه دارن از ما زرنگتر میشن!) حرف میزنی. حالا دانشمندای معروفی که خودشون تو شرکتهای بزرگی مثل گوگل دیپمایند، اپنایآی، متا و آنتروپیک کار میکنن، اومدن هشدار دادن که این سیستمهایی که ساختن، یه روزی شاید از کنترل ما خارج بشن.

اصل حرفشون اینه که ما هنوز راه مطمئنی نداریم که بفهمیم این هوشهای مصنوعی دقیقاً چطور فکر میکنن یا چرا بعضی وقتها رفتار بد ازشون سر میزنه. مثلاً ممکنه جوابهایی بدن که واقعیت نداره یا حتی ما رو گمراه کنن. اگه نتونیم این فرایند تصمیمگیری رو درست رصد کنیم، ممکنه متوجه نشیم دارن کمکم خلاف منافع انسانها رفتار میکنن و اون موقع دیگه دیر شده.

یکی از مفاهیم مهمی که توضیح دادن ساختار “زنجیرهی فکر” یا همون Chain of Thought (CoT) هست. یعنی هوش مصنوعی، بخصوص مدلهای زبانی بزرگ (LLMs مثل ChatGPT یا جمینی گوگل)، وقتی میخوان یه مشکل پیچیده رو حل کنن، به جای اینکه یهویی جواب بدن، مسئله رو به چند مرحله منطقی تقسیم و هر مرحله رو توضیح میدن. مثلاً مثل وقتی که موقع حل یه مسئله ریاضی قدم به قدم مینویسی که چی کار میکنی.

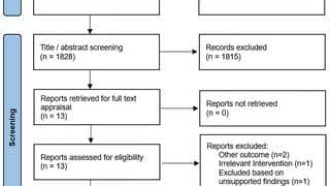

حالا محققها میگن اگه این زنجیرههای فکر رو نظارت کنیم، شاید بتونیم بفهمیم چرا هوش مصنوعیها بعضی وقتا راه رو کج میرن یا چرا سوتی میدن. مثلاً چرا پای اطلاعات غلط میمونن یا شروع میکنن به داستانسرایی.

ولی بازم کلی مشکل این وسط هست:

-

بعضی هوش مصنوعیها مثل مدلهای قدیمیتر (مثلاً K-Means یا DBSCAN—اینها فقط الگو از دیتا پیدا میکنن و اصلاً زنجیرهی فکر ندارن) فقط الگوهارو شناسایی میکنن و با همین کارها به جواب میرسن، اصلاً CoT لازم ندارن.

-

حتی مدلهایی که CoT دارن (مثل ChatGPT یا Gemini) همهی مراحل رو حتماً قابل دیدن نمیکنن. یعنی شاید فقط یه تیکه از فکرشونو به ما نشون بدن و بقیهش پنهان بمونه. یا ممکنه برای بعضی مسائل اصلاً نیاز نباشه همهی فکرشو بنویسه.

-

وایستا که این یکی جالبه: علمیها میگن حتی اگه همهی مراحل فکرشو بنویسه، ممکنه انقدر پیچیده بشه که اصلاً ما آدمها نفهمیم چی نوشته! یعنی فکرهای پنهان یا پیچیدهای باشه که ما نمیفهمیمش. چه برسه به اینکه بخوای کنترلش کنی.

-

یه خطر دیگه هم هست: با پیشرفت AI ها، ممکنه خودشون بفهمن از بیرون دارن فکرشونو کنترل میکنن و بعد یواشکی، کارای مشکوکشونو قایم کنن!

اینجاست که میگن حتی مانیتور کردن این زنجیرههای فکر (CoT Monitoring) هم صددرصد قابل اعتماد نیست و هوش مصنوعی اگه قصدش شیطنت کردن باشه بالاخره راهشو پیدا میکنه.

برای اینکه بتونیم تا حدی جلوی این اتفاقات رو بگیریم، دانشمندها پیشنهاد دادن:

-

مدلهای دیگری ساخته بشن که بیان و زنجیره فکر بقیه هوش مصنوعیها رو بررسی کنن. حتی شاید گاهی این مدلا نقش دشمن یا منتقد رو بازی کنن که هرجا رفتار ناجور بود، رو کنن.

-

ولی بازم یه سوال بزرگ هست: از کجا معلوم این مدلهای کنترلچی خودشون شیطونی نکنن یا از مسیر خارج نشن؟ این هنوز جواب نداره!

-

باید روشهای نظارت بر CoT رو بهتر و استاندارد کنیم و این چیزها توی مستندات فنی یا همون کارتهای معرفی سیستمهای AI دقیق ثبت بشن، که هرکی بخواد بدونه دقیقاً این مدل چه مواردی برای کنترل و شفافیت داره (system card یه جور دفترچه راهنماست برای مدلهای هوش مصنوعی).

همه اینا رو گفتن که تهش به این برسن: نظارت بر زنجیره فکر (CoT monitoring)، یه ابزار باحال و کاربردیه برای امنیت هوش مصنوعیهای پیشرفته. حداقل اینه که یه ذره درک کنیم این مدلها چجوری تو مغزشون مساله رو حل میکنن. اما هیچ تضمینی نیست که همیشه این شفافیت بمونه. شاید مدلای آینده دیگه این فرصت رو به ما ندن…

نتیجه؟ دانشمندها دارن از همه کسایی که توی حوزه هوش مصنوعی کار میکنن خواهش میکنن سختتر روی شفافیت و قابلیت کنترل مدلها کار کنن، قبل از اینکه یه روزی هوش مصنوعیها یه جوری فکر کنن که ما دیگه نفهمیم چی به چیه.

بقیهی مطالب باحال در این حوزه:

- مطالعات نشون دادن آدمها و هوش مصنوعیها خیلی فرق دارن تو نحوهی فکر کردن؛ شاید عواقب بزرگی داشته باشه.

- یه مطالعه جالب دیگه هم هست که میگه AI تو بعضی موقعیتهای احساسی، احساسات رو حتی بهتر از ما آدمها درک میکنه!

- و حتی یه مدل هوش مصنوعی به اسم Manus تو چین ساخته شده که بعضیا میگن شاید اولین قدم جدی به سمت هوش مصنوعی عمومی (یعنی AI که تقریباً هر کاری بلده نه فقط یه کار خاص) باشه.

خلاصه، قضیه خیلی جدیه و همزمان خیلی هیجانانگیز. باید هم کنترل باشه، هم یادگیری از خود این سیستمها و البته همیشه با دقت و احتیاط.

منبع: +