حتماً این روزها خیلی شنیدی که هوش مصنوعی (همون AI خودمون) داره روزبهروز قویتر و باهوشتر میشه، در حدی که مارک زاکربرگ (آقای فیسبوک!) گفته تیکه نهایی پازلش اینه که AI حتی از آدمها هم باهوشتر بشه! راستش رو بخواید، زاکربرگ توی “Meta Superintelligence Labs” داره سنگ تموم میذاره و حتی برای اینکه نخبههای هوش مصنوعی رو جذب کنه، پیشنهاد مالی عجیب غریبی داده—حالا فکر کن یه قرارداد صد میلیونی واسه یک نفر!

حالا چیزی که هوش مصنوعی رو از بقیه تکنولوژیهای خفن دنیا جدا میکنه اینه که خودش میتونه خودش رو بهتر کنه. مثلاً CRISPR (یه روش ژنتیکی برای ویرایش ژنها) یا راکتورهای همجوشی (اونایی که انرژی هستهای تولید میکنن) نمیتونن خودشون رو آپدیت کنن. ولی LLMها (مدلهای زبانی خیلی بزرگ، مثل ChatGPT و مشابههاش) میتونن حتی کُد کامپیوترهایی که روشون اجرا میشن رو هم سریعتر و بهتر کنن، مدلهای جدید آموزش بدن و حتی ایدههای نویی برای پیشرفت خودشون پیدا کنن.

حالا این وسط، کسایی مثل کریس پینتر از METR (یک سازمان غیرانتفاعی درباره سیاست هوش مصنوعی) میگن خوشبینی بیش از حد ممکنه خطرساز بشه. اگه AI بتونه خودش رو تند و تیزتر کنه، شاید تو کارهایی مثل هک کردن، ساخت سلاح، یا حتی دستکاری افراد هم حرفهای بشه! یه عده هم میگن این روند میتونه منجر به “انفجار هوشمندی” بشه؛ یعنی جایی که AI فوراً بره بالاتر از سطح ذهن بشر.

ولی نترس! حتی اگه خیلی دید منفی نداشته باشیم، مهمه که این مسیر رو جدی بگیریم. کمپانیهایی مثل OpenAI، Anthropic و Google همه واسه تحقیق اتوماتیک هوش مصنوعی توی برنامههای امنیتیشون جا باز کردن. جف کلون هم که پروفسور دانشگاه بریتیش کلمبیا و مشاور گوگل دیپمایند هست، میگه: «این سریعترین مسیر به سمت AI قدرتمنده! شاید مهمترین چیزی باشه که باید بهش فکر کنیم.» تازه خودش و همکاراش یه سری سیستم ساختن که AI خودش بتونه روی خودش کار کنه و چیزهای جدید بسازه!

بیاید با هم ببینیم این هوش مصنوعی از چه راههایی به خودش سرویس میده و قویتر میشه:

۱. افزایش بهرهوری (Productivity)

اولین و سادهترین کاری که LLMها میکنن، کمک به برنامهنویسها تو تولید کده. مثلاً ابزارهایی مثل Claude Code یا Cursor کاری کردن که مهندسها خیلی راحتتر کد بنویسن. جالب اینجاست که ساندر پیچای (رییس گوگل) گفته یکچهارم کل کدهای جدیدشون رو دیگه AI مینویسه! ولی اینم بگم که تو بعضی تحقیقات (مثل یه مطالعه METR)، وقتی برنامهنویسهای حرفهای از این ابزار استفاده میکردن، واقعا کارشون طولانیتر هم شده! یعنی همهجا الزامی نیست که بهرهوری میره بالا. البته شاید اگه روی پژوهشگرهای هوش مصنوعی آزمایش کنن، نتیجه فرق کنه.

۲. بهینهسازی زیرساختها (Optimizing Infrastructure)

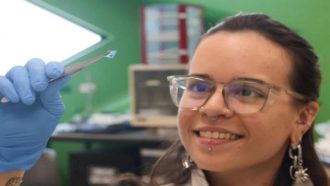

حتی اگه بتونی سریعتر کد بزنی، تازه مصیبته اینه که باید ساعتها منتظر بمونی تا آموزش مدل تموم شه! مدلهای زبانی خیلی بزرگ گاهی واسه هر جواب چند دقیقه وقت میذارن. واسه حل این مسئله، مثلاً دکتر آزالیا میرحسینی (استاد استنفورد و از مدیرهای گوگل دیپمایند) با تیمش یه سیستم ساختن که به کمک AI قطعات چیپها رو جوری بچینه که سرعت بره بالا. حتی گوگل از این الگوریتم تو چند نسل چیپ اختصاصیش استفاده کرده. یه پروژه دیگه به اسم AlphaEvolve تو گوگل اومد سراغ بهبود این چرخه؛ کاری کرد که ۰.۷ درصد از منابع محاسباتی گوگل صرفهجویی بشه و حتی زمان آموزش مدل Gemini رو ۱ درصد کمتر کردن. شاید تو ظاهر کم به نظر بیاد، ولی برای یه شرکت غول مثل گوگل، این یعنی میلیونها دلار صرفهجویی.

۳. اتوماتیک کردن آموزش مدلها (Automating Training)

آموزش مدلهای زبانی بزرگ واقعاً منابع و داده زیادی میبره. تازه تو بعضی موضوعات، مثل زبانهای برنامهنویسی عجیب یا دادههای خاص، واقعاً اطلاعات زیادی پیدا نمیشه. واسه همین خیلی از اوقات خود LLMها میان داده فیک و مصنوعی تولید میکنن تا مدلها بهتر آموزش ببینن. یه سبک جالب دیگه هم هست به اسم “LLM as a judge”، یعنی تصمیمگیری اینکه خروجی یه مدل خوبه یا بد رو به جای انسان میدن به خود یه LLM دیگه. مثلاً Anthropic تو «Constitutional AI» از همین ایده استفاده کرده. به این شکل سرعت آموزش زیاد میشه و لازم نیست کلی هزینه انسانی کنیم.

۴. طراحی بهتر ایجنتها (Perfecting Agent Design)

تا الان بیشتر مدلهای زبانی به اسم «ترنسفورمر» (یک ساختار خاص شبکه عصبی که سال ۲۰۱۷ معرفی شد) ساخته میشن، و اکثراً این ایدهها رو انسان ساخته. اما حالا پای LLM-ایجنتها باز شده—که یعنی مدلهایی که خودشون میتونن با محیط تعامل کنن و ابزار لازم رو بردارن. تو این حوزه واقعاً راه برای خلاقیت بازه! مثلاً سیستم «ماشین داروین-گودل» که با همکاری ساکانا AI و جف کلون ساخته شده، خودش دستورالعملها و ابزارش رو تغییر میده تا کارایی بیشتری پیدا کنه. خلاصه خودش رو ارتقا میده و چیزهایی کشف میکنه که ورژنهای اولیه حتی به ذهنشون هم نمیرسید!

۵. سرعت بخشیدن به تحقیق (Advancing Research)

با اینکه LLMها خیلی از مراحل توسعه مدل رو سریعتر کردن، هنوز خیلیا میگن آدمها تو تحقیق و انتخاب سوالات مهم، حرف آخرن. اما جف کلون و تیمش برای این مشکل هم راه حل ساختن: یه سیستم به اسم «AI Scientist» (دانشمند هوشمند مصنوعی) که میگرده تو مقالههای علمی، خودش سوال پژوهشی مطرح میکنه، آزمایش میگیره و نتایجش رو مینویسه! جالب اینکه یه بار یه مقاله نوشت و داد به یکی از کارگاههای کنفرانس بینالمللی یادگیری ماشین (ICML)، و داوراش هم نمره خوبی بهش دادن—حتی اگر نتیجه پژوهشش خیلی جواب نداده باشه. این نشون میده که AI داره آرومآروم وارد فاز ایدهپردازی و پژوهش واقعی میشه.

آیا سوپرهوش مصنوعی (Superintelligence) قراره برسه؟

با این نشونهها بعضیا فکر میکنن فاصله زیادی تا مدلهایی که از همه لحاظ از انسان جلو بزنن نداریم. ولی واقعیت اینه که هنوز خیلی کار داره. مثلاً با اینکه AlphaEvolve تونسته سرعت آموزش یه مدل رو یک درصد زیاد کنه، این تغییر شاید تو روند پیشرفت گوگل خیلی حس نشه. تازه هر بار آپدیت بعدی یه کم سرعت رو بیشتر میکنه و باید دید تا کی این مسیر ادامه داره.

یه نکته مهم اینه که هرچی علم جلوتر میره، دیگه ایدههای آسون کمتر میشه و برای هر کشف جدید باید انرژی بیشتری بذاری—چه انسان، چه AI! یعنی شاید تا وقتی AIها به سطح تحقیق انسانی برسن، همون ایدههای آسون قبلاً کشف شده باشن.

برای فهم اینکه واقعاً تاثیر این خودبهبوددهی AI چقدره، کار آسونی نداریم، چون مدلهای خیلی پیشرفته هنوز تو دسترس عموم نیستن و فقط تو شرکتهای محدود استفاده میشن. اما سازمانهایی مثل METR با اندازهگیری مدت زمانی که سیستمهای AI میتونن وظایف رو مثل آدمها انجام بدن، سرعت پیشرفت رو میسنجن. طبق گزارشها، از سال ۲۰۱۹ این سرعت هر هفت ماه دوبرابر میشده؛ از ۲۰۲۴ این عدد رسیده به هر چهار ماه! یعنی پیشرفت داره تندتر میشه.

البته این افزایش سرعت میتونه به خاطر پول و منابع زیاد توی آزمایشگاههای بزرگ هم باشه، نه لزوماً خودبهبوددهی AI؛ اما بعیده نقش AI رو بشه نادیده گرفت. به طور خلاصه، انتظار داریم یه مدت شاهد پیشرفت سریعتر باشیم؛ فقط سوال اینه که این باد پشت AI تا کی ادامه پیدا می کنه!

منبع: +