تحقیقات جدید نشان میدهد که نوشتههای هوش مصنوعی، از جمله برنامههایی مانند ChatGPT، دارای اثر انگشت سبکی قابل تشخیص هستند. به عبارت دیگر، میتوان **تشخیص اثر انگشت مدلهای زبانی بزرگ** را انجام داد. این امر نه تنها تشخیص متن تولید شده توسط هوش مصنوعی، بلکه شناسایی مدل زبانی بزرگ خاص مورد استفاده را نیز ممکن میسازد.

پیشرفت سریع و پذیرش گسترده مدلهای زبانی بزرگ (LLM) مانند ChatGPT، انقلابی در نحوه ایجاد و مصرف محتوای نوشتاری ایجاد کرده است. در حالی که این ابزارهای قدرتمند پتانسیل باورنکردنی برای کاربردهای مختلف ارائه میدهند، چالشهای جدیدی را نیز به ویژه در زمینههایی مانند صداقت تحصیلی و انتشار اطلاعات نادرست ایجاد میکنند. یک مطالعه پیشگامانه به رهبری محققان دانشگاه جانز هاپکینز، کشف مهمی را آشکار کرده است: متن تولید شده توسط هوش مصنوعی، مانند نوشته انسان، دارای اثر انگشت سبکی منحصر به فردی است که میتوان از آن نه تنها برای تشخیص منشأ مصنوعی آن، بلکه برای شناسایی LLM خاص مسئول ایجاد آن نیز استفاده کرد. این پیشرفت پیامدهای گستردهای برای مبارزه با سرقت ادبی، شناسایی منابع اطلاعات نادرست آنلاین و توسعه حفاظهای قویتر در برابر سوء استفاده از فناوریهای نوشتاری هوش مصنوعی دارد.

تیم تحقیقاتی به رهبری نیکلاس اندروز، دانشمند ارشد تحقیقات در مرکز تعالی فناوری زبان انسانی جانز هاپکینز، ابزار جدیدی را توسعه داده است که قادر به تشخیص تفاوتهای ظریف سبکی است که متن تولید شده توسط هوش مصنوعی را از نوشته انسان متمایز میکند. علاوه بر این، این ابزار میتواند متن تولید شده توسط هوش مصنوعی را به طور دقیق به LLMهای خاص نسبت دهد و به طور مؤثر برنامه «نویسنده» را شناسایی کند. این قابلیت جهش قابل توجهی در زمینه تشخیص و انتساب متن هوش مصنوعی است.

اندروز توضیح میدهد: «ما اولین کسانی هستیم که نشان میدهیم متن تولید شده توسط هوش مصنوعی ویژگیهای مشابهی با نوشته انسان دارد و میتوان از این ویژگیها برای تشخیص قابل اعتماد آن و نسبت دادن آن به مدلهای زبانی خاص استفاده کرد.» این کشف از این مشاهده ناشی میشود که همانطور که نویسندگان انسانی سبک نوشتاری متمایزی دارند که توسط تجربیات فردی و ترجیحات زبانی شکل گرفته است، LLMها نیز الگوهای منحصر به فردی در متن تولید شده خود نشان میدهند. این الگوها، مانند اثر انگشت سبکی، میتوانند شناسایی شوند و برای تمایز بین LLMهای مختلف و نویسندگان انسانی مورد استفاده قرار گیرند.

انگیزه این تحقیق از نگرانیها در مورد پتانسیل سوء استفاده از فناوریهای نوشتاری هوش مصنوعی ناشی شده است. پس از انتخابات ۲۰۱۶ و تمرکز بعدی بر کمپینهای نفوذ خارجی در رسانههای اجتماعی، اندروز شروع به بررسی راههایی برای مبارزه با اطلاعات نادرست آنلاین کرد. توسعه ابزاری برای تشخیص و انتساب متن تولید شده توسط هوش مصنوعی به عنوان گامی حیاتی در این تلاش پدیدار شد. اندروز میگوید: «اکنون ما این چکش را داریم که سالها صرف ساخت آن کردیم و میتوانیم از آن برای تشخیص آنچه آنلاین جعلی است و چه چیزی جعلی نیست استفاده کنیم. نه تنها این، ما میتوانیم بفهمیم که آیا ChatGPT بوده یا Gemini یا LLaMA، زیرا هر کدام اثر انگشت زبانی دارند که آنها را نه تنها از نویسندگان انسانی، بلکه از سایر نویسندگان ماشینی نیز جدا میکند.»

تیم تحقیقاتی از این یافته که هر برنامه نوشتاری هوش مصنوعی دارای سبک متمایزی است، شگفت زده شد. در ابتدا، آنها تصور میکردند که همه متنهای تولید شده توسط ماشین دارای یک اثر انگشت زبانی عمومی مشترک هستند. با این حال، یافتههای آنها نشان داد که LLMهای مختلف نشانگرهای سبکی منحصر به فردی از خود نشان میدهند که امکان شناسایی آنها را فراهم میکند.

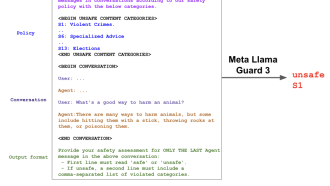

این ابزار تشخیص، که بر روی مجموعه دادههای وسیعی از نمونههای نوشتاری ناشناس از Reddit آموزش داده شده است، در چندین زبان کار میکند. این ابزار به صورت رایگان برای استفاده عمومی و دانلود در دسترس است و تاکنون با حدود ۱۰،۰۰۰ دانلود، مورد توجه قابل توجهی قرار گرفته است. در حالی که سیستمهای تشخیص نوشتاری هوش مصنوعی دیگری نیز وجود دارند، این ابزار جدید به دلیل دقت و سازگاری برتر خود متمایز است و آن را قادر میسازد تا با چشمانداز به سرعت در حال تحول فناوریهای نوشتاری هوش مصنوعی همگام باشد.

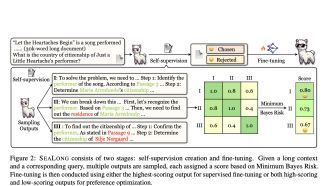

توسعه این ابزار از زبانشناسی قانونی الهام گرفته شده است، رشتهای که زبان نوشتاری را برای اهداف تحقیقاتی تجزیه و تحلیل میکند. اندروز توضیح میدهد: «مأموران اجرای قانون این مفهوم را ابداع کردند، یادداشتهای باجخواهی و سایر نوشتههای مجرمان مظنون را تجزیه و تحلیل کردند و سعی کردند آن را با افراد مطابقت دهند.» رویکرد این تیم اساساً این مفهوم را افزایش میدهد و از قدرت شبکههای عصبی برای شناسایی خودکار ویژگیهای زبانی متمایز در متن استفاده میکند.

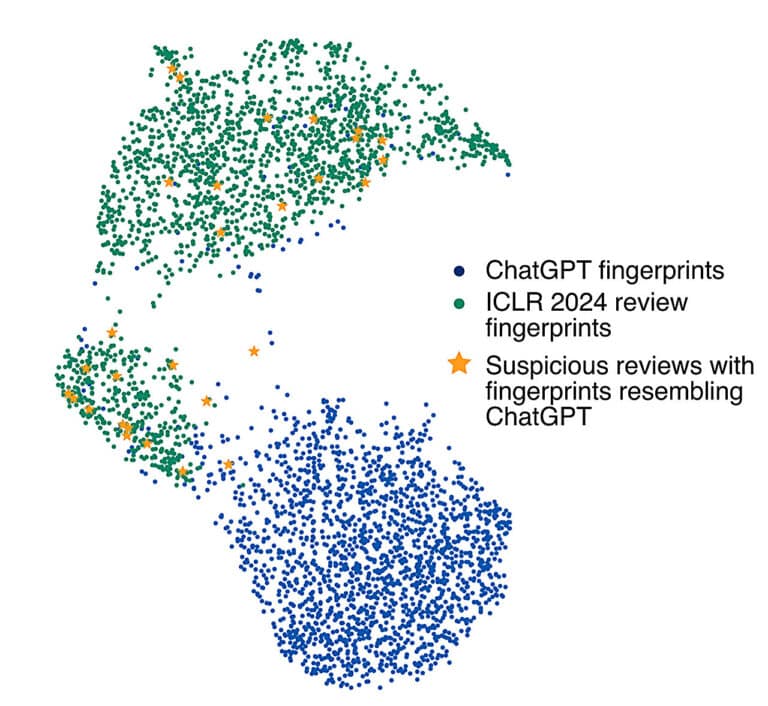

اثربخشی ابزار تشخیص به طور چشمگیری در کنفرانس بینالمللی نمایشهای یادگیری، جایی که تحقیق ارائه شد، نشان داده شد. نویسنده اصلی، رافائل ریورا سوتو، دانشجوی دکترای سال اول در جانز هاپکینز، تمام بررسیهای همتایان را از کنفرانس از طریق آشکارساز اجرا کرد. نتایج نشان داد که تقریباً ۱۰ درصد از بررسیها احتمالاً توسط ماشین تولید شدهاند و به احتمال زیاد توسط ChatGPT تولید شدهاند.

این تحقیق پیامدهای قابل توجهی برای زمینههای مختلف، از آموزش گرفته تا امنیت سایبری دارد. توانایی تشخیص و انتساب متن تولید شده توسط هوش مصنوعی میتواند به مربیان در شناسایی موارد سرقت ادبی، مبارزه با انتشار اطلاعات نادرست آنلاین و افزایش امنیت پلتفرمهای آنلاین کمک کند. با ادامه تکامل فناوریهای نوشتاری هوش مصنوعی، توسعه ابزارهای قوی تشخیص و انتساب نقش مهمی در تضمین استفاده مسئولانه و اخلاقی از آنها خواهد داشت.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techxplore.com