تا حالا به این فکر کردی که اگه یکی بیاد از یه هوش مصنوعی مثل Claude بپرسه چطور بمب هستهای بسازه چی میشه؟ خب، خبر خوب اینه که شرکت Anthropic یه سیستم هوشمند راه انداخته که دقیقاً جلوی همین اتفاق رو میگیره. یعنی اگه کسی بخواد با سوالهای زرنگبازی، AI رو گول بزنه تا نقشه ساخت بمب یا اطلاعات خطرناک دیگه رو بگیره، این سیستم سریعاً تشخیص میده و بلاکش میکنه.

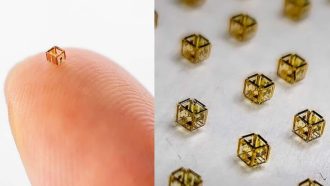

حالا این سیستم چطور کار میکنه؟ Anthropic با همکاری وزارت انرژی آمریکا (همون Department of Energy که به اختصار DoE گفته میشه – یه سازمان مهم دولتی تو حوزه انرژی، مخصوصاً انرژی هستهای) و بخش National Nuclear Security Administration (که خلاصهش میشه NNSA و مسئول امنیت هستهای کشوره)، یه مدل جدید ساخته که خیلی هوشمند عمل میکنه. این مدل، تشخیص میده که یه سوال درباره علم هستهای عادیه یا داره به سمت ساخت بمب انحراف پیدا میکنه.

مثلاً اگه کسی بیاد بپرسه انرژی هستهای چطور به کار پزشکیا میاد یا درباره داستان نیروی برق هستهای سؤال کنه، اوکیه. حتی سوالای کنجکاوانه درباره اینکه سوخت هستهای چی بهتره یا فرق توریم و اورانیوم چیه هم مشکلی نداره. اما اگه ماجرا ببره سمت نقشه و مرحلهبهمرحله ساخت تسلیحات، سیستم سریع هشدار میده و جلوی جواب دادن Claude رو میگیره.

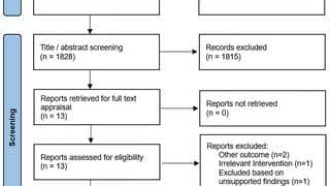

Anthropic گفته که این سیستم دقتی در حدود ۹۶ درصد داره و تونسته تو تستای واقعی، سوءاستفادههای زیادی رو شناسایی کنه. یعنی حتی اگه یکی با سوالهای خفن و رندانه هم وارد بشه، به احتمال خیلی زیاد محتوای خطرناک رو رد میکنه.

یه نکته مهم: این نگرانی فقط الکی نیست؛ چون بعضیها فکر میکنن هوش مصنوعی میتونه به منابع خیلی خاص و حساس دسترسی داشته باشه و شاید تصادفی یا عمدی اطلاعات خطرناک به کسی بده. حتی گاهی آدمها با سوالاتی که به ظاهر عادی و علمی هستن، غیرمستقیم دنبال راه ساخت اسلحه هستن (به این کار میگن veiled attempt یعنی تلاش مخفیانه یا زیرزیرکی)، و Anthropic با این ابزار جدیدش جلو این بازیها رو گرفته.

از طرف دیگه، یه بحث وجود داره درباره اینکه دادههای هستهای همیشه یه مرز باریکی دارن. یعنی همون دانشی که لازمه برای ساخت نیروگاه سالم، اگه یه کوچولو منحرف شه میتونه تبدیل به دستور ساخت بمب بشه. اینجاست که اهمیت مدل Anthropic و همکاری NNSA بیشتر دیده میشه. این دوتا تونستن سیستمی بسازن که دقیق درک کنه فرقِ “فیزیک هستهای” با “مراحل عملی ساخت بمب” چیه و اشتباه نگیره.

Anthropic میخواد این تجربه رو با باقی شرکتهای بزرگ هوش مصنوعی هم به اشتراک بذاره تا روزی برسه که هیچ AI نتونه برای ساخت سلاح مورد سوءاستفاده قرار بگیره. (یه گروهی هم به اسم Frontier Model Forum هست که چندتا از بهترین شرکتای هوش مصنوعی دنیا اونجان و دارن درباره امنیت مدلهای پیشرفته بحث میکنن.)

در آخر یه چیزو مطمئن باش: Claude هیچگاه طرف کسایی که دنبال ساخت بمبان، نمیره و کارش آموزش، ایدهبازی و کمکای خلاقانهست. پس اگه نفست دنبال کمک گرفتن برای یه ساندویچ خوشمزه یا دونستن درباره درمانهای هستهایه، خیالت راحت باشه؛ اما اگه میخوای خونتو تبدیل به آزمایشگاه مخفی کنی، Claude هوشیارتر از اونه که خامت بشه!

منبع: +