آزمون ARC-AGI، که برای سنجش هوش مصنوعی عمومی طراحی شده، نمرات بهبود یافتهای را نشان میدهد. با این حال، طراحان آزمون معتقدند که این بهبود بیشتر نشاندهندهی کاستیهای خود آزمون ARC-AGI است تا پیشرفت واقعی در حوزهی هوش مصنوعی عمومی. این موضوع، پرسشهایی را دربارهی چگونگی ارزیابی پیشرفت به سوی هوش عمومی واقعی مطرح میکند و اهمیت توسعهی معیارهای دقیقتر برای سنجش ARC-AGI و هوش مصنوعی عمومی را برجسته میسازد.

جستجوی هوش عمومی مصنوعی (Artificial General Intelligence: AGI) مدتهاست که توجه محققان و عموم را به خود جلب کرده است. یکی از چالشهای اساسی، تعریف و سنجش پیشرفت در راستای دستیابی به این هدف بلندپروازانه است. معیار ARC-AGI، مخفف “Abstract and Reasoning Corpus for Artificial General Intelligence”، در سال ۲۰۱۹ توسط فرانسوا چالت، از چهرههای برجستهی هوش مصنوعی، به عنوان یک راهکار بالقوه ارائه شد. هدف این معیار، ارزیابی توانایی یک سیستم هوش مصنوعی در یادگیری مهارتهای جدید فراتر از دادههای آموزشیاش بود، مهارتی که نشانهای از هوش واقعی است. با این حال، تحولات اخیر، بحثهایی را دربارهی کارایی آزمون و اینکه آیا عملکرد بهتر، واقعاً نشاندهندهی پیشرفت به سوی هوش عمومی مصنوعی است، برانگیخته است.

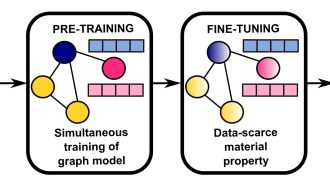

معیار ARC-AGI شامل چالشهایی شبیه به پازل است که با شبکههایی از مربعهای رنگی نمایش داده میشوند. سیستمهای هوش مصنوعی باید این شبکهها را تحلیل کرده و بر اساس مجموعهای از قوانین استنتاجی، شبکهی “پاسخ” صحیح را تولید کنند. این وظایف به عمد طوری طراحی شدهاند که هوش مصنوعی را وادار به انطباق و استدلال در موقعیتهای جدید کنند، مشابه روشی که انسانها یاد میگیرند و دانش خود را در مسائل ناآشنا به کار میبرند. در ابتدا، عملکرد هوش مصنوعی در ARC-AGI چندان چشمگیر نبود. تا همین اواخر، بهترین سیستمها تنها میتوانستند کمی کمتر از یک سوم وظایف را حل کنند، که منجر به انتقاد چالت از تمرکز صنعت بر مدلهای زبانی بزرگ (Large Language Models: LLMs) شد. او استدلال کرد که LLMs، با وجود تواناییهای قابل توجهشان در زمینههایی مانند تولید متن و ترجمه، به شدت به حفظ کردن اطلاعات وابستهاند و در تعمیم دادن واقعی با مشکل مواجه هستند. او اشاره کرد که LLMs در شناسایی الگوها در دادههای آموزشی گستردهی خود بسیار خوب عمل میکنند، اما وقتی با سناریوهایی خارج از این الگوها روبرو میشوند، عملکرد ضعیفی از خود نشان میدهند. چالت معتقد بود که این نشاندهندهی فقدان توانایی استدلال واقعی است.

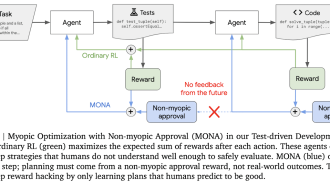

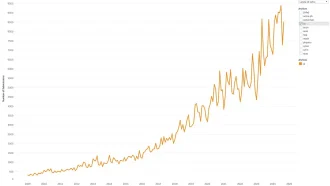

برای تشویق تحقیقات فراتر از LLMs و ترغیب رویکردهای نوآورانه به هوش عمومی مصنوعی، چالت و مایک نوپ، یکی از بنیانگذاران Zapier، در ژوئن ۲۰۲۴ یک مسابقهی ۱ میلیون دلاری راهاندازی کردند. هدف، توسعهی یک هوش مصنوعی متن باز بود که بتواند از نمرات ARC-AGI موجود پیشی بگیرد. این مسابقه با استقبال خوبی روبرو شد و بهترین عملکرد، امتیاز ۵۵.۵٪ را کسب کرد که پیشرفت قابل ملاحظهای نسبت به بهترین عملکرد سال قبل بود. در حالی که این ممکن است نشاندهندهی یک جهش بزرگ باشد، هم چالت و هم نوپ نسبت به چنین برداشتی هشدار میدهند. آنها معتقدند که بسیاری از آثار ارسالی موفق، از نقاط ضعف خود آزمون سوءاستفاده کردهاند و در واقع به جای نمایش استدلال واقعی، راهحلها را به صورت “brute-force” به دست آوردهاند. نوپ در یک پست وبلاگ فاش کرد که بخش قابل توجهی از وظایف ARC-AGI به طور مؤثر هوش عمومی را نمیسنجند و به نمرات کاذب کمک میکنند. این درک منجر به این اعتراف شد که معیار ARC-AGI، اگرچه در نیت خود پیشگامانه است، نیاز به بازنگری دارد.

محدودیتهای معیار ARC-AGI فراتر از مسئلهی راهحلهای brute-force است. تعریف خود هوش عمومی مصنوعی همچنان موضوع بحثهای پیگیری است و ارزیابی پیشرفت را دشوارتر میکند. برخی از محققان، از جمله یکی از کارکنان OpenAI، اظهار داشتهاند که هوش عمومی مصنوعی ممکن است در حال حاضر، بسته به تعریفی که انتخاب میشود، در دسترس باشد. این دیدگاه با تأکید چالت بر استدلال واقعی و انطباقپذیری به عنوان مؤلفههای اصلی هوش عمومی مصنوعی در تضاد است. طراحان ARC-AGI به دلیل احتمالاً بزرگنمایی بیش از حد معیار به عنوان معیار قطعی پیشرفت به سوی هوش عمومی مصنوعی، به ویژه با توجه به ابهام پیرامون خود این اصطلاح، مورد انتقاد قرار گرفتهاند. با این حال، آنها نیاز به بهبود را پذیرفته و به طور فعال بر روی نسل دوم معیار ARC-AGI، همراه با یک مسابقهی مرتبط که برای سال ۲۰۲۵ برنامهریزی شده است، کار میکنند. این معیار اصلاح شده با هدف رفع کاستیهای شناسایی شده و ارائه ارزیابی دقیقتری از پیشرفت به سوی هوش عمومی واقعی طراحی شده است.

چالشهای پیش آمده با معیار ARC-AGI، پیچیدگیهای ذاتی ارزیابی پیشرفت هوش مصنوعی به سوی هوش عمومی را آشکار میکند. تعریف و سنجش هوش، چه در انسان و چه در ماشین، کاری بسیار پیچیده است. بحثهای جاری پیرامون هوش عمومی مصنوعی و محدودیتهای معیارهای فعلی، نیاز به اصلاح و کاوش مستمر در پیگیری این هدف بلندپروازانه را برجسته میکند. توسعهی ARC-AGI، با وجود کاستیهای اولیهاش، گامی ارزشمند در این مسیر طولانی است. این معیار، گفتگوهای مهمی را برانگیخته، تحقیقات نوآورانه را تشویق کرده و راه را برای معیارهای جامعتر در آینده هموار کرده است. تلاش برای هوش عمومی مصنوعی ادامه دارد و درسهای آموخته شده از ARC-AGI بیشک مسیر پیش رو را شکل خواهد داد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techcrunch