ببین، این روزا مدلهای دیپ لرنینگ کلی سروصدا راه انداختن تو دنیای پزشکی، مخصوصاً وقتی حرف از درمان شخصیسازی شده میشه. یعنی چی؟ یعنی این هوش مصنوعیا میتونن کمک کنن تا دکترها تصمیمات دقیقتر و حرفهایتری بگیرن، چون مدلها حسابی دادهمحورن و میتونن پیشنهاد بدن که چه کاری مناسبه. اما یه دردسر گنده دارن: همیشه نمیتونن واقعا درست پیشبینی کنن! مخصوصاً وقتی با دادههایی سروکار دارن که قبلاً تو آموزش مدل نبودن. اصلاً به این مدل دادهها میگن out-of-distribution، یعنی دادههای عجیب غریب یا جدید برای مدل.

حالا مشکل بزرگ چیه؟ اینکه این مدلها اغلب خیلی مطمئن رفتار میکنن حتی وقتی نباید! یعنی ممکنه تو شرایطی که خود مدل هیچ تجربهای نداره، با اعتماد به نفس بالا جواب بده. اینجاست که اصطلاح epistemic uncertainty میاد وسط؛ یعنی عدم قطعیت ناشی از کمبود دانش مدل درباره چیزهایی که قبلاً ندیده، نه اینکه ورودی خرابه یا دادهها اشتباهن.

برای همین دانشمندها اومدن دنبال راههایی که مدلها علاوه بر پیشبینی، بگن چقدر نسبت به پیشبینیشون مطمئن هستن. اینارو بهش میگن uncertainty quantification یا همون مقدار عدم قطعیت. یکی از روشهای محبوب تو این زمینه سمت حالت بیزی Bayesian رفته؛ یعنی مثلا به جای یه جواب قطعی، یه بازه جواب میدن و احتمال هر حالت رو هم تعیین میکنن. تو دنیاش به این میگن Approximate Bayesian Deep Learning. خلاصه بگم: مدل نه فقط میگه جواب چیه، بلکه میگه چقدر خودش رو قبول داره!

حالا تو یه تحقیقی (که این مقاله خلاصهش میکنیم)، رفتن سراغ پیشبینی مرگ بهخاطر سرطان پروستات، اونم با دادههای یه آزمایش معروف به اسم PLCO cancer screening trial. اومدن سه مدل مختلف رو مقایسه کردن که هر سهشون از این روشهای تخمین عدم قطعیت استفاده میکنن.

جالبیش اینه که هر سه مدل، تو خود دادههایی که باهاشون آموزش دیده بودن، خیلی خوب جواب دادن (شاخص AUROC شون برابر با 0.86 بود، که یعنی مدل واقعاً کارش درسته). AUROC رو اگه نمیدونی، یه جور معیار برای عالی یا متوسط بودن مدلهای پیشبینیه. اما داستانِ تفاوتشون تو میزان اعتماد به جوابی که میدن خودشو نشون میده؛ یعنی همون تخمین عدم قطعیت.

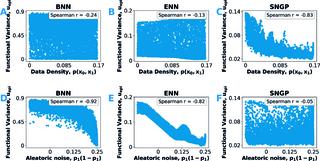

دو مدل اول که بهشون میگن implicit functional-prior methods، مثلا مثل neural network ensemble (یعنی چند تا شبکه عصبی مختلف که با هم نظر میدن) یا factorized weight prior variational Bayesian neural networks (که یعنی مدلهایی که حسابی با احتمال سر و کار دارن و وزنای شبکه رو بر اساس احتمالات میذارن)، وقتی میرن سراغ تخمین عدم قطعیت، نتایجشون یکم رو هواست! یعنی مثلاً اعتماد یا بیاعتمادیشون یه جورایی اغراقشده یا کم و زیاد است و به خوبی نشون نمیدن مدل چقدر مطمئنه.

اما یه مدل سوم بود که تهش بیشتر بهش اعتماد کردیم! اسمش Spectral-Normalized Neural Gaussian Process یا خلاصه SNGP هست. این چیه؟ یه مدل شبکه عصبیه که یکم متفاوت فکر میکنه؛ یعنی تو معماریش صراحتاً فاصله بین دادهها رو حساب میکنه و بر همین اساس به عدم قطعیت نگاه میکنه. یعنی هر ورودی جدید رو نسبت به دادههای قبلی که تو آموزش یاد گرفته میسنجه و متناسب با نزدیکی یا دور بودنش بهش اعتماد میکنه یا نه! به این میگیم explicit distance-aware prior؛ یعنی مدل دقیقاً میدونه هر داده چقدر از دادههای قبلی دوره و بر همین اساس رفتار میکنه.

نتیجه این شد که مدل SNGP خیلی بهتر تخمین عدم قطعیت رو انجام بده؛ یعنی وقتی یه مریض با شرایط جدید بیاد سراغش، مدل میتونه واقعاً تشخیص بده “درباره این مورد، اطلاعات کافی ندارم، پس بهتره خیلی مطمئن نباشم”. این برای تصمیمگیری تو پزشکی حیاتی و فوقالعاده مهمه.

در کل، پیغام مقاله اینه: اگه فقط به پیشبینی دقیق مدل نگاه کنیم کافی نیست؛ مدل باید بلد باشه به ما بگه کجاها مطمئنه، کجاها باید احتیاط کنیم و به پزشک هشدار بده! مدلهایی که با صراحت و براساس فاصله (distance-aware) به داده و عدم قطعیت نگاه میکنن—مثل همین SNGP— خیلی امیدبخشترن برای آینده ابزارهای هوش مصنوعی در پزشکی. پس دفعه بعدی که هوش مصنوعی بهمون گفت این دارو جواب میده یا نه، حواسمون باشه اول بپرسیم: داداش، چقدر مطمئنی؟!

منبع: +