خب بیا یه کم درباره موضوع باحال و جدی حرف بزنیم: اینکه چطوری هوش مصنوعی داره کمک میکنه راه رفتن بیماران پارکینسون رو بهتر بشه تحلیل و تفسیر کرد، ولی یه سری مشکلات هم این وسط وجود داره که باید حل بشه.

اصلاً ماجرا چیه؟ هوش مصنوعی و ابزارهایی که به این پزشکها داده میشه (مثلاً همون داشبوردهای اطلاعاتی)، یه عالمه دیتا از سنسورهای پوشیدنی میگیرن و تلاش میکنن تشخیص بدن وضعیت حرکتی بیماران پارکینسونی در چه حالیه. فازش اینه که تو پارکینسون، مشکلات حرکتی خیلی مهمه – و اینکه پزشک بتونه دقیق و شفاف بفهمه سیستم هوش مصنوعی چه جوری به این نتیجه رسیده، حسابی ارزشمنده.

ولی مشکل اینجاست که خیلی از این هوش مصنوعیها فقط جواب رو تحویل میدن اما توضیحی نمیدن چرا به اون نتیجه رسیدن، یا حتی به پزشکها این حق رو نمیدن که پاسخها رو زیر سؤال ببرن یا چک کنن. “Contestable AI” یعنی هوش مصنوعیای که اجازه میده کاربر (اینجا همون پزشک) بتونه با نتیجه بحث کنه یا اونو به چالش بکشه و شفافیت داشته باشه.

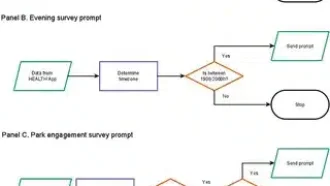

توی این مقاله درباره یه چارچوب جدید به اسم Motion2Meaning صحبت شده که با محوریت پزشک طراحی شده و قراره دقیقاً این شکاف رو پر کنه. این سیستم چند بخش اصلی داره:

۱. “Gait Data Visualization Interface” که یعنی یه محیط تصویری و گرافیکی که دادههای راه رفتن رو خیلی واضح نشون میده تا پزشک راحتتر بتونه وضعیت رو بفهمه.

۲. یه مدل هوش مصنوعی به اسم “1D Convolutional Neural Network” (یا خلاصش 1D-CNN). این یه نوع شبکه عصبیه که مخصوص دادههای ترتیبی و زمانیه، مثلاً همین دادههای حسگرهای حرکتی. کارش اینه که شدت بیماری رو با توجه به مراحل “Hoehn & Yahr” (یعنی یه سیستم درجهبندی شدت پارکینسون) پیشبینی کنه. جالب اینکه این مدل تونسته با دادههای آزاد PhysioNet حدود ۸۹ درصد امتیاز F1 بگیره که نشون میده تشخیصش خیلی دقیقه. (امتیاز F1 یکی از متریکهایی هست که میزان دقت و کامل بودن پیشبینی رو نشون میده.)

۳. یه رابط کاربری برای تفسیر و اعتراض (Contestable Interpretation Interface یا همون CII) که به معنای واقعی به پزشک این قابلیت رو میده که نتایج مدل رو ببینه و در صورت شک یا ایراد، پیگیری کنه. این بخش از یه ابزار جالب به اسم XMED استفاده میکنه – خلاصش میشه Cross-Modal Explanation Discrepancy که یعنی اختلافهایی که بین توضیحات مدل و واقعیت هست رو تشخیص میده تا اگر مدل اشتباه کرد بفهمیم چرا و چطور. (وقتی نتیجه مدل غلط باشه، این اختلاف ۵ برابر بیشتر میشه!)

مثال: وقتی مدل اشتباه پیشبینی کرده، میزان اختلاف در توضیحات حدود ۷.۴۵٪ بوده، اما وقتی درست عمل کرده ۱.۵۶٪. یعنی عملاً این ابزار میفهمه کجا مدل نامطمئن یا غیرقابل اعتماده.

علاوهبراین، یه LLM (Large Language Model، یعنی مدل زبانی خیلی بزرگ مثل ChatGPT) هم توی سیستم هست که میتونه برای پزشک توضیح شفاف بده، جوابها رو قابل بحث کنه و حتی اگر لازم بود جواب مدل رو زیر سؤال ببره!

این ترکیب باعث شده پزشک بتونه هم به جواب مدل اعتماد کنه (چون دلیلش رو میدونه)، هم اگه بهش شک داشت اعتراض کنه و دلیل بخواد، و هم یه ابزار دم دست برای توضیح و تصحیح داشته باشه.

ارزیابی انسانی این رابط نشون داده که یه چالش مهم اینه که مدل زبانی باید هم درست و مستدل حرف بزنه، هم طوری توضیح بده که برای پزشکها قابل فهم باشه و بشه راحت باهاش تعامل کرد.

در آخر، این همه امکانات باعث شده سیستم Motion2Meaning تبدیل به یه ابزار شفاف، قابل رهگیری و قابل اتکا برای تفسیر حرکت بیماران پارکینسونی بشه – یعنی پزشک کنترل رو از دست نمیده و همیشه میتونه روی مدل نظارت داشته باشه. خلاصه که این چارچوب یه جور پل بین هوش مصنوعی قدرتمند و نیاز به شفافیت و اعتماد تو پزشکیه!

راستی، اگه دلت میخواد خودت ور بری باهاش یا ببینی چیه، همه کدهای پروژه تو گیتهاب موجوده: https://github.com/hungdothanh/motion2meaning

منبع: +