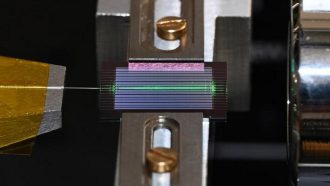

تا حالا عکس زیر آب دیدی که همه چیز تار و مهآلود باشه و معلوم نباشه چی به چیه؟ این مشکل برای کلی آدم و حتی کامپیوترها هم اذیتکنندهست! چون به خاطر پدیدهای مثل جذب نور و پخش شدنش تو آب، عکسهای زیرآبی معمولاً خیلی کیفیت خوبی ندارن و همهچی کمرنگ، بیجون و شبیه خاطرات گمشده میشه.

حالا داستان چیه؟ یه گروه از محققها اومدن با کمک یه مدل اسمارت به نام CLIP سعی کردن این مشکل رو حل کنن. بذار خیلی دوستونه برات توضیح بدم چی کار کردن و اصلاً CLIP چیه!

■ داستان مدل CLIP چیه؟

CLIP یه مدل هوش مصنوعیه که میتونه متن و تصویر رو با هم قاطی کنه و بفهمه چی تو عکسه. یعنی مثلاً وقتی میگی «ساحل زیبا»، مدل میتونه عکسهای مربوط به ساحل رو پیدا کنه یا حتی بفهمه این عکس الان بیشتر به چی شبیهه! خلاصه رو بگو: CLIP تو تحلیل معنای تصویر کلی استعدادی داره و خیلی مورد استفاده قرار میگیره.

■ مشکل روشهای قبلی چی بود؟

تا قبل از این، خیلیا با هوش مصنوعی دنبال این بودن که کیفیت عکس زیرآبی رو ببرن بالا. مثلاً مدل یادگیری عمیق، که یعنی هوش مصنوعی یاد میگیره چطور خودش عکسای بد رو بهتر کنه. اما اکثر این روشها یه چیزی رو فراموش میکنن: دید و سلیقه آدمها! یعنی چی؟ یعنی شاید عکس از نظر تکنیکی خوب شده باشه ولی وقتی خودت میبینی حس خوبی نمیگیری یا مثلاً رنگها مصنوعی شدن. علاوه بر این، این مدلها بعضی وقتها مرز مشخص بین تصویر خوب و بد رو ندارن و نمیتونن درست بسنجن چقدر تقویت کنن.

■ راهحلی که ارائه دادن چی بود؟

این محققها اومدن یه رویکرد جدید معرفی کردن که اسمش رو گذاشتن «تقویت عکس زیرآبی با کمک ادراک مدل CLIP»! این یعنی حالا مرحله به مرحله میخوان از چیزایی که CLIP تو تصویر میبینه، کمک بگیرن تا عکس تقویتشده شبیه همونی باشه که انسان حس میکنه باید باشه.

اونا یه چیزی به اسم “پرپچن لاس” یا ادراکِ از دسترفته تعریف کردن؛ این همون جاییه که مدل بررسی میکنه آیا خروجی واقعا به چیزی که چشم آدمی خوشش میاد نزدیکه یا نه. اینجوری مدل سراغ یه سری ویژگی معنایی و کلیتر از عکس میره و فقط به جزئیات فنی قانع نمیشه.

■ یه تکنیک خفن دیگه که استفاده کردن: Curriculum Contrastive Regularization

یه اسم باکلاس و البته ترسناک D: خلاصه بگم: این تکنیک کمک میکنه مدل یاد بگیره عکسهای مختلف سطح سختی متفاوت دارن. Curriculum یعنی مدل مثل دانشآموز از آسون به سخت جلو میره و contrastive regularization هم یعنی مدل فرق بین عکس درست، عکس اشتباه و عکس خراب رو قشنگ متوجه میشه. این کار باعث میشه مدل هم زیادهروی نکنه (یعنی تصویر رو بیش از حد دستکاری نکنه)، هم وسط راه دست از تقویت نکشه.

همه اینها با هم میشه یه شبکه هوش مصنوعی که هم دیدنِ تصویر رو برای آدمی شیرینتر میکنه و هم وظایف ماشینی مثل تشخیص اشیا زیر آب رو آسونتر و با دقتتر درمیاره.

■ نتیجه؟

طبق آزمایشهایی که کردن، این روش تونسته هم از نظر زیباییشناسی، هم از نظر کاربردی و هم از نظر قدرت تعمیم به انواع تصویرهای جدید، از همه روشهای معروف که قبلاً بودن بهتر باشه! یعنی نه فقط عکس رو شفافتر و رنگیتر نشون میده، بلکه اگه یه عکس زیرآبی جدید بندازی، باز هم عالی عمل میکنه و گیر نمیکنه.

■ جمعبندی خودمونی

کلاً اگه دوست داری دنیای زیر آب رو با کیفیت و رنگ بهتر ببینی یا مدلهای هوش مصنوعی بسازی که عکس رو دقیقتر آنالیز کنن، این مدل CLIP که بهش ماژول ادراکی هم وصله و با تکنیکهای آموزش مرحلهای تقویت شده، خیلی میتونه بهت کمک کنه.

پس دفعه بعد که عکس زیر آب میگیری یا میبینی، یادت باشه پشت بهتر شدنش همچین مغزهای پیچیدهای کار میکنن تا دنیا رو قشنگتر و واضحتر بهت نشون بدن!

منبع: +